Aspectos destacados del Informe anual 2024: el impacto del Consejo en el año de las elecciones

27 de agosto de 2025

Prefacio de los copresidentes

En 2024, el año electoral más importante de la historia moderna, el Consejo asesor de contenido publicó su primer informe oficial. Basándose en el análisis de nuestro trabajo con casos, el informe presentó formas en que las empresas de redes sociales pueden contrarrestar los desafíos para el desarrollo seguro y confiable de las elecciones, al mismo tiempo que protegen la libertad de expresión, guiándose por las normas internacionales sobre derechos humanos. Este enfoque en las elecciones influyó en los casos que seleccionamos el año pasado sobre fraude electoral, información errónea y sátira política. También emitimos una decisión expedita para los casos relacionados con la violencia poselectoral en Venezuela.

Otro tema que el Consejo abordó en 2024, mediante un segundo informe oficial, fue la moderación de contenido en la era de la inteligencia artificial (IA) y la automatización. En el informe, se examinaron el diseño de los sistemas automatizados de Meta y la necesidad de que las plataformas consideren los derechos humanos a nivel global al implementar herramientas de IA, y también se destacaron las recomendaciones que hemos realizado sobre el contenido generado por IA. Una de esas recomendaciones clave, que instó a Meta a etiquetar el contenido creado o alterado por IA, fue adoptada por la empresa en 2024. Consulte el Resumen ejecutivo a continuación para conocer otros cambios que Meta realizó en respuesta a nuestras recomendaciones, las cuales emitimos como parte de nuestras decisiones en los casos.

En cada trimestre de 2024, Meta aceptó e implementó muchas más de nuestras recomendaciones de las que rechazó. Es importante destacar que realizamos esta evaluación utilizando una metodología independiente, la cual exige que Meta proporcione pruebas de que llevó a cabo la implementación.

Desde enero de 2021, hemos realizado más de 300 recomendaciones a Meta. La implementación o el progreso en el 74 % de estas recomendaciones ha redundado en una mayor transparencia, reglas claras y accesibles, mayor equidad para los usuarios y una consideración más profunda de las responsabilidades de Meta en materia de derechos humanos, incluido el respeto a la libertad de expresión.

El equipo de datos del Consejo, que desarrolló nuestro enfoque para dar seguimiento a la implementación, ha trabajado con Meta para comprender mejor el impacto de este trabajo en los usuarios. En 2024, el Consejo recibió los datos más detallados para validar este impacto, los cuales se presentan en la sección Generar cambios en las plataformas de Meta más adelante. Estos datos son una parte fundamental del ciclo de vida de las recomendaciones, ya que permiten entender cómo afecta la orientación del Consejo a las personas y cómo podemos seguir mejorando las plataformas de Meta en beneficio de miles de millones de usuarios y su libertad de expresión.

Evelyn Aswad, Paolo Carozza, Michael McConnell, Pamela San Martín, Helle Thorning-Schmidt

Prefacio del presidente del fideicomiso del Consejo asesor de contenido

Como un modelo único de supervisión de la moderación de contenido global, independiente de las empresas y los gobiernos, la evolución continua del Consejo tiene como objetivo mantenerse al ritmo de los cambios en la industria y el panorama normativo. A punto de cumplir cinco años desde que el Consejo abrió su proceso de apelaciones, resulta notable pensar cómo este experimento se ha transformado en un modelo institucional de gobernanza de contenido independiente, con principios sólidos y alcance global.

En 2024, Meta confirmó una nueva ronda de financiamiento, con una contribución de 30 millones de dólares que reforzó el fideicomiso irrevocable para asegurar el funcionamiento del Consejo hasta 2027. Mientras Meta renovaba su compromiso con la supervisión independiente, el Consejo también tomó medidas para optimizar sus operaciones, aplicando recortes presupuestarios estratégicos con el fin de priorizar los aspectos más impactantes de su labor.

Con la optimización continua en mente, recientemente realizamos cambios en nuestra forma de gobernanza. Al mismo tiempo que garantizamos que el Consejo se mantenga independiente de Meta y del apoyo financiero que la empresa proporciona, adaptamos nuestra estructura para incorporar a los copresidentes al órgano de administración de Oversight Board LLC. De esta manera, creamos un espacio unificado para la estrategia, el presupuesto y las operaciones, con el objetivo de maximizar el impacto del Consejo a largo plazo.

Fomentar la rendición de cuentas nunca ha sido tan importante para generar confianza entre las empresas tecnológicas. El modelo del Consejo y su liderazgo intelectual en cuestiones clave de gobernanza demuestran cómo se puede lograr esto.

Stephen Neal

Resumen Ejecutivo

Desde 2021, el Consejo ha realizado 317 recomendaciones a Meta, de las cuales el 74 % están implementadas, en curso o Meta informa que ya forman parte de su trabajo habitual. En respuesta a estas recomendaciones, Meta realizó los siguientes cambios en 2024 y principios de 2025.

- Comenzó a etiquetar el contenido creado o alterado por IA, para proporcionar información adicional a los usuarios sin restringir de manera indebida la libertad de expresión.

- Unificó sus políticas para que se apliquen de manera uniforme en Facebook, Instagram y Threads, para mejorar la coherencia entre sus plataformas y brindar mayor claridad a los usuarios sobre las reglas.

- Ofreció a los usuarios la posibilidad de evitar una sanción en sus cuentas por su primera infracción de una política aplicable, si completan un ejercicio educativo. Esto ayuda a proteger la libertad de expresión y brinda la oportunidad de aprender por qué sus publicaciones infringieron las normas.

- Permitió que los usuarios proporcionen contexto adicional al apelar contra la eliminación de su contenido por lenguaje que incita al odio, lo que ayuda a limitar la aplicación excesiva en publicaciones satíricas y otros contenidos que podrían beneficiarse de excepciones a la política, como los mensajes de concientización.

- Mejoró los indicadores que proporciona a los moderadores cuando revisan videos de formato largo en busca de posibles infracciones, para lograr una aplicación más precisa de este contenido.

- Completó una auditoría de sus listas de insultos en 22 países con elecciones en 2024, como parte de los esfuerzos para mejorar la precisión en la aplicación de la norma sobre la conducta que incita al odio.

- Actualizó su política sobre personas y organizaciones peligrosas para permitir más libertad de expresión cuando, en ciertos contextos, los usuarios se refieren a personas designadas como “shaheed”. De esta manera, se eliminó la prohibición generalizada de ese término.

- Alineó el lenguaje público de su política de contenido violento y gráfico con las directrices internas para los revisores, para aclarar a los usuarios qué tipo de contenido no está permitido según esta política y aportar mayor transparencia a su aplicación.

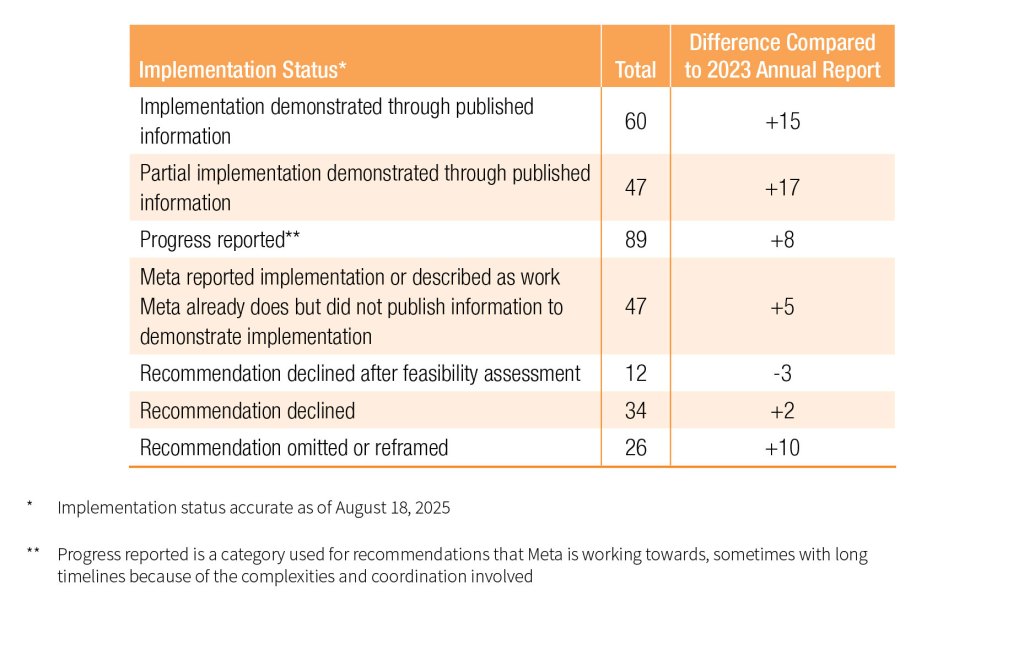

Al desglosar el estado más reciente de implementación por parte de Meta, la tabla que aparece a continuación muestra una tendencia ascendente constante en la implementación total o parcial de las recomendaciones del Consejo, verificada mediante información publicada.

El Consejo continúa examinando la implementación a través de su propio enfoque independiente basado en datos.

Generar cambios en las plataformas de Meta

Además de las decisiones vinculantes que tomamos sobre publicaciones individuales, el Consejo también emite recomendaciones a las que Meta debe responder públicamente en un plazo de 60 días. Estas recomendaciones, que impulsan un mayor respeto por los derechos humanos, así como más transparencia, coherencia y equidad en la moderación de contenido de Meta, están generando un impacto en usuarios y organizaciones de todo el mundo de las siguientes maneras.

- Menores restricciones a la libertad de expresión

En respuesta a una de las recomendaciones del Consejo en el caso del video alterado de Biden, Meta comenzó a etiquetar el contenido creado o alterado por IA en sus plataformas en mayo de 2024. La empresa está incorporando etiquetas de “Contenido generado por IA” a una variedad de videos, audios e imágenes en Facebook, Instagram y Threads, para brindar a los usuarios un contexto importante sobre cómo se creó ese contenido. No todo el contenido manipulado por IA genera daño, y el etiquetado ofrece una alternativa a la eliminación de contenido que no restringe de manera indebida la libertad de expresión.

--- Durante 29 días en octubre de 2024, los usuarios vieron más de 360 millones de contenidos con etiquetas de IA en Facebook y 330 millones en Instagram. De ese total, los usuarios hicieron clic en 6 millones de publicaciones con estas etiquetas en Facebook y en 13 millones de contenidos en Instagram para obtener más información sobre cómo se creó ese contenido.*---

*Toda la información es colectiva y anonimizada para proteger la privacidad del usuario. Todos los parámetros son cálculos aproximados basados en la mejor información disponible actualmente correspondiente a un momento específico.

- Prevención de sanciones y restricciones en cuentas

Ahora los usuarios tienen la oportunidad de evitar que se aplique una sanción en su cuenta cuando cometen por primera vez una infracción de una política aplicable*, completando un ejercicio educativo. Este sistema, lanzado a principios de 2025, refleja una recomendación realizada en la primera opinión consultiva sobre políticas del Consejo, relativa al uso compartido de información residencial privada. Ahora, cuando los usuarios cometen una infracción por primera vez, Meta les envía una “notificación de infracción aplicable”, que incluye detalles sobre la política que infringieron, junto con la opción de apelar la decisión o realizar el ejercicio. Evitar sanciones de esta manera brinda a los usuarios más información sobre por qué su contenido infringió una norma comunitaria no grave y apoya su libertad de expresión evitando restricciones en sus cuentas.

---Más de 7,1 millones de usuarios de Facebook y 730 000 de Instagram decidieron ver la “notificación de infracción aplicable” durante un período de tres meses a partir de enero de 2025. De ese total, cerca de 3 millones iniciaron el ejercicio educativo, y la mayoría (más del 80 % en Facebook y más del 85 % en Instagram) completó los pasos y evitó una sanción y las restricciones correspondientes en sus cuentas.**---

** Esta función excluye las infracciones más graves a las normas comunitarias, tales como la explotación sexual, las drogas de alto riesgo y la exaltación de organizaciones peligrosas.

- Mejoras en los tiempos de respuesta a socios de confianza

El trabajo de Meta con los socios de confianza, una red de organizaciones no gubernamentales, agencias humanitarias e investigadores de derechos humanos de 113 países, ayuda a identificar daños emergentes y casos complejos en Facebook, Instagram y Threads que de otro modo podrían pasar desapercibidos. En una decisión sobre la violencia de pandillas en Haití, el Consejo expresó su preocupación por los diferentes tiempos de respuesta a los informes escalados por los socios de confianza, muchas veces durante situaciones de crisis. En respuesta a nuestra recomendación relacionada:

---Meta aumentó el número de casos resueltos dentro de los cinco días posteriores a su escalamiento a través del programa, del 69 % en el segundo trimestre de 2022 al 81 % en el segundo trimestre de 2024. Este incremento se logró aun cuando Meta recibió cuatro veces más contenido a través del programa.---

- Apoyo a la libertad de expresión

Una opinión consultiva sobre políticas emitida por el Consejo presentó un análisis detallado sobre cómo el enfoque de Meta hacia el término árabe “shaheed” (traducido de forma general como “mártir”) estaba afectando la libertad de expresión de millones de usuarios. En ese momento, el uso del término para referirse a personas designadas como peligrosas por Meta representaba la mayor cantidad de eliminaciones de contenido según las normas comunitarias que cualquier otra palabra. El Consejo realizó recomendaciones para que Meta actualizara su política sobre personas y organizaciones peligrosas, a fin de permitir que las personas usen el término “shaheed” en sus publicaciones siempre que no contengan indicios de violencia ni exalte a personas u organizaciones designadas.

---Mediante el uso de la Biblioteca de contenido de Meta, el equipo de datos del Consejo identificó un aumento del 19,5 % en publicaciones diarias con más de 50 000 vistas que contenían la palabra “shaheed” tras la implementación.***---

***Medición realizada durante el período anterior a la implementación (marzo a agosto de 2024) y el posterior (octubre de 2024 a abril de 2025), con base en 31 498 publicaciones recolectadas.

- Mayor concientización sobre el abuso sexual

En un caso de 2022 relacionado con contenido que mostraba la agresión sexual de una mujer en la India, el Consejo analizó cómo distinguir entre publicaciones compartidas para generar conciencia sobre el acoso sexual del contenido destinado a perpetuar la violencia o la discriminación. Una recomendación del Consejo instó a Meta a establecer una excepción en su política sobre explotación sexual de adultos para las representaciones de tocamientos sexuales no consentidos sin desnudez, que solo se aplicaría mediante escalamiento y si el contenido cumplía con otros criterios. El contenido que calificara y cumpliera el propósito específico de generar conciencia sobre este tipo de abuso podría permanecer en las plataformas de Meta con una pantalla de advertencia.

---Durante un período de tres meses a partir de diciembre de 2024, se identificaron más de 15 000 piezas de contenido en Facebook e Instagram en las que los usuarios generaron conciencia sobre el acoso o abuso sexual, conforme a los nuevos criterios de la política. Esto incluye contenido que antes habría sido eliminado, pero que ahora permanece en las plataformas de Meta con una pantalla de advertencia.---

En 2024, el Consejo asesor de contenido

- Publicó sus primeros informes oficiales, los cuales ofrecían liderazgo intelectual basado en nuestro trabajo con casos sobre dos temas de moderación de contenido: protección de la integridad de las elecciones y adaptación a una nueva era de IA y automatización

- Emitió su primera decisión sobre contenido en Threads, relacionada con declaraciones sobre el primer ministro japonés

- Emitió decisiones expeditas sobre la crisis poselectoral en Venezuela

Emitió 65 decisiones

32 decisiones estándares 2 decisiones expeditas 31 decisiones sumarias

Sobre temas diversos, como negación del Holocausto, imágenes íntimas no consensuadas, votación ilegal, matrimonio infantil, discurso político y violencia homofóbica

Publicó 1 opinión consultiva sobre políticas acerca del enfoque de Meta para moderar el uso del término árabe “shaheed” cuando se refiere a personas y organizaciones peligrosas

Emitió 48 recomendaciones a Meta

Recibió más de 3250 comentarios públicos

Apelaciones al Consejo en 2024

Número total:

558 235

Incluye 8 casos remitidos por Meta

Incremento:

33 % con respecto a 2023

Por plataforma:

Facebook: 77 % Instagram: 22 % Threads: 1 %

By Policy (top 5)*:

Bullying y acoso: 22,3 %

Desnudos y actividad sexual de adultos: 17,7 %

Violencia e incitación: 17,4 %

Conducta que incita al odio (anteriormente lenguaje que incita al odio): 16,2 %

Bienes y servicios restringidos: 7,4 %

*Basado únicamente en apelaciones de usuarios para restaurar contenido.

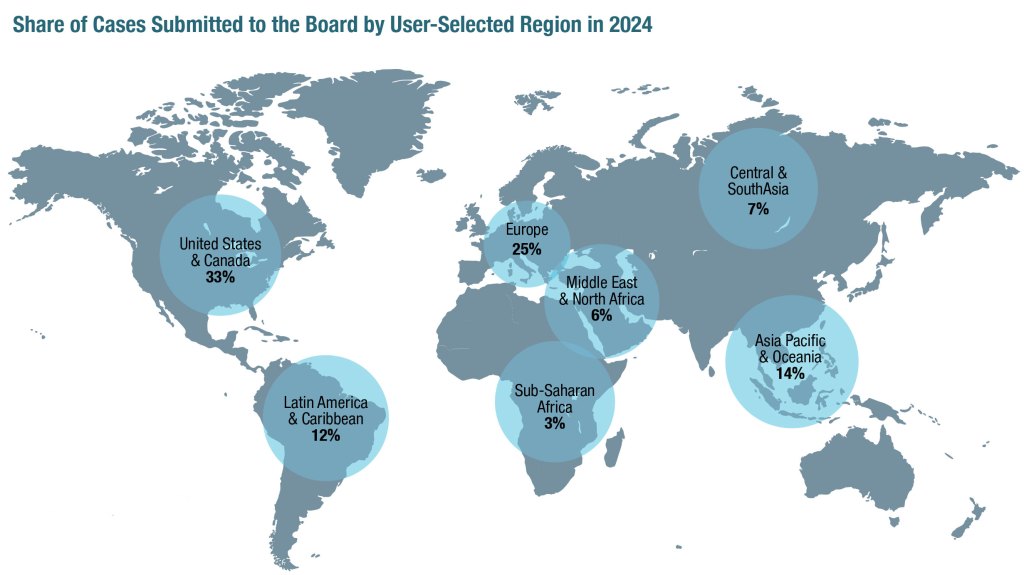

Por región

The full report is available as a PDF here.