Le rapport annuel 2024 souligne l'impact de la Commission en cette année d'élections

27 août 2025

Avant-propos des coprésidents

En 2024, année des plus grandes élections de l'histoire moderne, le Conseil de surveillance a publié son premier livre blanc. S'appuyant sur l'analyse de nos études de cas, ce document présente les moyens dont disposent les entreprises de médias sociaux pour contrer les obstacles à un déroulement sûr et fiable des élections tout en protégeant la liberté d'expression, conformément aux normes internationales en matière de droits de l'homme. L'accent mis sur les élections a inspiré les affaires que nous avons sélectionnées l'année dernière sur la fraude électorale, la désinformation et la satire politique. Nous avons également rendu une décision accélérée pour des affaires couvrant les violences post-électorales au Venezuela.

Un autre thème exploré par le Conseil en 2024, par le biais d'un deuxième livre blanc, portait sur la modération de contenu à l'ère de l'IA et de l'automatisation. S'intéressant à la conception des systèmes automatisés de Meta et à la nécessité pour les plateformes de prendre en compte les droits de l'homme au niveau mondial lorsqu'elles déploient des outils d'IA, le document a également mis en lumière les recommandations que nous avons formulées sur les contenus générés par l'IA. L'une de ces recommandations clés, qui appelait Meta à étiqueter les contenus créés ou modifiés par l'IA, a été adoptée par l'entreprise en 2024. Consultez le résumé ci-dessous pour connaître les autres changements apportés par Meta en réponse à nos recommandations, que nous publions dans le cadre de nos décisions d'affaires.

Au cours de chaque trimestre de l'année 2024, le Meta a accepté et mis en œuvre beaucoup plus de nos recommandations qu'il n'en a refusées. Il est important de noter que nous avons réalisé cette évaluation à l'aide d'une méthodologie indépendante, qui exige que Meta fournisse la preuve que la mise en œuvre a eu lieu.

Depuis janvier 2021, nous avons fait plus de 300 recommandations à Meta. La mise en œuvre ou les progrès réalisés pour 74 % d'entre elles ont permis une plus grande transparence, des règles claires et accessibles, une meilleure équité pour les utilisateurs et une plus grande prise en compte des responsabilités de Meta en matière de droits de l'homme, y compris le respect de la liberté d'expression.

L'équipe de données de la Commission, qui a développé notre approche du suivi de la mise en œuvre, a travaillé avec Meta pour mieux comprendre l'impact de ce travail sur les utilisateurs. En 2024, la Commission a reçu les données les plus détaillées pour valider cet impact, présentées dans la section "Apporter des changements sur les plateformes de Meta" ci-dessous. Ces données constituent une partie essentielle du cycle de vie des recommandations, afin de comprendre comment les personnes sont affectées par les conseils de la Commission et comment nous pouvons continuer à améliorer les plateformes Meta au profit de milliards d'utilisateurs et de leur discours.

Evelyn Aswad, Paolo Carozza, Michael McConnell, Pamela San Martín, Helle Thorning-Schmidt

Avant-propos de la présidente du Conseil de surveillance Trust

Modèle unique de contrôle de la modération des contenus mondiaux, indépendant des entreprises et des gouvernements, la Commission évolue en permanence pour s'adapter aux changements de l'industrie et au paysage réglementaire. Cinq ans après l'ouverture de la procédure d'appel, il est remarquable de constater que cette expérience s'est transformée en un modèle institutionnel de gouvernance indépendante, fondée sur des principes et globale des contenus.

En 2024, Meta a confirmé un nouveau cycle de financement, avec une contribution de 30 millions de dollars pour compléter la fiducie irrévocable afin de garantir le financement des opérations du Conseil jusqu'en 2027. Alors que le Meta a renouvelé son engagement en faveur d'un contrôle indépendant, le Conseil a également pris des mesures pour optimiser ses opérations, en procédant à des coupes budgétaires ciblées afin de donner la priorité aux aspects les plus importants de son travail.

Dans un souci d'optimisation continue, nous avons récemment apporté des modifications à notre mode de gouvernance. Tout en veillant à ce que le conseil reste indépendant de Meta et du soutien financier fourni par l'entreprise, notre structure a été adaptée pour intégrer les coprésidents dans le corps des gestionnaires du Conseil de surveillance LLC, créant ainsi un espace unifié pour la stratégie, le budget et les opérations afin de garantir que l'impact du conseil soit maximisé à long terme.

Il n'a jamais été aussi important de favoriser la responsabilisation pour instaurer la confiance entre les entreprises technologiques. Le modèle du conseil d'administration et son leadership en matière de réflexion sur les questions clés de gouvernance montrent comment on peut y parvenir.

Stephen Neal

Résumé

La Commission a adressé 317 recommandations au Meta depuis 2021, dont 74 % ont été mises en œuvre, sont en cours d'application ou sont signalées par le Meta comme des travaux qu'il effectue déjà. En réponse à ces recommandations, le Meta a apporté les changements suivants en 2024/début 2025.

- a commencé à étiqueter les contenus créés ou modifiés par l'IA, fournissant ainsi des informations supplémentaires aux utilisateurs sans restreindre indûment la liberté d'expression.

- unifié ses politiques afin qu'elles s'appliquent de la même manière à Facebook, Instagram et Threads, améliorant ainsi la cohérence entre ses plateformes et la clarté des règles pour les utilisateurs.

- Donner aux utilisateurs la possibilité d'éviter une radiation de leur compte pour leur première violation d'une politique éligible en effectuant un exercice éducatif, contribuer à protéger l'expression et donner aux utilisateurs la possibilité d'apprendre pourquoi leurs messages contenaient une violation.

- Permettre aux utilisateurs de fournir un contexte supplémentaire lorsqu'ils font appel de la suppression de leur contenu pour discours haineux, ce qui limite l'application excessive des messages satiriques et d'autres contenus qui pourraient bénéficier d'autres exceptions, telles que la sensibilisation.

- Amélioration des indicateurs fournis aux modérateurs lorsqu'ils examinent des vidéos de longue durée pour détecter des violations potentielles, afin d'assurer une mise en œuvre plus précise de ce type de contenu.

- a réalisé un audit de ses listes d'insultes dans 22 pays dont les élections auront lieu en 2024, , dans le cadre des efforts visant à améliorer l'exactitude de l'application de la règle relative aux comportements haineux.

- a mis à jour sa politique relative aux organisations et individus dangereux afin de permettre une plus grande liberté de parole lorsque, dans certains contextes, les utilisateurs se réfèrent à des individus désignés comme "shaheed", mettant ainsi fin à l'interdiction générale de ce terme.

- aligné le langage public de sa politique en matière de contenu violent et graphique sur les orientations internes destinées aux évaluateurs, en clarifiant pour les utilisateurs les types de contenu non autorisés par la politique et en rendant transparente la manière dont elle est appliquée.

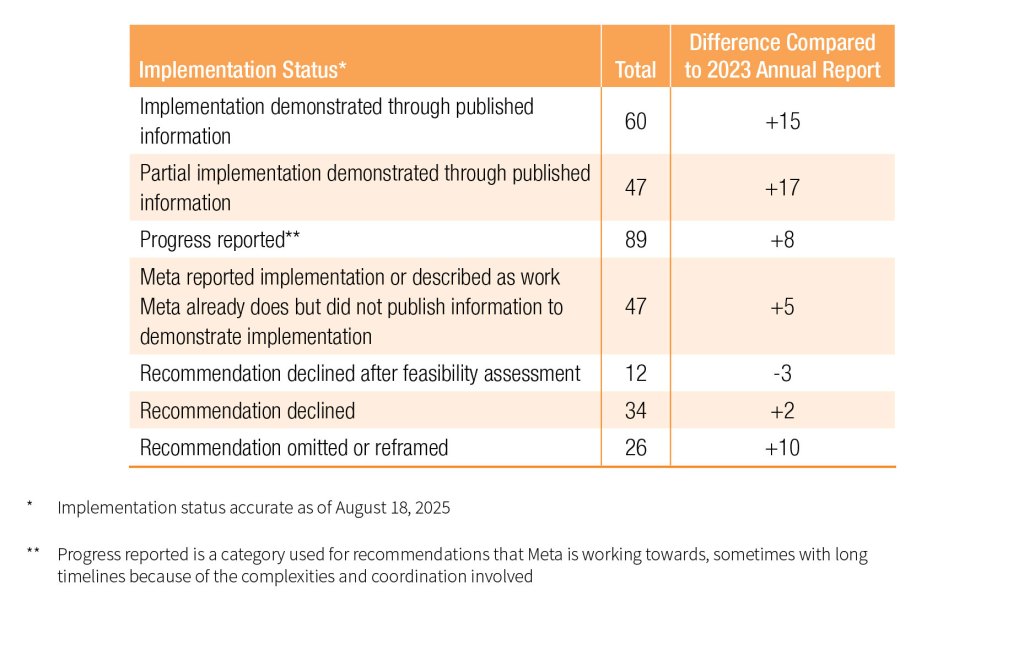

En décomposant les dernières informations sur l'état de la mise en œuvre par Meta, le tableau ci-dessous montre une tendance continue à la hausse de la mise en œuvre totale ou partielle des recommandations de la Commission par la société, comme cela a été vérifié par le biais des informations publiées.

Le conseil d'administration continue d'examiner la mise en œuvre par le biais de sa propre approche indépendante, fondée sur des données.

Apporter des changements sur les plateformes Meta

Outre les décisions contraignantes que nous prenons sur des éléments de contenu individuels, le Conseil émet également des recommandations auxquelles Meta doit répondre publiquement dans un délai de 60 jours. Ces recommandations, qui préconisent un plus grand respect des droits de l'homme, de la transparence, de la cohérence et de l'équité dans la modération des contenus par le Meta, ont un impact sur les utilisateurs et les organisations du monde entier de la manière suivante.

- Moins d'entraves à la liberté d'expression

En réponse à l'une des recommandations de la Commission dans notre affaire de vidéo modifiée de Biden, Meta a commencé à étiqueter les contenus créés ou modifiés par l'IA sur ses plateformes en mai 2024. L'entreprise ajoute des étiquettes "AI info" à une série de vidéos, de sons et d'images sur Facebook, Instagram et Threads, fournissant aux utilisateurs un contexte important sur la façon dont le contenu a été créé. Tous les contenus manipulés par l'IA ne sont pas nuisibles, et l'étiquetage offre une alternative à la suppression de contenu qui ne restreint pas indûment l'expression.

--- Pendant 29 jours en octobre 2024, les utilisateurs ont vu plus de 360 millions de contenus avec des étiquettes d'IA sur Facebook et 330 millions sur Instagram. Parmi eux, les utilisateurs de Facebook ont cliqué sur 6 millions de posts avec ces étiquettes et 13 millions d'éléments sur Instagram, pour en savoir plus sur la façon dont le contenu avait été créé*---.

*Toutes les informations sont agrégées et dépersonnalisées afin de protéger la vie privée des utilisateurs. Toutes les mesures sont des estimations, basées sur les meilleures informations actuellement disponibles à un moment précis.

- Prévenir les grèves et les restrictions de compte

Les utilisateurs ont désormais la possibilité d'éviter qu'une radiation soit appliquée à leur compte lorsqu'ils commettent leur première violation d'une politique éligible* en effectuant un exercice éducatif. Lancé au début de l'année 2025, ce système reflète une recommandation formulée dans le premier avis consultatif de la Commission sur le partage d'informations résidentielles privées. Désormais, lorsque les utilisateurs commettent une violation pour la première fois, Meta leur envoie un "avis de violation admissible", qui comprend des détails sur la politique qu'ils ont enfreinte, ainsi que la possibilité de faire appel de la décision ou de faire l'exercice. En évitant ainsi les sanctions, les utilisateurs disposent de plus d'informations sur les raisons pour lesquelles leur contenu a enfreint une norme communautaire non sévère et soutiennent leur liberté d'expression en évitant les restrictions de compte.

---Plus de 7,1 millions d'utilisateurs de Facebook et 730 000 utilisateurs d'Instagram ont choisi de consulter l'"avis de violation admissible" pendant une période de trois mois à partir de janvier 2025. Parmi ces utilisateurs, près de 3 millions se sont ensuite lancés dans l'exercice éducatif, la majorité (80%+ sur Facebook, 85%+ sur Instagram) allant jusqu'au bout des démarches, et évitant ainsi une grève et les restrictions de compte qui en découlent**---.

**Cette fonction exclut les violations les plus graves des normes communautaires, telles que l'exploitation sexuelle, les drogues à haut risque et la glorification d'organisations dangereuses.

- Améliorer les délais de réponse aux partenaires de confiance

Le travail de Meta avec Trusted Partners, un réseau d'ONG, d'agences humanitaires et de chercheurs en droits de l'homme de 113 pays, aide à signaler les préjudices émergents et les cas complexes sur Facebook, Instagram et Threads qui pourraient autrement passer inaperçus. Dans une décision concernant la violence des gangs en Haïti, le Conseil d'administration a pris note de nos préoccupations concernant les différents délais de réponse aux rapports transmis par les partenaires de confiance, souvent en période de crise. En réponse à notre recommandation connexe :

---Meta a augmenté le nombre de cas résolus dans les cinq jours suivant l'escalade via le programme, passant de 69 % au deuxième trimestre 2022 à 81 % au deuxième trimestre 2024. Cette augmentation a été réalisée alors que Meta a reçu quatre fois plus de contenu via le programme.

- Soutenir la liberté d'expression

Un avis consultatif du conseil d'administration a fourni une analyse détaillée de la manière dont l'approche de Meta concernant le terme arabe "shaheed" (traduit approximativement par "martyr") avait un impact sur la liberté d'expression de millions d'utilisateurs. À l'époque, ce terme, utilisé pour désigner les personnes désignées comme dangereuses par Meta, était à l'origine de plus de suppressions de contenu en vertu des normes communautaires que n'importe quel autre mot. Le conseil d'administration a formulé des recommandations visant à mettre à jour la politique de Meta relative aux organisations et individus dangereux afin de permettre aux utilisateurs d'utiliser le terme "shaheed" dans leurs messages lorsque ceux-ci ne contiennent pas de signaux de violence et ne font pas l'éloge d'individus ou d'organisations désignés comme dangereux.

---En utilisant la bibliothèque de contenu méta, l'équipe de données de la Commission a identifié une augmentation de 19,5 % des messages quotidiens, avec plus de 50 000 vues, contenant le mot "shaheed" à la suite de la mise en œuvre.

***Mesuré au cours d'une période précédant la mise en œuvre de mars à août 2024 et d'une période suivant la mise en œuvre d'octobre 2024 à avril 2025, sur la base de 31 498 messages collectés.

- Sensibilisation aux abus sexuels

Dans une affaire de 2022 concernant des contenus montrant l'agression sexuelle d'une femme en Inde, la Commission s'est penchée sur la question de savoir comment distinguer les messages partagés pour sensibiliser au harcèlement sexuel des contenus destinés à perpétuer la violence ou la discrimination. Une recommandation de la Commission invitait Meta à prévoir une exception à sa politique en matière d'exploitation sexuelle des adultes pour les représentations d'attouchements sexuels non consensuels sans nudité, à appliquer uniquement en cas d'escalade et si le contenu répondait à d'autres critères. Les contenus qualifiés qui répondent à l'objectif spécifique de sensibilisation à ce type d'abus resteraient alors sur les plateformes du Meta avec un écran d'avertissement.

---Au cours d'une période de trois mois débutant en décembre 2024, plus de 15 000 contenus sur Facebook et Instagram ont été identifiés dans lesquels les utilisateurs sensibilisaient au harcèlement ou aux abus sexuels conformément aux nouveaux critères de la politique. Il s'agit notamment de contenus qui auraient auparavant été retirés mais qui restent désormais sur les plateformes de Meta avec un écran d'avertissement.---

En 2024, le Conseil de surveillance

- Publié nos premiers livres blancs, offrant un leadership éclairé tiré de notre travail de cas sur deux thèmes de modération de contenu : sauvegarder l'intégrité des élections et s'adapter à une nouvelle ère d'IA et d'automatisation.

- Nous avons pris notre première décision de contenu sur Threads concernant des déclarations sur le Premier ministre japonais.

- Décisions accélérées sur la crise post-électorale au Venezuela

Délivré 65 décisions

32 Décisions standard 2 Décisions accélérées 31 Décisions de synthèse

Sur des questions aussi diverses que le déni de l'Holocauste, les images intimes non consensuelles, le vote illégal, le mariage des enfants, le discours politique et la violence homophobe.

Publication d'un avis consultatif sur l'approche de Meta concernant la modération du terme arabe "Shaheed" lorsqu'il fait référence à des organisations ou des individus dangereux .

48 recommandations ont été émises à l'intention de Meta

Plus de 3 250 commentaires du public ont été reçus

Recours devant la Commission en 2024

Nombre total :

558,235

Y compris 8 cas renvoyés par Meta

Augmentation :

33% en 2023

Par plate-forme :

Facebook : 77% Instagram : 22% Threads : 1%

By Policy (top 5)*:

Intimidation et harcèlement : 22,3%.

Nudité et activité sexuelle chez les adultes : 17,7%.

Violence et incitation : 17.4%

Conduite haineuse (anciennement discours de haine) : 16.2%

Biens et services à usage restreint : 7.4%

*Basé uniquement sur les appels des utilisateurs à restaurer le contenu.

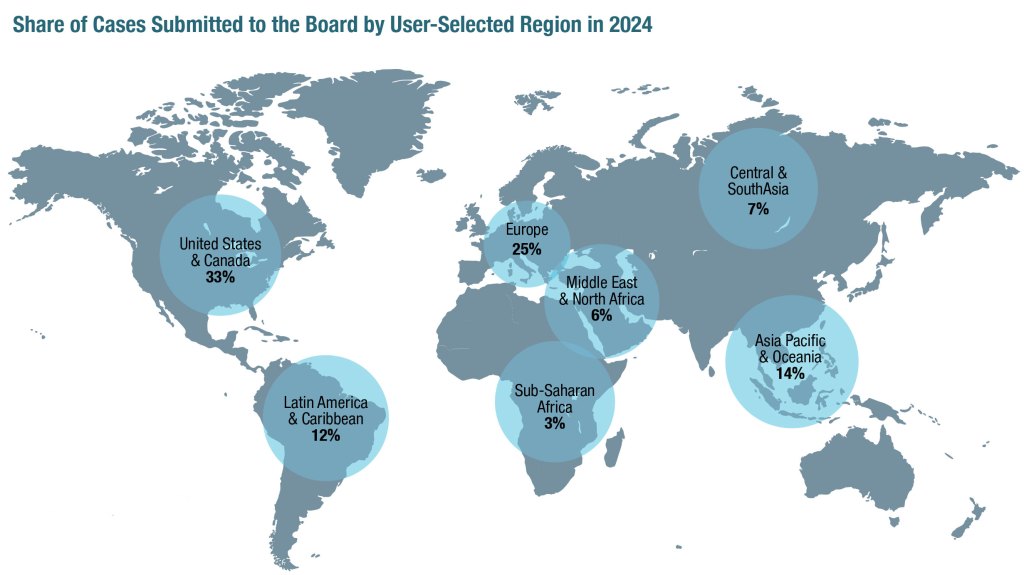

Par région

Le rapport complet est disponible au format PDF ici.