De experimento ousado a instituição essencial

Como cinco anos de supervisão independente tornaram a Meta mais responsável e protegeram os direitos dos usuários.

Resumo executivo

Em 2018, o Facebook era uma empresa que sofria intensa condenação pública. Depois de um lançamento marcado por grande otimismo e mais de dez anos de crescimento acelerado, a indignação dos mais de 2 bilhões de usuários ao redor do mundo aumentou de forma igualmente acelerada. O escândalo envolvendo a Cambridge Analytica — no qual dados pessoais de milhões de contas foram compartilhados sem autorização — trouxe à tona a questão central da privacidade dos usuários. A incapacidade de conter discursos de ódio na plataforma também resultou em danos concretos e violações de direitos humanos durante o genocídio dos Rohingya em Mianmar.

Ao mesmo tempo, os usuários constatavam que sua liberdade de expressão era constantemente prejudicada, já que conteúdos como discursos políticos legítimos, manifestações artísticas, materiais de aumento da conscientização e sátiras eram removidos do Facebook e do Instagram com base em regras percebidas como vagas e arbitrárias.

Durante eleições importantes, a propagação de desinformação e informações equivocadas dificultava que os usuários tomassem decisões esclarecidas e, em alguns casos, chegava até a influenciar os resultados. Conteúdos que retratavam ou incentivavam automutilação e outras práticas perigosas passaram a aparecer com maior frequência. Usuários de países fora dos Estados Unidos enfrentavam uma moderação de conteúdo limitada e inadequada às suas regiões, com decisões que ignoravam idiomas, contextos culturais e realidades políticas locais.

Para agravar o problema, muitas pessoas não sabiam como contestar a remoção de suas publicações ou sequer quais regras teriam violado. Também havia pouca transparência sobre os algoritmos e os procedimentos que determinavam quais conteúdos permaneceriam na plataforma e quais seriam excluídos.

Dentro do próprio Facebook, reconhecia-se que decisões tão significativas sobre moderação de conteúdo não deveriam ser tomadas exclusivamente por grupos de executivos corporativos. Isso levou o Facebook — hoje Meta — a anunciar, em 2018, a criação do Comitê de Supervisão. O Comitê selecionou seus primeiros casos em outubro de 2020 e, até o momento, continua sendo o único órgão desse tipo.

Transparência para os usuários e uma perspectiva de direitos humanos

Cinco anos depois, o Comitê passou a desempenhar um papel significativo para os usuários globais da Meta, oferecendo transparência, fundamentação e uma abordagem baseada em direitos humanos para decisões que antes eram tomadas de forma interna, sem clareza ou justificativa pública. O modelo que criamos reúne especialistas de diferentes regiões do planeta para analisar, de maneira independente, decisões envolvendo conteúdos sensíveis nas plataformas da Meta, contando também com contribuições do público e de organizações da sociedade civil. Os membros do Comitê possuem diversidade política,

ideológica, geográfica, cultural e profissional. Essa diversidade permite considerar os múltiplos contextos que influenciam a liberdade de expressão e outros direitos humanos em diferentes partes do mundo. O Comitê toma decisões obrigatórias sobre manter ou remover conteúdos. Também apresentamos recomendações essenciais para melhorias sistêmicas.

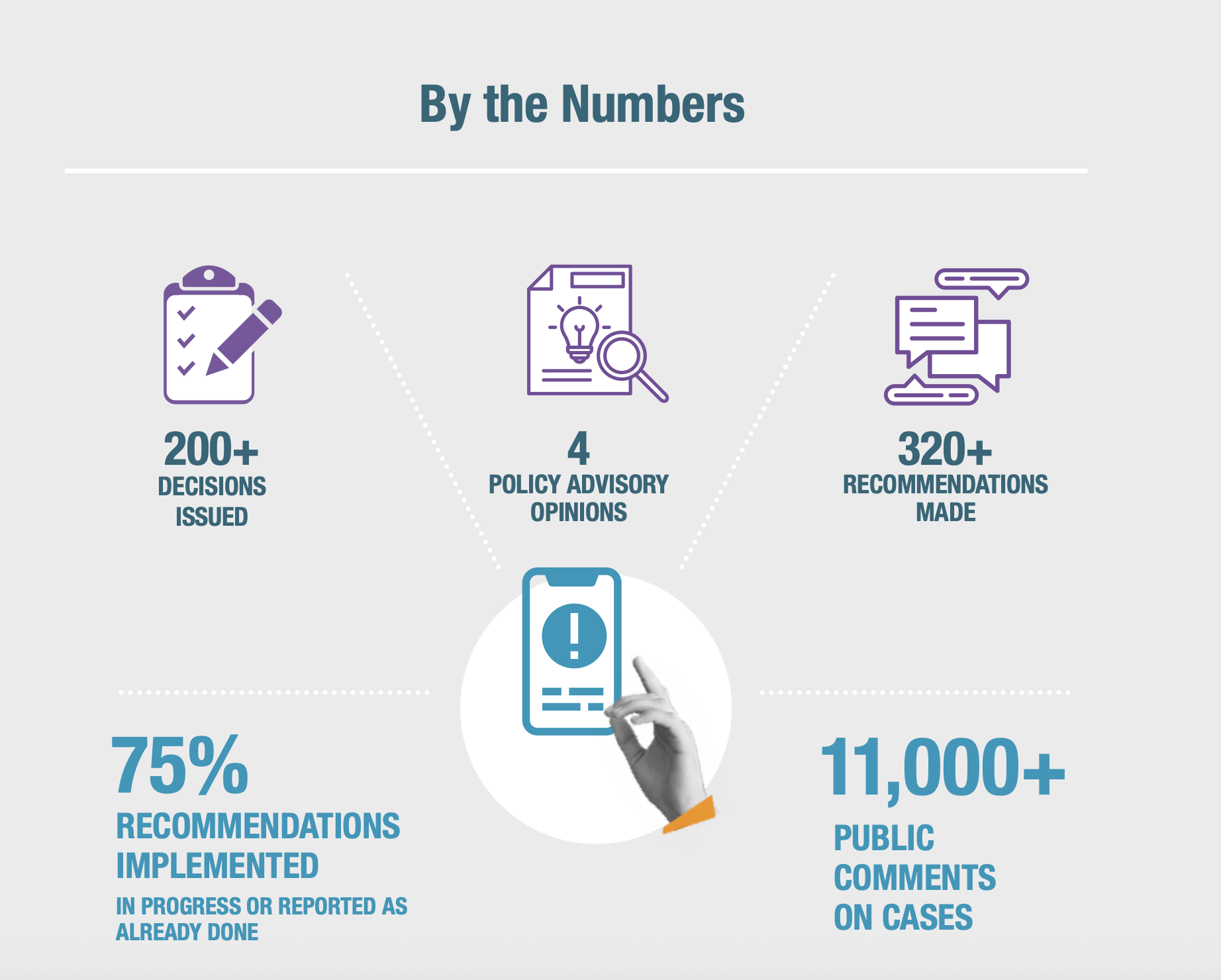

A Meta se comprometeu a acatar nossas decisões referentes à manutenção ou exclusão de conteúdos específicos e deve responder publicamente às recomendações que emitimos — compromissos que a empresa tem cumprido. Embora não seja legalmente obrigada a adotar todas as recomendações, a Meta implementou 75% das mais de 300 que já emitimos, aumentando a transparência e a responsabilização. Cada recomendação contribuiu para o debate e para a discussão sobre políticas e práticas de moderação de conteúdo.

Para os bilhões de usuários do Facebook, Instagram e Threads ao redor do mundo, isso resultou em mudanças importantes — desde ajustes nos algoritmos para melhor proteger conteúdos de conscientização e sátira até a garantia de processos mais justos e da oferta de segundas chances a usuários que violam regras e recebem penalidades.

Como resultado do trabalho do Comitê, a Meta se tornou uma empresa mais responsável, transparente e melhor informada, embora ainda haja muito a ser feito. O Comitê demonstrou que a supervisão independente — com autoridade para tomar decisões vinculativas sobre conteúdo e emitir recomendações não obrigatórias que exigem resposta pública — funciona na prática e, de forma crucial, pode servir de modelo para outras plataformas.

A decisão da Meta de criar o Comitê, financiá-lo, estabelecer proteções que garantissem sua independência nas decisões e conceder poder para decidir e recomendar foi algo sem precedentes. Naquele momento, esperava-se que outras plataformas de mídia social adotassem iniciativas semelhantes para reforçar sua responsabilidade perante os usuários por meio de supervisão independente, possivelmente até colaborando com o próprio Comitê. Até agora, nenhuma tomou essa iniciativa. A interação do Comitê com a Meta envolve defesa e negociação contínuas, e o Comitê nunca obtém tanto acesso ou influência quanto gostaria. Ainda assim, o Comitê reconhece profundamente os riscos e as obrigações que a Meta assumiu voluntariamente ao buscar fortalecer suas responsabilidades relacionadas aos direitos humanos.

O Comitê teve início como um experimento, e sempre encaramos nosso trabalho com esse espírito, dispostos a aprender e a melhorar continuamente. Foi necessário tempo para aperfeiçoarmos nossas formas de definir prioridades, selecionar casos, reunir informações para embasar nossas decisões, elaborar recomendações eficazes e acompanhar sua implementação. Temos orgulho das conquistas alcançadas em nome dos usuários da Meta. Também temos plena consciência da influência global da plataforma, das limitações do nosso próprio alcance e dos desafios que continuam presentes. Para o futuro, reafirmamos nosso compromisso de fortalecer nosso papel único como uma força dedicada à promoção do respeito aos direitos humanos em toda a indústria da tecnologia.

Nossas conquistas para os usuários

O trabalho do Comitê de Supervisão contribuiu para uma compreensão pública mais ampla sobre o funcionamento dos sistemas da Meta. Quando identificamos riscos ou falhas na moderação de conteúdo da empresa, apresentamos recomendações que influenciam diretamente suas políticas, processos, práticas e tecnologias de aplicação. Desde que começamos a emitir decisões, em janeiro de 2021, asseguramos diversos avanços em benefício dos usuários:

- Expansão da liberdade de expressão: ao emitir uma decisão, defendemos não apenas uma publicação específica, mas um princípio fundamental: que o espaço público digital deve permanecer aberto e seguro para uma pluralidade de vozes, mesmo quando o discurso é controverso, ofensivo ou crítico em relação a figuras de poder. Nossas recomendações modificaram políticas e práticas de aplicação da Meta de modo a favorecer a preservação de uma maior liberdade de expressão no Facebook, Instagram e Threads. Este relatório detalha como o Comitê lidou com essas questões, incluindo: no Irã, em que declarações de apoio a Khamenei foram restauradas para proteger a liberdade de expressão política; no Afeganistão, em que foi permitido um aumento nos debates e reportagens sobre o Talibã, desde que fossem de interesse público; e na América do Norte, em que o Comitê restaurou publicações de um artista indígena que denunciavam crimes históricos contra povos indígenas.

- Transparência para empoderar usuários e promover a responsabilização: Para garantir justiça aos usuários, o Comitê exigiu que a Meta se tornasse mais transparente em relação às suas regras e às ações aplicadas ao conteúdo. No Reino Unido, o Comitê identificou falhas na aplicação de regras em um caso envolvendo o gênero musical drill, que acabou restringindo indevidamente a expressão artística de grupos marginalizados. Em diversos casos, o Comitê pressionou a Meta para que informasse aos usuários qual política específica seu conteúdo teria violado ao tomar medidas punitivas — prática que a empresa passou a adotar a partir de 2024.

- Melhor gestão de questões graves e proteção de comunidades vulneráveis: Nossas recomendações levaram a uma maior atenção e a processos mais rápidos no tratamento de conflitos e crises. Especificamente, a Meta adotou uma política de protocolo de crise e estabeleceu uma estrutura para lidar com conteúdo durante períodos eleitorais. A empresa também corrigiu preconceitos presentes em seu sistema de verificação cruzada. Esse mecanismo, que oferece análises adicionais sobre conteúdo potencialmente violador para usuários de perfil de grande repercussão e páginas com grande público, estava sendo aplicado de forma injusta, prejudicando usuários comuns. Além disso, o Comitê tem defendido de forma consistente comunidades vulneráveis, incluindo defensores dos direitos humanos e líderes da oposição em regimes repressivos. Como resultado de nossas decisões, publicações que incitavam violência homofóbica foram removidas.

- Incorporação dos princípios de direitos humanos na IA e na automação: Estamos acelerando a implementação de recomendações que, sob a perspectiva dos direitos humanos, identificam áreas em que as políticas e sistemas da Meta não acompanham adequadamente o conteúdo gerado por IA. As recomendações do Comitê levaram a Meta a adotar rótulos de IA, que foram aplicados a bilhões de conteúdos manipulados, permitindo que os usuários avaliem sua confiabilidade. Em 2021, destacamos que os sistemas automatizados da Meta estavam removendo de forma equivocada publicações de conscientização sobre o câncer de mama. Como resultado, foram feitas mudanças que oferecem maior proteção a esse tipo de conteúdo.

Nossos aprendizados

Nossa capacidade de fornecer recomendações sólidas decorre do design único do nosso modelo. A diversidade de perspectivas trazida por nossos especialistas globais, aliada ao convite para comentários públicos sobre os casos e à nossa abordagem baseada em direitos humanos, sustentou nosso trabalho ao longo dos últimos cinco anos.

O julgamento independente dos membros do Comitê é assegurado por uma série de mecanismos, incluindo: liderança própria do Comitê; mandatos fixos para seus membros; financiamento garantido por um fundo fiduciário irrevogável; e a impossibilidade de a Meta retirar o financiamento já comprometido, mesmo que discorde de nossas decisões.

Durante todo o processo, compartilhamos nossos aprendizados com usuários, empresas de tecnologia e formuladores de políticas, destacando os fatores principais que nos permitiram criar um modelo eficaz de supervisão da governança de conteúdo. Também refletimos sobre as limitações que encontramos ao longo do caminho.

O que o futuro reserva

Nosso modelo de supervisão independente continua a promover maior transparência, responsabilização, diálogo aberto e respeito à liberdade de expressão e a outros direitos humanos nas plataformas da Meta, fortalecendo os direitos dos usuários globalmente. Ainda assim, o Comitê reconhece a complexidade dos desafios do setor. Os avanços rápidos da IA, as regulamentações das mídias sociais e as disputas geopolíticas sobre os direitos de expressão dos usuários tornam a governança de conteúdo em larga escala uma tarefa particularmente difícil.

Pretendemos enfrentar esses desafios formalizando nossos aprendizados em documentos técnicos e diretrizes sobre prioridades principais, incluindo a nova era da IA e da automação. Já demos passos em direção a debates mais amplos sobre governança de conteúdo e responsabilidade das plataformas. O Comitê também está bem posicionado para colaborar com empresas globais, auxiliando-as a lidar com questões relacionadas à liberdade de expressão ao redor do mundo. Mesmo diante das transformações globais, permanecemos comprometidos com nossa missão fundadora: incorporar a liberdade de expressão e outros direitos humanos às tecnologias em constante evolução e fortalecer a responsabilidade dos usuários.

Expansão da liberdade de expressão

Em apoio ao nosso propósito fundador de proteger a liberdade de expressão, identificamos situações em que a moderação da Meta restringiu de maneira indevida comentários políticos, a autoexpressão e o discurso público online. Nossas recomendações buscam impedir a remoção inadequada de conteúdos, incluindo protestos políticos, reportagens, campanhas de conscientização sobre temas de interesse público e expressões pessoais, ao mesmo tempo em que protegem outros direitos humanos.

Diante de bilhões de publicações diárias, nossas recomendações também têm o objetivo de reduzir a ocorrência de erros de moderação nos sistemas da Meta. Fazemos isso analisando aspectos dos sistemas automatizados e dos processos de revisão humana que podem levar à remoção indevida de conteúdos, seja por interpretações equivocadas, falta de atenção às nuances ou contexto, ou falhas na aplicação de exceções previstas nas políticas.

Remoção de barreiras à liberdade de expressão com ameaças de violência não críveis

Revertemos repetidamente a remoção equivocada, pela Meta, de conteúdos políticos que contêm ameaças figurativas de violência, relacionadas a eleições iminentes, escândalos políticos ou movimentos de protesto (como no caso do Poema russo, Declarações sobre o primeiro-ministro japonês e Relatório sobre o discurso no Parlamento do Paquistão). Eleições e política frequentemente envolvem retórica intensa, incluindo metáforas e hipérboles. Os usuários devem ter a liberdade de se expressar politicamente de maneira ampla e robusta, inclusive ao criticar figuras públicas, como presidentes ou primeiros-ministros, sem que as plataformas imponham barreiras desnecessárias a essa liberdade de expressão. Temos defendido que a Meta adote uma abordagem mais precisa para diferenciar entre ameaças de violência que representem risco real e linguagem figurativa ou intensa, que, embora contundente, se insere dentro dos limites do debate político.

Em um caso relacionado aos protestos iranianos de 2022, “Mulher, Vida, Liberdade”, argumentamos que declarações como “marg bar Khamenei” não deveriam ser consideradas violações das regras da Meta contra ameaças (como no Slogan de protesto no Irã). A frase pode ser traduzida de maneiras diferentes, por exemplo, “morte a Khamenei” — referindo-se ao Aiatolá Ali Khamenei, Líder Supremo do Irã —, mas, naquele contexto, era usada como retórica política, significando “abaixo Khamenei”. A Meta concordou com nossa análise no contexto dos protestos em andamento e reverteu sua decisão, permitindo tais declarações. Após essa reversão, houve um aumento de 29% nas publicações do Instagram contendo a declaração, considerando as mesmas páginas, grupos e contas.

Em resposta às nossas recomendações, a Meta iniciou um processo de desenvolvimento de políticas sobre expressões relacionadas a “incitações à morte”, para avaliar como tratar discursos desse tipo quando usados em contextos não ameaçadores, como brincadeiras, música ou incitações figurativas à morte. O Comitê participou desse processo, oferecendo feedback sobre possíveis mudanças nas políticas e em sua aplicação.

Prevenção do silenciamento das vozes da oposição

Ameaças reais de violência online, embora sejam formas de expressão, prejudicam o discurso aberto e o debate político, especialmente quando emanam de autoridades. Em contextos de repressão política, as mídias sociais — incluindo as plataformas da Meta — frequentemente funcionam como espaços essenciais para o discurso público. Quando uma diversidade de vozes, incluindo a de dissidentes políticos, é efetivamente silenciada por meio de intimidação, a qualidade do debate público se deteriora. O Comitê destacou que a Meta, ao defender os princípios da liberdade de expressão, tem a responsabilidade de garantir que vozes críticas não sejam efetivamente silenciadas por um clima de medo em suas plataformas (como nos casos Primeiro-ministro do Camboja e Defensor de direitos humanos no Peru).

Em algumas situações, ameaças graves de violência contra indivíduos são veladas ou disfarçadas, exigindo, portanto, uma revisão humana mais aprofundada e sensível ao contexto. O Comitê também alertou para o risco de sub-reforço — quando tais ameaças permanecem publicadas por engano — e recomendou que a Meta disponibilize recursos adicionais para identificar ameaças veladas em diferentes contextos culturais e políticos (como no caso Defensor de direitos humanos no Peru). Em resposta, a empresa informou que está avaliando maneiras de incorporar de forma mais clara sinais escritos, visuais e verbais de ameaças codificadas em suas avaliações, com o compromisso de aprimorar essa estrutura.

Preservação da liberdade de expressão no interesse público nas plataformas da Meta

Em diversos casos, o Comitê concluiu que a Meta havia removido indevidamente conteúdos que, embora pudessem infringir os Padrões da Comunidade da empresa, apresentavam valor de interesse público e, portanto, deveriam ser preservados com base na permissão de “noticiabilidade”. No México, por exemplo, o Comitê determinou a restauração de uma publicação que mostrava o assassinato do candidato a prefeito José Alfredo Cabrera Barrientos, invocando o subsídio de noticiabilidade (Candidato a prefeito é assassinado no México). De forma semelhante, no Haiti, o Comitê reverteu a decisão da Meta de remover um vídeo no Facebook que mostrava pessoas invadindo uma delegacia e fazendo ameaças de violência, também com base na mesma exceção (Vídeo da delegacia haitiana). Essas deliberações reforçaram os direitos de liberdade de expressão dos usuários nas plataformas da Meta, destacando a relevância de permitir debates e manifestações sobre temas atuais de interesse público.

Impedindo a remoção de conteúdo identificado erroneamente como infrator

A Meta adiciona imagens e vídeos que revisores humanos identificaram como violando as regras da empresa aos seus bancos de dados do Serviço de Correspondência de Mídia. Esses bancos de dados permitem que o conteúdo seja identificado e removido automaticamente sempre que reaparecer na plataforma, independentemente de quem o publicou. No entanto, revisores humanos às vezes cometem erros, como ocorreu em 2022 com uma charge que retratava a violência policial na Colômbia (Caricatura da polícia colombiana). Quando conteúdos que não violam as regras permanecem nesses bancos de dados, o efeito de decisões de moderação incorretas é ampliado, impactando milhares ou até milhões de publicações. Para corrigir isso, solicitamos à Meta que desenvolvesse um processo de reavaliação para conteúdos com altas taxas de sucesso em apelações de usuários, garantindo sua remoção rápida do banco de dados assim que fosse considerado não violador. Desde então, a Meta criou uma equipe interna dedicada a aprimorar a gestão desse sistema, implementando um mecanismo de detecção de picos que identifica rapidamente grandes volumes de conteúdo não violador. Esse sistema assegura que o material seja excluído do banco de dados e não seja removido indevidamente pelos sistemas automatizados da Meta quando publicado pelos usuários.

Permissão para que as pessoas compartilhem contexto ao recorrer contra a remoção de conteúdo

Dar voz às pessoas e escutá-las pode ajudar as plataformas a tomar decisões mais precisas sobre a remoção de conteúdos. Para evitar a aplicação excessiva de políticas — ou seja, remoções equivocadas de publicações que chamam a atenção para discursos de ódio por motivos de condenação, sátira ou conscientização — solicitamos à Meta que criasse uma forma prática para que os usuários indicassem, em seu recurso, que suas publicações se enquadravam em uma dessas categorias (Meme “dois botões”, Compartilhamento de informações residenciais privadas). Entre agosto e novembro de 2023, a empresa implementou essa funcionalidade, permitindo que usuários do Facebook e do Instagram adicionassem contexto adicional aos recursos, explicando a natureza da publicação e justificando por que ela não violava as políticas. Em fevereiro de 2024, a Meta informou ter recebido mais de 7 milhões de recursos de pessoas cujos conteúdos haviam sido removidos sob as regras de Conduta de Ódio. Entre esses usuários, 80% optaram por fornecer contexto adicional. Atualmente, a opção de adicionar contexto está disponível para recursos de usuários em todos os Padrões da Comunidade.

Oferta de iniciativas educacionais para reduzir os encargos sobre a liberdade de expressão dos usuários

Algumas das maiores restrições à liberdade de expressão dos usuários decorrem das advertências e das limitações de conta aplicadas durante a moderação de conteúdo pela Meta. Desde nossa primeira opinião consultiva política (Compartilhamento de informações residenciais privadas), temos incentivado a Meta a avaliar alternativas que evitem impactos desproporcionais sobre a liberdade de expressão.

Apresentado no início de 2025 para atender a uma recomendação do Comitê, a Meta passou a enviar uma “notificação de violação elegível” aos usuários que cometem sua primeira infração considerada “não grave”* de um Padrão da Comunidade. Essa notificação detalha a política supostamente violada e oferece ao usuário a opção de recorrer da decisão ou participar de um exercício educativo. Esse treinamento ajuda a compreender melhor as políticas aplicáveis e, assim, evita que a advertência seja aplicada à conta. Em um período de três meses a partir de janeiro de 2025, mais de 7,1 milhões de usuários do Facebook e 730 mil do Instagram visualizaram o “aviso de violação elegível”. Entre eles, quase 3 milhões optaram por realizar o exercício educativo, com a maioria (mais de 80% no Facebook e mais de 85% no Instagram) completando as etapas e evitando tanto o aviso quanto as restrições na conta resultantes.

Uma pesquisa de feedback realizada pela Meta após o exercício indicou respostas positivas dos usuários, mostrando que o segmento educativo foi bem recebido e que a abordagem de oferecer oportunidades de aprendizado para evitar punições é apreciada.

* Este recurso não se aplica a violações mais graves dos Padrões da Comunidade, como exploração sexual, drogas de alto risco e representação, apoio ou glorificação de organizações consideradas perigosas pela Meta.

Alteração da política Indivíduos e Organizações Perigosas para abrir o debate político

Para cumprir o direito internacional dos direitos humanos, as regras que limitam a liberdade de expressão devem ser claras, precisas e de fácil acesso público. O Comitê aplica esses padrões ao avaliar as políticas da Meta. Desde nossas primeiras decisões, destacamos que a política Indivíduos e Organizações Perigosas da Meta não atende a esses critérios, levando a restrições excessivas em debates políticos na Internet (Citação nazista, Isolamento de Öcalan, Publicação compartilhada da Al Jazeera, Referindo-se a indivíduos perigosos designados como “Shaheed”). Em 2022, o Comitê reverteu a decisão da Meta de remover uma publicação de um artigo de notícias que relatava a declaração de um porta-voz do Talibã sobre a reabertura de escolas para mulheres e meninas. A publicação havia sido removida sob a alegação de que o Talibã foi designado pela Meta — assim como por diversos governos — como uma organização perigosa e que o conteúdo continha uma forma de “elogio” à organização. O Comitê destacou, no entanto, que a publicação apenas relatava ações do Talibã e que a transmissão dessa informação constitui um direito essencial, tanto para quem compartilha quanto para quem recebe, especialmente em períodos de conflito e crise.

Em nossa opinião consultiva política de 2024, destacamos que a Meta divulgou que o termo árabe “shaheed” (traduzido livremente como “mártir”) foi o principal motivo de remoções de conteúdo em todo o mundo, de acordo com os Padrões da Comunidade, mais do que qualquer outra palavra isolada. Essas remoções ocorreram devido à proibição de usar a palavra shaheed próxima ao nome de indivíduos ou organizações considerados perigosos pela empresa. A política presumia que todas essas publicações equivaleriam a uma glorificação de terroristas ou outros atores perigosos — o que nem sempre era o caso. O Comitê observou que o termo shaheed tem diversos significados em diferentes contextos culturais e nem sempre é um termo de elogio. Além disso, a proximidade da palavra com o nome de um indivíduo ou organização perigosa não indica necessariamente que a publicação esteja exaltando a violência. Para corrigir essa questão, solicitamos que a Meta atualizasse sua política Indivíduos e Organizações Perigosas, evitando a remoção automática de referências a esses indivíduos ou organizações quando a palavra shaheed estivesse presente. Após a implementação da maioria de nossas recomendações, a equipe de dados do Comitê registrou um aumento de 19,5% nas publicações diárias com mais de 50.000 visualizações contendo a palavra shaheed.

Em uma decisão de 2025 (Símbolos adotados por organizações perigosas), identificamos novamente lacunas na política Indivíduos e Organizações Perigosas, observando que os critérios internos da Meta para identificar símbolos frequentemente usados por grupos de ódio eram muito mais amplos do que a explicação pública fornecida. É fundamental que a definição completa seja divulgada publicamente para que os usuários compreendam o que não podem publicar. A empresa se comprometeu a atualizar essas informações de forma pública.

Transparência para empoderar usuários e promover a responsabilização

O Comitê incentivou a Meta a ser mais clara sobre as ocasiões em que governos influenciam decisões relacionadas a conteúdo ou às políticas que regem suas plataformas. Nosso objetivo é capacitar os usuários fornecendo informações e dados sobre o funcionamento dos algoritmos de aplicação e sobre a forma como os padrões da comunidade são aplicados ao seu conteúdo. Em resposta às nossas recomendações, a Meta aprimorou sua transparência ao divulgar publicamente erros na aplicação das regras e ao garantir que investigadores independentes tenham acesso aos dados.

Exposição de solicitações governamentais para revisão ou remoção de conteúdo

A influência governamental nas decisões sobre conteúdo pode resultar em censura e gerar um efeito inibidor sobre a liberdade de expressão. Quando o Estado solicita a remoção de conteúdo de forma sigilosa, os usuários não têm como saber se as decisões das plataformas em relação ao seu conteúdo têm motivação política. A transparência é um dos pilares da confiança dos usuários e da sociedade civil nas plataformas online. Ela permite um debate aberto sobre se a ação governamental constitui uma regulação legítima ou censura, aumentando a probabilidade de responsabilização tanto das plataformas quanto dos governos, devido à visibilidade que os usuários têm sobre a interação entre governos e grandes empresas digitais.

Em diversos casos, destacamos a forma desorganizada e opaca como os pedidos de remoção de conteúdo feitos por governos à Meta são apresentados (Publicação compartilhada da Al Jazeera, Isolamento de Öcalan, Drill Music no Reino Unido). A transparência em relação a esses pedidos é fundamental para que os usuários saibam se os governos encaminharam diretamente seu conteúdo à Meta para análise. O caso Drill Music do Reino Unido expôs erros na aplicação da lei, decorrentes de solicitações de remoção feitas pelo Serviço de Polícia Metropolitana de Londres, que resultaram em restrições indevidas à expressão artística de pessoas pertencentes a grupos marginalizados. No caso Isolamento de Öcalan, os usuários foram impedidos de expressar suas preocupações sobre os direitos humanos de um prisioneiro do Partido dos Trabalhadores do Curdistão mantido em confinamento solitário. Em resposta às nossas recomendações nesses casos, a Meta passou a notificar todos os usuários cujo conteúdo foi removido em razão de uma solicitação governamental, informando, salvo impedimento legal, qual entidade governamental fez o pedido.

Ressaltamos a importância de que as plataformas publiquem essas solicitações de forma transparente, recomendando que a Meta implemente um sistema padronizado e disponibilize dados sobre os motivos da remoção de conteúdo nesses casos. A empresa confirmou publicamente a implementação de um novo Sistema de Relatórios de Conteúdo, que inclui perguntas padronizadas a serem respondidas por agentes estatais ao fazerem tais solicitações, abrangendo 97% dos órgãos reguladores qualificados. O uso de um conjunto consistente de perguntas pela Meta no momento das solicitações aumenta a probabilidade de que os governos sigam regras uniformes e diminui o risco de decisões políticas arbitrárias.

Informar aos usuários quais regras o conteúdo violou

Segundo o direito internacional dos direitos humanos, os indivíduos devem ser informados sobre as regras existentes e sobre como exercer seus direitos. Nas plataformas da Meta, os usuários precisam compreender qual parte dos Padrões da Comunidade seu conteúdo supostamente violou e por que medidas punitivas foram aplicadas (Armênios no Azerbaijão, Sintomas de câncer de mama e nudez, Citação nazista, Representação de Zwarte Piet, Insultos contra a África do Sul, Cerveja de ayahuasca, Compartilhamento de informações residenciais privadas). Essa clareza permite que as pessoas ajustem seu comportamento em publicações futuras ou apresentem recursos mais eficazes. Em resposta às nossas recomendações para que a Meta fornecesse essas notificações, desde 2024 a empresa informa aos usuários qual política específica foi supostamente violada quando aplica uma ação de aplicação.

Explicação pública de como funcionam os algoritmos que preveem violações de políticas

Para esclarecer o funcionamento dos classificadores da Meta — um tipo de algoritmo utilizado para prever se determinado conteúdo provavelmente viola as regras — pressionamos a empresa a fornecer uma explicação pública em seu Centro de Transparência. Solicitamos detalhes sobre os limites de precisão preditiva desses classificadores, incluindo situações em que nenhuma ação é tomada, quando o conteúdo é encaminhado para revisão humana ou quando é removido sem passar por revisão humana (Referindo-se a indivíduos perigosos designados como “Shaheed”). Em outras palavras, buscamos que a Meta esclareça qual nível de certeza um algoritmo precisa alcançar sobre uma suposta violação para que o sistema automatizado tenha autorização para remover o conteúdo. A empresa não implementou totalmente todas as nossas recomendações nessa área,

embora tenha respondido incluindo informações a páginas correspondentes do Centro de Transparência, detalhando o funcionamento de sua tecnologia de aplicação de políticas. Ainda assim, permanece evidente a necessidade de maior transparência sobre o funcionamento dos sistemas automatizados, sobre como eles são auditados e de que forma seu desempenho é avaliado.

Definição das exceções às políticas de forma mais clara nos Padrões da Comunidade

Alguns Padrões da Comunidade da Meta incluem exceções e flexibilidades que possibilitam aos usuários publicar conteúdo em certos contextos, mesmo que, à primeira vista, pareça contrariar a política. Por exemplo, essas exceções podem autorizar a publicação de determinados conteúdos quando usados em reportagens ou com o objetivo de conscientização. No entanto, os usuários ficarão em desvantagem se não entenderem quais exceções se aplicam a Padrões da Comunidade específicos. Segundo o direito internacional dos direitos humanos, quaisquer restrições à liberdade de expressão devem ser claramente definidas para que os indivíduos saibam exatamente quais regras devem seguir. Esse requisito não é atendido quando as exceções permanecem ocultas aos usuários. Solicitamos à Meta que resolvesse essa questão, criando uma seção nos Padrões da Comunidade que especificasse as exceções relevantes (Documentário de notícias sobre abuso infantil no Paquistão). No primeiro semestre de 2025, a Meta informou que ainda está avaliando a viabilidade dessa recomendação e explorando maneiras de tornar as permissões mais claras em seu Centro de Transparência.

Melhor gestão de questões graves e proteção de comunidades vulneráveis

Situações de crise frequentemente evidenciam a insuficiência dos processos regulares de moderação. Nossas recomendações levaram a Meta a se tornar mais responsiva em cenários de alto risco, como durante eleições e conflitos. Reconhecendo que há usuários em todo o mundo para os quais as plataformas da Meta representam um meio essencial de encontrar e compartilhar informações, defender o direito à liberdade de expressão — incluindo o direito de transmitir e receber informações — é especialmente crucial em situações de crise, quando o acesso a informações pode ser uma questão de vida ou morte.

Por exemplo, ao analisar diversos casos relacionados à guerra em Gaza, o Comitê defendeu a liberdade de expressão de todos os lados do conflito. Em 2023, em um caso acelerado — no qual as decisões são emitidas em até 30 dias após a aceitação do caso — o Comitê reverteu a decisão da Meta de remover um vídeo no Facebook que mostrava um sequestro durante o ataque terrorista liderado pelo Hamas em 7 de outubro contra Israel, apoiando sua reintegração com uma tela de aviso (Reféns sequestrados em Israel). Em um caso de 2024, o Comitê também reverteu as decisões da Meta de remover uma reportagem do Channel 4 News (Reino Unido) sobre o assassinato de uma criança palestina (Reportagens sobre a guerra em Gaza).

Seguindo a recomendação do Comitê, a Meta implementou um protocolo de crise para garantir que os direitos dos usuários sejam respeitados mesmo em situações de alta pressão. Os usuários se beneficiam quando mais recursos e atenção são dedicados a situações de crise, permitindo que conteúdos que possam causar danos iminentes sejam tratados rapidamente e que informações de interesse público não sejam removidas por engano.

A empresa também introduziu uma estrutura para avaliar como lida com conteúdos durante eleições e implementou proteções mais eficazes no sistema de verificação cruzada, criado pela Meta para evitar a aplicação excessiva de políticas contra usuários de grande repercussão ou aqueles que provavelmente denunciarão erros de remoção à mídia ou à alta direção da empresa.

Desenvolvimento e publicação de uma política de resposta a crises

As plataformas de mídia social precisam estar preparadas para lidar com crises, como conflitos, agitação social, eleições contestadas ou desastres naturais, garantindo que o direito à liberdade de expressão dos usuários seja protegido mesmo em contextos de rápida mudança e alta pressão. Em situações críticas, é necessário adotar processos adicionais que assegurem decisões rápidas, justas e consistentes sobre o conteúdo publicado.

Por essa razão, no nosso primeiro ano de operação, solicitamos à Meta a criação de um Protocolo de Política de Crise (CPP) com o objetivo de permitir que a empresa responda de maneira ágil quando necessário (Suspensão do ex-presidente Trump). Após realizar um fórum abrangente de políticas com diversas partes interessadas, a Meta implementou o CPP em agosto de 2022, incluindo posteriormente uma página dedicada a esse mecanismo em seu Centro de Transparência. O CPP funciona como uma estrutura que intensifica a moderação durante crises, garantindo que a aplicação das políticas seja consistente em todo o mundo. O protocolo é acionado quando critérios predefinidos identificam situações de alto risco, oferecendo ferramentas adicionais para decisões mais rápidas e assertivas. Essa área continua sendo prioridade para o Comitê, que recentemente recomendou ajustes para tornar a ativação do CPP mais ágil e solicitou maior autonomia aos revisores de conteúdo, permitindo que façam julgamentos contextualizados em situações de risco elevado (Publicações em apoio aos motins no Reino Unido, Publicações compartilhando discursos sobre o conflito sírio).

Criação de uma estrutura para mensurar os esforços de integridade eleitoral

Durante o período eleitoral, as plataformas precisam estar preparadas para cumprir suas responsabilidades, garantindo a liberdade de expressão política e prevenindo riscos significativos aos direitos humanos, incluindo o direito de votar. No entanto, sem uma estrutura consistente que oriente a preparação para as eleições, torna-se difícil avaliar se as ações da empresa são adequadas para esses momentos críticos. Em 2023, observamos que a Meta deveria criar uma estrutura voltada à proteção da integridade eleitoral e tornar públicos os esforços realizados nesse sentido (Discurso do General Brasileiro). Instamos a Meta a utilizar o conhecimento local para identificar campanhas coordenadas, tanto na Internet quanto no mundo real, que tenham como objetivo perturbar os processos democráticos, além de estabelecer canais permanentes de feedback para aprimorar continuamente sua resposta em contextos eleitorais marcados por violência política.

Em junho de 2025, a Meta confirmou ter seguido a recomendação do Comitê, desenvolvendo uma estrutura baseada em oito pilares fundamentais voltados à integridade eleitoral. Essa estrutura será aplicada a todo o monitoramento eleitoral da empresa, abrangendo aspectos como gestão de riscos, cooperação com partes interessadas externas, mitigação da disseminação de desinformação e uma abordagem responsável em relação à IA generativa. Embora ainda não tenhamos observado a implementação prática dessa estrutura nem conseguido avaliar sua eficácia, a simples criação do mecanismo representa um avanço positivo.

Implementação de proteções mais eficazes em torno do sistema de verificação cruzada

O sistema de verificação cruzada da Meta foi desenvolvido para aplicar checagens adicionais antes da remoção de conteúdo de alto impacto, ou seja, publicações de contas influentes ou conteúdos que se tornaram virais. No entanto, o sistema levantou sérias preocupações para o Comitê, pois indicava que usuários mais poderosos estavam sendo tratados de maneira diferente, de forma pouco transparente, em detrimento dos usuários comuns. A existência do programa foi revelada por um denunciante do Facebook. Em resposta a essas revelações, o Comitê realizou uma análise detalhada do sistema, aproveitando a oportunidade para obter informações da empresa que permitiram, pela primeira vez, tornar públicas as características e implicações do programa. Em resposta ao nosso parecer consultivo sobre o programa, a Meta admitiu que a “falta de governança” em torno dessas práticas havia permitido a impunidade de alguns usuários.

Fizemos 32 recomendações com o objetivo de implementar mecanismos de proteção mais eficazes no sistema de verificação cruzada e garantir maior equidade entre os usuários, abordando aspectos como: a rapidez na aplicação das políticas e a qualidade das análises; os critérios que determinam a qualificação para a verificação cruzada; a transparência sobre o funcionamento do programa; e a incorporação dos direitos humanos, incluindo o direito de apelação.

Por exemplo, quando uma publicação de um usuário incluído nas listas de verificação cruzada era identificada como violando as políticas da Meta, o conteúdo permanecia no ar por dias enquanto as análises adicionais eram realizadas. Esse intervalo permitia que conteúdos que infringiam as regras se tornassem ainda mais virais e, em casos de material sensível, como pornografia feito por vingança ou ameaças plausíveis, aumentava significativamente o potencial de dano. Recomendamos, portanto, a definição de critérios mais claros de qualificação e maior transparência sobre quem tem direito a análises adicionais e em quais circunstâncias. Em resposta a essas recomendações, a Meta ajustou o processo de construção, auditoria e monitoramento das listas de qualificação. A Meta também tomou medidas para reduzir atrasos no processo de análise, o que resultou em um número significativamente menor de visualizações de conteúdos potencialmente violadores.

Uma de nossas principais recomendações destacava a necessidade de a Meta enfrentar o acúmulo de tarefas nas filas de análise, que fazia com que publicações de usuários de grande repercussão permanecessem na plataforma por semanas ou até meses antes de serem avaliadas e, se necessário, removidas. A empresa abordou essa questão e forneceu os seguintes dados ao Comitê: no primeiro semestre de 2023, para 90% das tarefas criadas nas filas de verificação cruzada, houve uma redução de 96% no tempo de resolução (incluindo análise e aplicação de medidas subsequentes), em comparação com o segundo semestre de 2022.

Investigação de preconceitos na moderação de conteúdo

A percepção de injustiça ou preconceito na moderação de opiniões políticas pode comprometer a legitimidade da governança da plataforma. Esse preconceito pode surgir por diversos motivos, incluindo políticas desatualizadas ou pouco rigorosas, investimento insuficiente em capacitação linguística e competência cultural, além de erros repetidos na aplicação das normas, gerando padrões cíclicos de censura nos quais os sistemas aprendem e reproduzem interpretações equivocadas ao longo do tempo. Em um caso específico, observamos que a remoção incorreta de conteúdos com pontos de vista divergentes sobre o aborto estava prejudicando o debate político (Publicações dos Estados Unidos debatendo o aborto). O Comitê recomendou que a Meta divulgue regularmente ao público os dados utilizados para avaliar a precisão da aplicação da política de Violência e Incitação. Embora a Meta ainda não tenha fornecido esses dados, sua divulgação permitiria verificar se os erros de aplicação — como a remoção de conteúdo que não violava a política — são casos isolados ou indicam problemas sistêmicos.

Em outra situação, ao tratar de preocupações públicas sobre possíveis preconceitos na moderação de conteúdo relacionado a palestinos e israelenses no Facebook, o Comitê sugeriu que uma entidade independente investigasse a existência de preconceito sistêmico na forma como a plataforma modera publicações sobre o conflito (Publicação compartilhada da Al Jazeera). A Meta encomendou então um relatório ao órgão consultivo Business for Social Responsibility, que concluiu que a moderação de conteúdo do Facebook durante o conflito entre Israel e Palestina, em maio de 2021, aparentemente teve impactos negativos sobre os direitos humanos e a liberdade de expressão dos usuários palestinos. Grande parte desse preconceito foi atribuída à insuficiência de recursos linguísticos internos e às orientações inadequadas fornecidas aos moderadores de conteúdo. Além disso, a limitação das capacidades linguísticas contribuiu para que conteúdos antissemitas fossem sub-reprimidos. Em 2022, a Meta respondeu afirmando que contrataria mais moderadores capazes de revisar publicações em dialetos relevantes e que havia implementado um classificador de aprendizado de máquina em hebraico.

Proteção de comunidades vulneráveis

O Comitê tem defendido de forma consistente comunidades vulneráveis, incluindo defensores dos direitos humanos e líderes da oposição em regimes repressivos, protegendo-os contra danos online. Suas decisões resultaram, por exemplo, na remoção de publicações que atacavam pessoas transgênero ou incentivavam violência homofóbica.

Em junho de 2023, ao anular a decisão da Meta de manter no ar um vídeo do Facebook no qual Hun Sen, então Primeiro-ministro do Camboja, ameaçava seus adversários políticos, o Comitê concluiu que manter esse conteúdo ativo era incompatível com as responsabilidades da empresa em relação aos direitos humanos (Primeiro-ministro do Camboja).

Em 2024, ao reverter a decisão da Meta de deixar no ar uma publicação que incitava violentamente o suicídio entre pessoas transgênero, o Comitê solicitou que a empresa aprimorasse suas medidas contra esse tipo de discurso, especialmente em formatos não textuais. Nesse caso, o Comitê identificou que o conteúdo combinava referências parcialmente codificadas ao suicídio com elementos visuais (como a bandeira transgênero) relacionados a grupos com características protegidas. Esse tipo de abordagem foi classificado como “criatividade maliciosa”, termo usado para descrever o uso intencional de linguagem codificada ou memes visuais/textuais que exigem contexto para serem compreendidos, frequentemente empregados por indivíduos que buscam contornar a detecção nas redes sociais (Publicação em polonês direcionada a pessoas trans).

Falhas sistêmicas na aplicação das políticas da Meta foram identificadas em um caso envolvendo um vídeo que infringia quatro Padrões da Comunidade diferentes. O vídeo mostrava homens sendo espancados por supostamente serem gays na Nigéria, país que criminaliza relacionamentos entre pessoas do mesmo sexo. Apesar de ter sido revisado por três moderadores, o conteúdo permaneceu nas plataformas da Meta, representando risco imediato ao expor a identidade das vítimas. O Comitê anulou a decisão original da Meta de manter o vídeo no ar (Violência homofóbica na África Ocidental).

Em outros casos, incluindo uma decisão de 2023 sobre um vídeo no Facebook que mostrava prisioneiros de guerra identificáveis, o Comitê recomendou que a Meta preservasse conteúdos que registrassem graves violações de direitos humanos ou crimes de atrocidade, conforme definidos pelo direito internacional, e, quando adequado, compartilhasse essas informações com autoridades, como tribunais internacionais (Vídeo de prisioneiros de guerra armênios). Em resposta, a Meta afirmou ter implementado as recomendações do Comitê.

Incorporação dos princípios de direitos humanos na IA e na automação

O Comitê passou a obter maior visibilidade sobre alguns dos sistemas automatizados e de IA da Meta, identificando falhas sistêmicas e destacando áreas em que a tecnologia de aplicação de políticas não está funcionando corretamente.

Para garantir que ferramentas de IA e automação sejam usadas de maneira justa e eficaz na aplicação de políticas, bem como na seleção e criação de conteúdo, o Comitê enfatiza a importância de incorporar princípios de direitos humanos em seu design e implementação.

Rótulos de IA empoderam os usuários

Em diversos casos, o Comitê recomendou que conteúdos gerados por IA fossem devidamente rotulados. O objetivo é proteger a liberdade de expressão dos usuários, ao mesmo tempo em que os ajuda a avaliar melhor a autenticidade e a mensagem subjacente do conteúdo (Vídeo alterado do presidente Biden).

Em resposta a essas recomendações, a Meta passou a adicionar rótulos de “Informações de IA” a vídeos, áudios e imagens criados ou alterados por IA no Facebook, Instagram e Threads. Por exemplo, durante um período de 29 dias em outubro de 2024, usuários visualizaram mais de 360 milhões de conteúdos com rótulos de IA no Facebook e 330 milhões no Instagram. Desse número, foram clicados 6 milhões de rótulos no Facebook e 13 milhões no Instagram, indicando interesse dos usuários em saber mais sobre como os conteúdos foram criados.

Novo classificador considera melhor os sinais de texto na aplicação automatizada de imagens

Dada a dimensão das redes sociais, a moderação de conteúdo automatizada é fundamental para assegurar que as regras sejam cumpridas e para proteger os usuários de possíveis danos. Entretanto, a confiança exclusiva na automação pode resultar na remoção de conteúdos legítimos, já que esses sistemas frequentemente têm dificuldade em interpretar contextos complexos — como expressões de ironia, sátira ou crítica — algo que um moderador humano experiente conseguiria identificar com mais precisão. O Comitê tem acompanhado essa questão desde os primeiros casos.

Em 2021, observou-se que os sistemas automatizados da Meta não estavam identificando publicações de conscientização sobre o câncer de mama quando continham imagens com texto sobreposto (Sintomas de câncer de mama e nudez). Expressamos preocupação com a remoção indevida desse tipo de conteúdo, e a Meta respondeu implementando um novo classificador de conteúdo de saúde, com o objetivo de aprimorar as técnicas do Instagram para identificar publicações relacionadas ao câncer de mama. Durante um período de 28 dias em 2023, mais de 1.000 conteúdos sobre o câncer de mama foram enviados para revisão humana, em vez de serem simplesmente removidos. Desde então, a Meta informou que o classificador não apenas melhorou a moderação desse tipo de conteúdo, mas também a aplicação de políticas para imagens com texto de forma mais ampla. O Comitê segue incentivando a Meta a continuar aprimorando essa área e sua capacidade de aplicar políticas com precisão e em grande escala (Conscientização sobre o câncer de mama).

Além disso, nossas recomendações à Meta estão evoluindo para considerar a natureza em constante mudança do conteúdo gerado por IA e os potenciais danos, avaliando se as suas políticas estão se adaptando adequadamente a essa evolução.

Nossa independência serve aos usuários

Em apenas cinco anos, o Comitê evoluiu de um experimento ousado para um modelo consolidado. Possui um corpo crescente de jurisprudência fundamentada em princípios, criando um modelo inédito para aplicar os direitos humanos ao conteúdo online. Embora muitas plataformas tenham órgãos consultivos, o Comitê se diferencia por sua independência legal em relação à Meta. Emitimos decisões e recomendações vinculativas, às quais a empresa é obrigada a responder, e somos compostos por especialistas diversos de todo o mundo. Ainda assim, qualquer novo experimento enfrenta desafios ao conciliar os imperativos de um negócio global lucrativo, usado diariamente por bilhões de pessoas.

A seguir, compartilhamos alguns aprendizados:

- Fazer dos direitos humanos internacionais a base para decisões consistentes e justas: Integrar uma estrutura global de direitos humanos em um modelo de comitê de supervisão independente fortalece a tomada de decisão baseada em princípios e garante consistência. O Comitê avalia a abordagem da Meta em relação à moderação de conteúdo com base no direito internacional dos direitos humanos, divulgando de forma transparente quais tratados e disposições fundamentais orientam nossas decisões. Os pré-requisitos e testes analíticos definidos por esse corpo jurídico ajudam a assegurar que nossa jurisprudência seja consistente e possa ser aplicada de maneira contínua ao longo do tempo. A proteção robusta à liberdade de expressão é um pilar central dessa estrutura global, que também permite restrições quando necessário para proteger direitos de terceiros, a segurança nacional ou a ordem pública. A fundamentação do Comitê no direito internacional dos direitos humanos possibilita que nossas decisões e recomendações tenham aplicação global, em diversas jurisdições. Adaptar obrigações originalmente destinadas a governos para uma empresa privada requer interpretação cuidadosa e criatividade. Mais do que qualquer outra entidade em qualquer setor, o Comitê tem estabelecido essas conexões e criado um modelo prático para transformar as obrigações empresariais em matéria de direitos humanos em realidade concreta.

- Manutenção da independência estrutural: Um órgão de supervisão precisa ser legal, institucional e funcionalmente independente de empresas e governos, garantindo que suas decisões não sofram influência de interesses comerciais ou estatais. Como ocorre no caso do Comitê, isso inclui um mecanismo de financiamento sustentável, permitindo que a entidade gerencie de forma autônoma seu orçamento, liderança, estratégia e operações. Graças ao fundo fiduciário irrevogável do Comitê, nossas operações estão totalmente asseguradas até 2027. Embora nossas decisões e julgamentos sejam independentes, contamos com a cooperação da Meta, que nos fornece informações essenciais para fundamentar nossas deliberações, responde a perguntas, implementa nossas recomendações e nos informa sobre o impacto delas nas políticas da empresa, permitindo avaliar nossa eficácia.

- Incentivo a compromissos sólidos com a implementação: Os órgãos de supervisão aumentam sua efetividade ao estabelecer processos rigorosos para acompanhar a implementação de suas decisões e ao dispor das informações necessárias para isso. No caso do Comitê, nossas decisões sobre a permanência ou remoção de conteúdos específicos são vinculativas para a Meta, conforme previsto em nossa Carta. Além disso, emitimos recomendações não vinculativas para aprimorar a moderação de conteúdo da empresa, que dispõe de 60 dias para apresentar sua resposta. A equipe de dados do Comitê desenvolveu a própria metodologia de pesquisa para analisar de forma independente a implementação de nossas recomendações pela Meta, com os resultados sendo divulgados publicamente em nosso site. Diferentemente dos relatórios da própria Meta, esse processo nos permite exigir comprovantes de implementação e compartilhar nossa própria avaliação das respostas da empresa. Em alguns casos, a Meta optou por não implementar nossas recomendações. Mesmo assim, acreditamos que, ao destacar problemas e tornar públicas informações sobre as práticas da Meta, aumentamos a conscientização, o que pode eventualmente incentivar ações corretivas. Além disso, nosso trabalho oferece à sociedade civil e a outros atores a oportunidade de dialogar com a Meta sobre maneiras de aprimorar ainda mais.

- Capacitação dos tomadores de decisão de todo o mundo: Para refletir a natureza global das plataformas de mídia social, órgãos de supervisão podem se beneficiar ao incluir contribuições de diferentes regiões na tomada de decisões. Os pontos de vista dos 21 membros do nosso Comitê têm sido fundamentais para garantir que fatores regionais e contextos críticos sejam considerados antes de tomar decisões que impactam usuários em todo o mundo. Além disso, buscamos engajar partes interessadas e grupos da sociedade civil globalmente, permitindo que contribuam por escrito em nossos casos ou participem de mesas-redondas com o Comitê, enriquecendo a base de nossas decisões. Esse diálogo também é importante para considerar diferentes realidades regulatórias e direitos dos usuários sob uma perspectiva global.

- Refletir os direitos das pessoas mais dependentes das plataformas: As partes interessadas que dependem dos serviços de uma plataforma ou são impactadas por eles devem ter oportunidades de expressar suas opiniões. Oferecer esses canais de participação confere legitimidade aos órgãos de supervisão. Eles devem ser acessíveis e inclusivos, incentivando a participação de organizações e indivíduos que possam ter enfrentado barreiras para se engajar diretamente com as plataformas. A análise do Comitê é fortalecida pelas contribuições externas, recebidas por meio de um valioso sistema de comentários públicos. Ao promover proativamente esse engajamento, o Comitê recebeu mais de 11.000 comentários públicos de pesquisadores, organizações e indivíduos, ajudando a moldar nossas decisões e incentivando a Meta a cumprir suas responsabilidades em matéria de direitos humanos.

- Promover a segurança desde a concepção: Solicitar contribuições antecipadas de um órgão de supervisão independente sobre inovações de produtos, recursos da plataforma e tecnologias de moderação de conteúdo faz sentido do ponto de vista comercial, pois ajuda a elevar os padrões e a incentivar melhores práticas. O Comitê acredita ser fundamental que os princípios de direitos humanos sejam incorporados desde as fases iniciais de desenvolvimento de tecnologias em rápida evolução. Até o momento, abordamos problemas de design relacionados a recursos das plataformas da Meta por meio de nossas recomendações, identificando oportunidades para aprimorar alguns produtos da empresa. No entanto, em um setor que evolui rapidamente, em que oportunidades de crescimento também trazem riscos aos direitos dos usuários, é necessário que um órgão de supervisão possa expandir seu escopo de forma ágil e responsiva, a fim de enfrentar com eficácia os desafios éticos e sistêmicos.

A evolução do Comitê: um olhar para o futuro

Nos cinco anos em que o Comitê tem analisado recursos, as plataformas de mídia social e a forma como os usuários interagem com elas mudaram de maneira significativa. Durante esse período, nosso trabalho abordou as questões mais controversas da moderação de conteúdo, equilibrando nosso compromisso com a liberdade de expressão e a proteção de outros direitos humanos. Emitimos decisões sobre eleições globais, conflitos e debates sociais, analisamos o design de sistemas de aplicação e destacamos problemas sistêmicos que afetam as plataformas da Meta.

Nosso escopo também se expandiu, passando a incluir tanto a restauração quanto a remoção de conteúdo no Facebook e Instagram, a aplicação de telas de aviso e a cobertura de uma terceira plataforma, o Threads. Em 2026, nosso escopo será ampliado novamente, com a introdução da revisão de decisões da Meta que envolvem a remoção de contas ou impactam usuários, respondendo a uma fonte constante de frustração para a comunidade da plataforma.

Desde o anúncio do Comitê, reconhecemos a magnitude da tarefa à nossa frente e levamos em consideração as preocupações de céticos e críticos que questionavam a legitimidade e a eficácia de nossos esforços. Ao longo dos últimos cinco anos, enfrentamos frustrações e situações em que o impacto esperado não se concretizou. Aprendemos a focar em utilizar ao máximo os poderes e a influência que possuímos para gerar resultados significativos. Temos a capacidade singular de solicitar informações à Meta, obter respostas às nossas perguntas, acompanhar o cumprimento de nossas recomendações e interagir diretamente com os líderes da empresa. Nenhuma outra entidade tem esse nível de acesso. Continuaremos a aproveitar essas oportunidades para revelar o funcionamento interno da Meta aos usuários, oferecendo uma compreensão mais clara de uma empresa que influencia suas vidas. Quando nossas decisões e recomendações são implementadas, elas fortalecem bilhões de pessoas em todo o mundo, permitindo que se expressem e se protejam online.

O caminho adiante: além da moderação de conteúdo

Em 2024, começamos a sistematizar alguns de nossos aprendizados para além de casos individuais, publicando relatórios técnicos sobre eleições e sobre a nova era de IA e automação. Mais recentemente, o Comitê avançou em debates mais amplos sobre governança de conteúdo e responsabilidade das plataformas, aprimorando a forma como a liberdade de expressão é avaliada em avaliações de riscos sistêmicos realizadas sob os novos regulamentos da União Europeia.

Nosso trabalho futuro continuará guiado pelo compromisso de analisar as implicações das tecnologias em evolução para os direitos humanos, tanto no contexto da moderação de conteúdo quanto além dele. Com base no conhecimento adquirido sobre aplicação da lei, automação e IA, o Comitê ampliará seu foco para examinar com maior profundidade a implementação responsável de ferramentas e produtos de IA. Por exemplo, à medida que as plataformas desenvolvem produtos de IA generativa, como chatbots baseados em modelos de linguagem complexos e IA agêntica, surge a questão de como incorporar efetivamente a devida consideração pelos direitos humanos desde o design até o desenvolvimento desses produtos. À medida que a IA generativa transforma a natureza do conteúdo online, surge a questão de quais orientações podem auxiliar o setor a lidar com os danos emergentes associados a essa tecnologia, muitos dos quais refletem os problemas que o Comitê já abordou no contexto das mídias sociais. Esperamos que nossa contribuição para esses debates essenciais ajude a traçar um caminho com perspectiva global, fundamentado nos direitos dos usuários.

O Comitê também está bem posicionado para colaborar com diversas empresas de tecnologia globais, apoiando-as na abordagem de questões relacionadas à liberdade de expressão, especialmente quando a pressão dos governos sobre as plataformas resulta em efeitos censuradores online. Além disso, dedicamos atenção aos desafios enfrentados pelos usuários mais jovens das mídias sociais. Como proteger seus direitos à liberdade de expressão e ao acesso à informação, garantindo ao mesmo tempo sua segurança contra abusos e exploração?

Esses desafios fundamentais exigem o engajamento de uma ampla variedade de perspectivas globais, garantindo o respeito a direitos como a liberdade de expressão, independentemente de divisões políticas, e promovendo a responsabilização contínua das plataformas perante os usuários. O Comitê pretende desempenhar um papel central na integração dessas perspectivas, oferecendo recomendações que abordem alguns dos dilemas políticos e éticos mais complexos que o setor de tecnologia enfrentará nos próximos meses e anos.