साहसी प्रयोग से लेकर ज़रूरी संस्थान तक

स्वतंत्र निगरानी के पांच सालों ने Meta को कैसे ज़्यादा जवाबदेह बनाया और यूज़र के अधिकारों की रक्षा की।

कार्यकारी सारांश

2018 में, Facebook एक ऐसी कंपनी थी, जिसकी व्यापक निंदा हो रही थी। उम्मीद की लहर पर शुरू होने और एक दशक से ज़्यादा समय तक बढ़ने के बाद, दुनिया भर में कंपनी के 2 बिलियन से ज़्यादा यूज़र में गुस्सा बढ़ रहा था। कैम्ब्रिज एनालिटिका डेटा शेयरिंग घोटाले ने, जिसमें लाखों खातों की व्यक्तिगत जानकारी, बिना सहमति के शेयर की गई, यूज़र की निजता के महत्वपूर्ण मुद्दे पर ध्यान खींचा। प्लेटफ़ॉर्म पर नफ़रत फैलाने वाली भाषा से निपटने में नाकामी ने, म्यांमार में रोहिंग्या नरसंहार के दौरान, असल दुनिया में नुकसान और मानवाधिकारों के उल्लंघन को बढ़ावा दिया।

उसी समय, यूज़र ने अपनी अभिव्यक्ति की स्वतंत्रता को बार-बार संकट में जाते देखा, क्योंकि सही राजनीतिक भाषण, कलात्मक आवाज़, जागरूकता बढ़ाने वाले कंटेंट और व्यंग्य, सभी को ऐसे नियमों के नाम पर Facebook और Instagram से हटाया जा रहा था, जो स्पष्ट नहीं थे और मनमाने थे।

महत्वपूर्ण चुनावों के दौरान, भ्रामक जानकारी और गलत जानकारी की वजह से यूज़र के लिए सोच-समझकर फ़ैसले लेना और भी मुश्किल हो रहा था और नतीजों को भी तोड़-मरोड़कर पेश किया जा रहा था। खुद को नुकसान पहुंचाने और खतरनाक कार्यों को दिखाने और बढ़ावा देने वाला कंटेंट ज़्यादा प्रचलित हो गया। अमेरिका से बाहर के यूज़र को अपने इलाकों के हिसाब से सीमित कंटेंट मॉडरेशन का सामना करना पड़ा, जिसमें स्थानीय भाषाओं, संस्कृति या राजनीतिक संदर्भ को ध्यान में नहीं रखा गया।

इससे भी बुरी बात यह थी कि यूज़र को अक्सर यह पता नहीं होता था कि अगर उनका कंटेंट हटा दिया गया है, तो वे कैसे अपील करें या उन्होंने कथित तौर पर कौन से नियम तोड़े हैं। उन एल्गोरिदम और प्रक्रिया के बारे में पारदर्शिता की कमी थी, जिनसे यह तय होता था कि कौन सा कंटेंट प्लेटफ़ॉर्म पर रहेगा या हटाया जाएगा।

Facebook के अंदर, यह माना जाता था कि कंटेंट मॉडरेशन के इतने परिणामी फ़ैसले, कॉर्पोरेट अधिकारियों के ग्रुप को खुद ही नहीं लेने चाहिए। यही कारण था कि Facebook, जिसे अब Meta कहा जाता है, ने 2018 में ओवरसाइट बोर्ड बनाने की घोषणा की। बोर्ड ने अक्टूबर 2020 में अपने पहले केस का चयन किया। यह अब भी अपनी तरह का अकेला निगरानी निकाय है।

यूज़र के लिए पारदर्शिता और मानवाधिकार का नज़रिया

पांच साल बाद, बोर्ड ने Meta के दुनिया भर में फैले यूज़र के लिए ज़रूरी कदम उठाए हैं। यह उन फ़ैसलों में पारदर्शिता, तार्किकता और मानवाधिकार का नज़रिया लाता है, जो लंबे समय से बंद दरवाजों के पीछे लिए जाते थे, और जिनके बारे में जनता को बहुत कम या कोई तर्क नहीं दिया जाता था। हमने जो मॉडल बनाया है, उसमें दुनिया भर के विशेषज्ञ, Meta के प्लेटफ़ॉर्म पर मौजूद संवेदनशील कंटेंट से जुड़े फ़ैसलों का स्वतंत्र रिव्यू करते हैं, जिसमें जनता और नागरिक समाज का इनपुट होता है। हमारे बोर्ड मेंबर राजनीतिक,

वैचारिक, भौगोलिक, सांस्कृतिक और व्यावसायिक रूप से विविधता वाले हैं। इसका मतलब है कि हम दुनिया के अलग-अलग हिस्सों में, अपनी बात कहने के अधिकार और दूसरे मानवाधिकार पर असर डालने वाले अलग-अलग संदर्भों का बेहतर तरीके से ध्यान रख सकते हैं। बोर्ड इस बारे में बाध्यकारी फ़ैसले लेता है कि कंटेंट को बनाए रखा जाए या हटाया जाए। हम सिस्टम में सुधार के लिए भी महत्वपूर्ण सुझाव देते हैं।

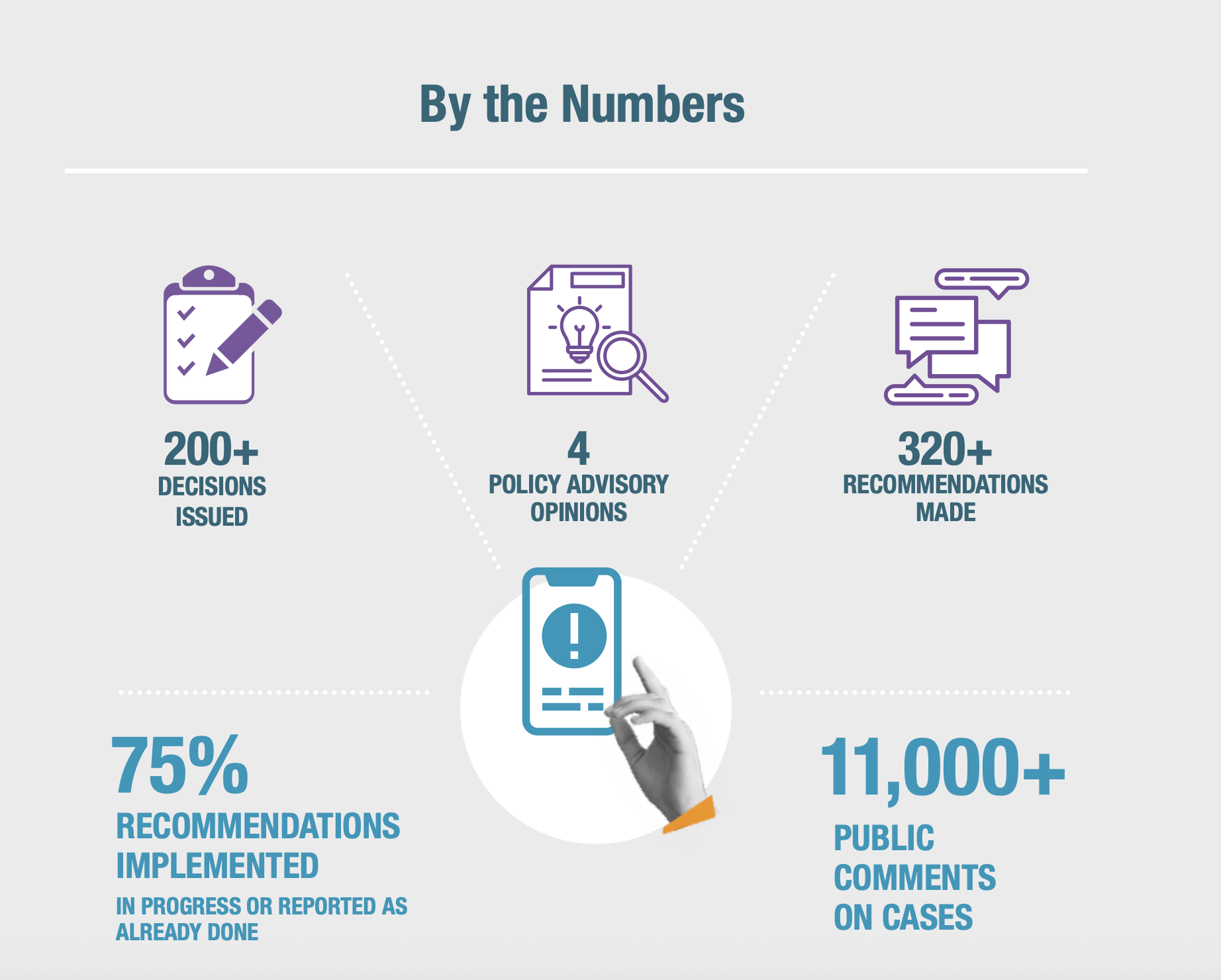

Meta किसी खास कंटेंट को बनाए रखने-हटाने के फ़ैसलों का सम्मान करने के लिए प्रतिबद्ध है और उसे हमारे सुझावों पर सार्वजनिक रूप से जवाब देना ज़रूरी है, कंपनी ने ये दोनों वादे पूरे किए हैं। हालांकि हर सुझाव को लागू करना Meta के लिए कानूनी रूप से ज़रूरी नहीं है, लेकिन इसने हमारे जारी किए गए 300 से ज़्यादा सुझाव में से 75% को लागू किया है, जिससे ज़्यादा पारदर्शिता और जवाबदेही आई है। सभी सुझावों से, कंटेंट मॉडरेशन पॉलिसी और एन्फ़ोर्समेंट पर बातचीत और बहस को बेहतर बनाने में मदद मिली।

दुनिया भर में फैले Facebook, Instagram और Threads के कई मिलियन यूज़र के लिए इसका नतीजा बहुत अच्छा रहा है, जो कि Meta द्वारा जागरूकता बढ़ाने वाले कंटेंट और व्यंग्य का बेहतर तरीके से बचाव करने के लिए एल्गोरिदम को अपनाने से लेकर नियम तोड़ने वाले और सज़ा का सामना करने वाले यूज़र के लिए बेहतर प्रक्रिया अपनाने और उन्हें दूसरा मौका देने तक को सुनिश्चित करने से मिला है।

बोर्ड के कार्य की वजह से, Meta एक ज़्यादा जवाबदेह, ज़्यादा पारदर्शी और बेहतर जानकारी वाली कंपनी है, हालांकि अभी भी बहुत कुछ करना बाकी है। बोर्ड ने साबित कर दिया है कि ऐसी स्वतंत्र निगरानी, जिसे कंटेंट पर बाध्यकारी फ़ैसले लेने और ऐसे गैर-बाध्यकारी सुझाव देने का अधिकार है, जिनके लिए सार्वजनिक प्रतिक्रिया की ज़रूरत होती है, असल में काम करती है, और, महत्वपूर्ण रूप से, दूसरे प्लेटफ़ॉर्म के लिए अनुसरण करने के लिए एक फ़्रेमवर्क के तौर पर काम कर सकती है।

बोर्ड को शुरू करने, उसे वित्तीय सहायता देने, उसके द्वारा स्वतंत्र फ़ैसले लिया जाना सुनिश्चित करने के लिए सुरक्षा उपाय लागू करने और उसे फ़ैसले और सुझाव देने का अधिकार देने का Meta का फ़ैसला ऐसा था, जो पहले कभी नहीं हुआ। उस समय, उम्मीद थी कि दूसरे सोशल मीडिया प्लेटफ़ॉर्म भी स्वतंत्र निगरानी के ज़रिए, यहां तक कि खुद बोर्ड के साथ जुड़कर भी, यूज़र के प्रति खुद को ज़्यादा ज़िम्मेदार बनाने के लिए ऐसे ही कदम उठाएंगे। अब तक, किसी ने ऐसा नहीं किया है। Meta के साथ बोर्ड की बातचीत में लगातार पक्ष-समर्थन और वार्ताएं शामिल हैं, और बोर्ड को कभी भी उतना ऐक्सेस या प्रभाव नहीं मिलता, जितना वह चाहता है। फिर भी, बोर्ड उन जोख़िमों और दायित्वों का बहुत सम्मान करता है, जिन्हें Meta, कंपनी की मानवाधिकार ज़िम्मेदारियों को कायम रखने के लिए और ज़्यादा काम करने के नाम पर स्वैच्छिक रूप से ग्रहण करता है।

बोर्ड एक प्रयोग के तौर पर शुरू हुआ था, और हमने उसी भावना, सीखने और बेहतर बनने के लिए उत्सुकता, से अपना कार्य किया है। प्राथमिकता तय करने, केस का चयन करने, अपने फ़ैसलों के लिए जानकारी इकट्ठा करने, परिणामी सुझाव तैयार करने और उन्हें लागू करने पर नज़र रखने के अपने तरीकों को बेहतर बनाने में हमें समय लगा है। Meta के यूज़र की तरफ से हमने जो हासिल किया है, उस पर हमें गर्व है। प्लेटफ़ॉर्म के वैश्विक प्रभाव, अपने दायरे की सीमाओं और बनी रहने वाली व्यापक चुनौतियों के बारे में भी हमारा दृष्टिकोण स्पष्ट है। भविष्य में, हम पूरी प्रौद्योगिकी इंडस्ट्री में मानवाधिकारों का सम्मान कायम रखने के लिए एक शक्ति के तौर पर अपनी विशेष भूमिका को और बेहतर बनाने के लिए प्रतिबद्ध हैं।

यूज़र के लिए हमारी उपलब्धियां

ओवरसाइट बोर्ड के कार्य से लोगों को इस बारे में ज़्यादा समझ मिली है कि Meta के सिस्टम कैसे काम करते हैं। जब हम कंपनी के कंटेंट मॉडरेशन में मौजूद जोख़िम या कमियों का पता लगाते हैं, तो हम ऐसे समाधान बताते हैं, जो सीधे Meta की पॉलिसी, प्रक्रिया और एन्फ़ोर्समेंट प्रौद्योगिकी और तरीकों को तय करते हैं। हमने जनवरी 2021 से जब से फ़ैसले देना शुरू किया है, हमने यूज़र की तरफ़ से ये उपलब्धियां हासिल की हैं:

- अभिव्यक्ति की स्वतंत्रता को बढ़ाना: जब हम कोई फ़ैसला देते हैं, तो हम सिर्फ़ एक पोस्ट का ही नहीं, बल्कि एक सिद्धांत का भी बचाव करते हैं: यह कि ऑनलाइन सार्वजनिक जगह, अलग-अलग तरह की आवाज़ों के लिए खुली और सुरक्षित रहनी चाहिए, तब भी जब बात विवादित, आपत्तिजनक या सत्ता में बैठे लोगों की बुराई करने वाली हो। हमारे सुझावों ने Meta की पॉलिसी और एन्फ़ोर्समेंट के तरीकों को बदल दिया है, ताकि Facebook, Instagram और Threads पर ज़्यादा आवाज़ बनी रहे। यह रिपोर्ट बताती है कि बोर्ड ने इन मुद्दों को कैसे संभाला, जिनमें शामिल हैं: ईरान में, जहां राजनीतिक आवाज़ की रक्षा के लिए “खमेनेई के साथ” बयानों को रिस्टोर किया गया; अफ़गानिस्तान में, जहां तालिबान पर ज़्यादा चर्चा और रिपोर्टिंग की अनुमति दी गई थी, अगर यह जनहित में हो; और उत्तरी अमेरिका में, जहां बोर्ड ने एक देहाती कलाकार की पोस्ट को रिस्टोर किया, जिसने देहाती लोगों के खिलाफ़ पुराने अपराधों के बारे में जागरूकता बढ़ाई।

- यूज़र को सशक्त बनाने और जवाबदेही बढ़ाने के लिए पारदर्शिता: यूज़र के प्रति निष्पक्ष होने के लिए, हमने इस बात पर ज़ोर दिया है कि Meta अपने नियमों और कंटेंट के खिलाफ़ उठाए जाने वाले कदमों के बारे में ज़्यादा पारदर्शी हो। यूके में, बोर्ड ने ड्रिल म्यूज़िक के एक केस में एन्फ़ोर्समेंट की गलतियों का पता लगाया, जिसने हाशिए पर पड़े समूहों के लिए कलात्मक अभिव्यक्ति को अनुचित तरीके से प्रतिबंधित कर दिया था। कई केस में हमने Meta पर दबाव डाला कि वह यूज़र को बताए कि जब वह एन्फ़ोर्समेंट एक्शन लेता है, तो यूज़र का कंटेंट कथित तौर पर किस विशिष्ट पॉलिसी का उल्लंघन करता है, यह एक प्रथा है, जिसे कंपनी ने 2024 से लागू किया।

- उच्च जोख़िम वाले मुद्दों से बेहतर तरीके से निपटना और असुरक्षित समुदायों की सुरक्षा करना: हमारे सुझावों ने संघर्षों और संकटों के प्रति ज़्यादा ध्यान देने और उन पर उत्तरदायी प्रक्रियाओं को बढ़ावा दिया है। विशेष रूप से, Meta ने एक क्राइसिस प्रोटोकॉल पॉलिसी और चुनावों के दौरान कंटेंट को संभालने के लिए एक फ़्रेमवर्क लागू किया है। कंपनी ने अपने क्रॉस-चेक सिस्टम में पक्षपात का भी समाधान किया है। क्रॉस-चेक का मकसद हाई-प्रोफ़ाइल यूज़र और ज़्यादा दर्शकों वाले पेजों को संभावित रूप से उल्लंघन करने वाले कंटेंट पर अतिरिक्त रिव्यू देना है, लेकिन इसे गलत तरीके से लागू किया जा रहा था, जिससे सामान्य यूज़र को नुकसान हो रहा था। इसके अलावा, बोर्ड ने असुरक्षित समुदायों, जैसे कि दमनकारी शासन व्यवस्थाओं में मानवाधिकार रक्षक और विपक्षी नेता, का लगातार बचाव किया है, और हमारे फ़ैसलों के कारण समलैंगिकता-विरोधी हिंसा को बढ़ावा देने वाली पोस्ट हटाई गई हैं।

- AI और ऑटोमेशन में मानवाधिकार सिद्धांतों को शामिल करना: हम ऐसे सुझाव देने की गति तेज़ कर रहे हैं, जो मानवाधिकारों के नज़रिए से उन क्षेत्रों को उजागर करते हैं, जिनमें Meta की नीतियां और सिस्टम, AI की मदद से बनाए गए कंटेंट के साथ तालमेल नहीं बैठा पा रहे हैं। बोर्ड के सुझावों ने Meta को AI लेबल लगाने के लिए प्रेरित किया है, जिसके कारण उन्हें हेरफेर किए गए कंटेंट के कई बिलियन पीस पर लगाया गया है, ताकि यूज़र को विश्वसनीयता का आकलन करने का अधिकार मिले। 2021 में, हमने इस बात पर ज़ोर दिया था कि Meta के ऑटोमेटेड सिस्टम, स्तन कैंसर के बारे में जागरूकता बढ़ाने वाली पोस्ट को गलती से हटा रहे थे, जिसके बाद ऐसे बदलाव आए, जो ऐसे कंटेंट को ज़्यादा सुरक्षा देते हैं।

हमारे निष्कर्ष

कठोर सुझाव देने की हमारी क्षमता, हमारे अनूठे मॉडल के डिज़ाइन से पैदा हुई है। हमारे वैश्विक विशेषज्ञों द्वारा मुद्दों पर व्यक्त किए गए विचारों की विविधता, केस में पब्लिक कमेंट को आमंत्रित करने और हमारे मानवाधिकार-आधारित दृष्टिकोण ने पिछले पांच वर्षों में हमारे कार्य को सक्षम बनाया है।

बोर्ड मेंबर के स्वतंत्र निर्णय को कई तंत्रों की एक शृंखला के माध्यम से संरक्षित किया जाता है, जिनमें शामिल हैं: बोर्ड का अपना नेतृत्व होना; बोर्ड मेंबर के लिए निश्चित कार्यकाल; एक अपरिवर्तनीय ट्रस्ट के माध्यम से निश्चित वित्तपोषण; और, यदि Meta हमारे निर्णयों से असहमत होता है, तो वह पहले से प्रतिबद्ध धनराशि को वापस नहीं ले सकता है।

जैसे-जैसे हम आगे बढ़ रहे हैं, हम यूज़र, प्रौद्योगिकी कंपनियों और पॉलिसी बनाने वालों के लिए अपने निष्कर्ष बताते हैं, उन खास बातों को बताते हैं, जिनकी वजह से हम एक ऐसा कंटेंट संचालन निगरानी मॉडल बना पाए हैं, जो काम करता है। हम उन रुकावटों के बारे में भी बात करते हैं, जिनका हमें इस दौरान सामना करना पड़ा।

भविष्य की संभावनाएं

हमारा स्वतंत्र निगरानी मॉडल, Meta के प्लेटफ़ॉर्म पर ज़्यादा पारदर्शिता, जवाबदेही, खुले आदान-प्रदान और स्वतंत्र अभिव्यक्ति और अन्य मानवाधिकारों के सम्मान को आगे बढ़ा रहा है, जिससे दुनिया भर में यूज़र के अधिकार मज़बूत हो रहे हैं। फिर भी, बोर्ड को इंडस्ट्री के सामने आने वाली चुनौतियों के बारे में कोई भ्रम नहीं है, क्योंकि AI के क्षेत्र में तेज़ी से प्रगति, सोशल मीडिया विनियमन और यूज़र के खुद को व्यक्त करने के अधिकारों पर भू-राजनीतिक झगड़े इस बात को मुश्किल बना देते हैं कि बड़े पैमाने पर कंटेंट को सबसे अच्छे तरीके से कैसे नियंत्रित किया जाए।

हम इन चुनौतियों से निपटने के लिए, विशिष्ट केस से आगे बढ़कर, AI और ऑटोमेशन के नए दौर सहित मुख्य प्राथमिकताओं पर श्वेत-पत्रों में अपने निष्कर्षों को औपचारिक रूप देने की उम्मीद करते हैं। हम कंटेंट संचालन और प्लेटफ़ॉर्म की जवाबदेही पर बड़ी बातचीत की ओर एक कदम पहले ही बढ़ा चुके हैं। बोर्ड कई वैश्विक कंपनियों के साथ साझेदारी करने के लिए भी अच्छी स्थिति में है, क्योंकि वे दुनिया भर में स्वतंत्र आवाज़ की बहस से पैदा होने वाले मुद्दों को सुलझा रही हैं। भले ही दुनिया बदल रही हो, हम अपने शुरुआती मिशन के प्रति प्रतिबद्ध हैं – स्वतंत्र अभिव्यक्ति और दूसरे मानवाधिकारों को नई प्रौद्योगिकी में शामिल करना और यूज़र के लिए जवाबदेही को आगे बढ़ाना।

स्वतंत्र अभिव्यक्ति को बढ़ाना

अभिव्यक्ति की स्वतंत्रता की रक्षा करने के हमारे शुरुआती मकसद के समर्थन में, हमने ऐसी स्थितियों की पहचान की है, जिनमें Meta के मॉडरेशन ने अभिव्यक्ति पर अनुचित रूप से प्रतिबंध लगाया है, जिससे ऑनलाइन राजनीतिक टिप्पणी, खुद को व्यक्त करने और सार्वजनिक विमर्श में बाधा उत्पन्न हुई है। हमारे सुझाव, राजनीतिक विरोध प्रदर्शन, खबरों की रिपोर्टिंग और जनहित और व्यक्तिगत अभिव्यक्ति के विषयों पर जागरूकता बढ़ाने सहित, बातों को गलत तरीके से हटाने से रोकने के लिए डिज़ाइन किए गए हैं, साथ ही अन्य मानवाधिकारों की भी रक्षा करते हैं।

प्रतिदिन कंटेंट के कई बिलियन पीस पोस्ट होने के बीच, हमारे सुझाव, Meta के सिस्टम से होने वाली मॉडरेशन की गलतियों को कम करने के लिए भी हैं। हम ऐसा Meta के ऑटोमेटेड सिस्टम और मानवीय रिव्यू प्रक्रिया के उन पहलुओं को पहचानने की कोशिश करके करते हैं, जो गलत मतलब निकालने, बारीकियों या संदर्भ पर ध्यान न देने, या लागू पॉलिसी अपवादों को लागू न करने की वजह से यूज़र के कंटेंट को हटाने की संभावना रखते हैं।

हिंसा की अविश्वसनीय धमकियों वाली अभिव्यक्ति की बाधाओं को हटाना

हमने Meta द्वारा राजनीतिक कंटेंट को गलत तरीके से हटाने के फैसलों को बार-बार बदला है, जहां उस कंटेंट में हिंसा की आलंकारिक धमकियां थीं—चाहे वह किसी आगामी चुनाव, राजनीतिक घोटाले या विरोध प्रदर्शन आंदोलन से संबंधित हो (रूसी कविता, जापानी प्रधानमंत्री के बारे में बयान, पाकिस्तानी संसद में भाषण की रिपोर्टिंग)। चुनाव और राजनीति में अक्सर तल्ख भाषा तथा उपमा और अतिशयोक्ति का प्रयोग होता है। यूज़र को खुलकर, मुक्त रूप से राजनीतिक अभिव्यक्ति करने में सक्षम होना चाहिए, जिसमें राष्ट्रपति या प्रधानमंत्री जैसे प्रमुख व्यक्तियों की आलोचना भी शामिल है, और इसके लिए प्लेटफ़ॉर्म को इस तरह की अभिव्यक्ति पर अनावश्यक बाधाएं नहीं खड़ी करनी चाहिए। हमने Meta पर लगातार ज़ोर डाला है कि वह वास्तविक दुनिया में जोख़िम पैदा कर सकने वाली हिंसक धमकियों और उस भाषा के बीच स्पष्ट और परिष्कृत अंतर करे, जो भले ही कठोर हो, लेकिन आलंकारिक रूप में प्रयुक्त हो रही हो और इसलिए राजनीतिक बहस की सीमाओं के भीतर आती हो।

2022 के ईरानी “महिला, जिंदगी, स्वतंत्रता” से जुड़े एक केस में, हमने तर्क दिया कि “मार्ग बार खमेनेई” वाले बयानों को Meta के धमकी-विरोधी नियमों का उल्लंघन नहीं माना जाना चाहिए (ईरान में विरोध प्रदर्शन का नारा)। इस वाक्यांश का एक से अधिक तरीके से अनुवाद किया जा सकता है (जैसे, “खमेनेई की मौत” – ईरान के सर्वोच्च नेता अयातुल्लाह खमेनेई), लेकिन इस संदर्भ में इसका उपयोग राजनीतिक बयानबाज़ी के रूप में किया जा रहा था, जिसका अर्थ “खमेनेई के साथ” था। Meta ने चल रहे विरोध प्रदर्शनों के संदर्भ में हमारे विश्लेषण से सहमति व्यक्त की और ऐसे वक्तव्यों को अनुमति देने के लिए अपना फ़ैसला बदल दिया। इसके परिणामस्वरूप, नए फ़ैसले को लागू किए जाने के बाद, उसी तरह के पेजों, समूहों और खातों में इस बयान वाली Instagram पोस्ट में 29% की वृद्धि दर्ज की गई।

और, हमारे सुझाव पर प्रतिक्रिया में, Meta अब “मौत का आह्वान” से संबंधित अभिव्यक्ति पर एक पॉलिसी विकसित करने की प्रक्रिया चला रहा है, ताकि यह विचार किया जा सके कि जब ऐसी अभिव्यक्ति गैर-धमकीपूर्ण संदर्भों में, “जैसे कि मज़ाक, संगीत और मौत के आलंकारिक आह्वान” में उपयोग की जाए, तो कंपनी का दृष्टिकोण क्या होना चाहिए। बोर्ड ने इस प्रक्रिया में भाग लिया है और पॉलिसी और एन्फ़ोर्समेंट संबंधी संभावित परिवर्तनों पर Meta को फ़ीडबैक प्रदान किया है।

विपक्ष की आवाज़ों के दबाए जाने से रोकना

हिंसा की विश्वसनीय ऑनलाइन धमकियां, भले ही वे अभिव्यक्ति का रूप हों, खुली चर्चा और राजनीतिक बहस के प्रतिकूल होती हैं, विशेषकर तब, जब वे सत्ता में बैठे लोगों की ओर से आती हैं। विशेष रूप से राजनीतिक रूप से दमनकारी परिवेशों में, सामाजिक मीडिया, जिसमें Meta के प्लेटफ़ॉर्म भी शामिल हैं, अक्सर सार्वजनिक विमर्श के लिए अत्यंत महत्वपूर्ण मंच होते हैं। यदि विभिन्न आवाज़ें, जिनमें राजनीतिक असंतोष की आवाज़ें भी शामिल हैं, डरा-धमकाकर प्रभावी रूप से दबा दी जाती हैं, तो बहस की गुणवत्ता गिर जाती है। बोर्ड ने इस बात पर ज़ोर दिया है कि स्वतंत्र अभिव्यक्ति के सिद्धांतों को कायम रखने की Meta की ज़िम्मेदारी, उससे यह सुनिश्चित करने की मांग करती है कि उसके प्लेटफ़ॉर्म पर भय के माहौल के कारण ऐसी आवाज़ें व्यवहार में बहिष्कृत न हो जाएं (कंबोडियाई प्रधानमंत्री, पेरू में मानवाधिकार रक्षक)।

कभी-कभी लोगों के खिलाफ गंभीर हिंसा की धमकियां, अप्रत्यक्ष या छिपे हुए रूप में होती हैं, और इसलिए संदर्भ को ध्यान में रखते हुए अधिक गहन मानवीय रिव्यू की आवश्यकता होती है। बोर्ड ने ऐसी धमकियों के केस में अल्प-एन्फ़ोर्समेंट (यानी कंटेंट को हटाए बिना गलती से छोड़ देना) के जोख़िम को लेकर चेतावनी दी है और Meta से आग्रह किया है कि वह विभिन्न सांस्कृतिक और राजनीतिक संदर्भों में अप्रत्यक्ष धमकियों की पहचान करने के लिए अतिरिक्त संसाधन लगाए (पेरू में मानवाधिकार रक्षक)। इस पर प्रतिक्रिया में, कंपनी ने बताया है कि वह अपने आकलनों में कोडित धमकियों के लिखित, दृश्यात्मक और मौखिक संकेतों को और अधिक स्पष्ट रूप से शामिल करने के तरीकों की जांच कर रही है, और इस फ़्रेमवर्क को और सुदृढ़ करने की प्रतिबद्धता भी जताई है।

Meta के प्लेटफ़ॉर्म पर जनहित से जुड़ी अभिव्यक्ति का संरक्षण

कई केस में, बोर्ड ने यह फ़ैसला दिया है कि Meta ने ऐसे कंटेंट को गलत तरीके से हटा दिया, जो भले ही कंपनी के कम्युनिटी स्टैंडर्ड का उल्लंघन करता प्रतीत होता हो, लेकिन फिर भी उसमें जनहित का महत्व है और इसलिए कंपनी की “ख़बरों में बने रहने लायक” अनुमति के अंतर्गत उसे हटाने से मुक्त रखा जाना चाहिए। मैक्सिको के एक केस में, बोर्ड ने ख़बरों में रहने लायक अनुमति के तहत, मैक्सिको में महापौर पद के प्रत्याशी जोस अल्फ़्रेडो कैबरेरा बैरिएंटोस की हत्या को दर्शाने वाली एक पोस्ट को रिस्टोर किया (मैक्सिको में महापौर पद के प्रत्याशी की हत्या)। और हैती के केस में, बोर्ड ने इसी छूट के तहत, Meta के उस फ़ैसले को बदल दिया, जिसमें पुलिस स्टेशन में लोगों के प्रवेश और हिंसा की धमकी दिखाने वाले Facebook वीडियो को हटाया गया था (हैती पुलिस स्टेशन वीडियो)। इन फ़ैसलों ने समयोचित और सार्वजनिक चिंता के विषयों पर बहस और अभिव्यक्ति की अनुमति देने के महत्व को रेखांकित करते हुए, Meta के प्लेटफ़ॉर्म पर यूज़र के स्वतंत्र अभिव्यक्ति के अधिकार का विस्तार किया है।

नियमों का उल्लंघन करने वाले के रूप में गलत तरीके से पहचाने गए कंटेंट को हटाए जाने से रोकना

Meta उन तस्वीरों और वीडियो को, जिन्हें मानवीय रिव्यूअर ने कंपनी के नियमों का उल्लंघन करते हुए पाया है, अपने मीडिया मैचिंग सर्विस बैंकों में जोड़ देता है। इसके बाद, हर बार जब वही कंटेंट, प्लेटफ़ॉर्म पर दोबारा दिखाई देता है, तो ये बैंक अपने-आप उसकी पहचान करके उसे हटा सकते हैं, भले ही उसे किसी ने भी पोस्ट किया हो। लेकिन कभी-कभी रिव्यूअर गलतियां कर देते हैं, जैसा कि कोलंबिया में पुलिस हिंसा का चित्रण करने वाले एक कार्टून से जुड़े 2022 के केस में हुआ (कोलंबियाई पुलिस कार्टून)। जब ऐसा कंटेंट, जो वास्तव में नियमों का उल्लंघन नहीं करता, फिर भी इन बैंकों में बना रहता है, तो मॉडरेशन के गलत फ़ैसलों का प्रभाव कंटेंट के हज़ारों या यहां तक कि लाखों पीस तक बढ़ जाता है। इसी कारण हमने Meta से आग्रह किया कि वह यूज़र की सफल अपीलों की दर वाले कंटेंट के पुनर्मूल्यांकन के लिए एक व्यवस्था विकसित करे, और जैसे ही उस कंटेंट को गैर-उल्लंघनकारी पाया जाए, उसे बैंक से हटा तुरंत दिया जाए। इसके बाद Meta ने इस सिस्टम के प्रबंधन को बेहतर बनाने के लिए एक आंतरिक टीम गठित की है, जिसके परिणामस्वरूप “स्पाइक” पहचान तंत्र लागू किया गया है, जो कि गैर-उल्लंघनकारी कंटेंट की बड़ी मात्रा को जल्दी पहचानने में मदद करता है और यह सुनिश्चित करता है कि उसे बैंक से हटाया जाए, ताकि यूज़र द्वारा पोस्ट किए जाने पर Meta के ऑटोमेटेड सिस्टम द्वारा उसे गलत तरीके से न हटाया जाए।

कंटेंट हटाए जाने के खिलाफ़ अपील करते समय लोगों को संदर्भ शेयर करने की अनुमति देना

लोगों को अपनी बात रखने का अवसर देना और उनकी बात सुनना, प्लेटफ़ॉर्म को यह तय करते समय बेहतर फ़ैसले लेने में मदद कर सकता है कि क्या किसी कंटेंट को हटाया जाना है। नफ़रत फैलाने वाली भाषा की निंदा करने, उस पर व्यंग्य करने या जागरूकता बढ़ाने के उद्देश्य से की गई पोस्ट को गलती से हटाए जाने (अति-एन्फ़ोर्समेंट) से बचने के लिए, हमने Meta से अनुरोध किया कि वह यूज़र को अपनी अपील में यह संकेत देने का एक सुविधाजनक तरीका उपलब्ध कराए कि उनकी पोस्ट इन श्रेणियों में से किसी एक के अंतर्गत आती थी (“टू बटन” मीम, निजी आवासीय जानकारी शेयर करना)। अगस्त और नवंबर 2023 के दौरान, कंपनी ने Facebook और Instagram यूज़र के लिए अपील सबमिट करते समय, अतिरिक्त संदर्भ जोड़ने की सुविधा शुरू की, जिससे वे अपनी पोस्ट की प्रकृति समझा सकें और यह स्पष्ट कर सकें कि वह गैर-उल्लंघनकारी क्यों है। कंपनी ने बताया कि फ़रवरी 2024 के दौरान 7 मिलियन से अधिक अपीलें उन लोगों से प्राप्त हुईं, जिनके कंटेंट को नफ़रत फैलाने वाले आचरण संबंधी नियमों के तहत हटाया गया था। इन अपील करने वालों में से 80% यूज़र ने अतिरिक्त संदर्भ प्रदान करने का विकल्प चुना। अतिरिक्त संदर्भ जोड़ने का यह अवसर अब सभी कम्युनिटी स्टैंडर्ड के अंतर्गत यूज़र अपीलों के लिए उपलब्ध करा दिया गया है।

यूज़र की अभिव्यक्ति पर पड़ने वाले बोझ को कम करने के लिए शैक्षणिक पहल की पेशकश

यूज़र की अभिव्यक्ति पर लगने वाले सबसे बड़े दंडों में से कुछ स्ट्राइक और खाते पर लगाए गए प्रतिबंधों के रूप में आते हैं, जो कंटेंट के खिलाफ Meta के एन्फ़ोर्समेंट का हिस्सा होते हैं। हमारी पहली पॉलिसी से संबंधित सलाह (निजी आवासीय जानकारी शेयर करना) से ही, हमने Meta से आग्रह किया है कि वह अभिव्यक्ति पर असंगत प्रभावों से बचने के लिए वैकल्पिक उपायों पर विचार करे।

2025 की शुरुआत में, बोर्ड के एक सुझाव को लागू करते हुए, Meta ने उन यूज़र को एक “योग्य उल्लंघन नोटिस” भेजना शुरू किया, जो पहली बार ऐसे उल्लंघन करते हैं, जिसे Meta कम्युनिटी स्टैंडर्ड का “गैर-गंभीर”* उल्लंघन मानता है। इस नोटिस में उस पॉलिसी का विवरण शामिल होता है, जिसका कथित उल्लंघन यूज़र ने किया है, साथ ही यूज़र को या तो निर्णय के खिलाफ़ अपील करने या लागू नीतियों को बेहतर ढंग से समझने के लिए एक शैक्षणिक अभ्यास पूरा करने का विकल्प भी दिया जाता है, ताकि उनके खाते पर स्ट्राइक न लगाई जाए। जनवरी 2025 से तीन महीनों की अवधि के दौरान, Facebook के 7.1 मिलियन से अधिक और Instagram के 7,30,000 से अधिक यूज़र ने “योग्य उल्लंघन नोटिस” को देखने का विकल्प चुना। इन यूज़र में से लगभग 3 मिलियन ने शैक्षणिक अभ्यास शुरू किया, और इनमें से अधिकांश ने (Facebook पर 80% से अधिक और Instagram पर 85% से अधिक) सभी चरण पूरे किए, जिससे वे अपने खाते पर स्ट्राइक और उससे जुड़े प्रतिबंधों से बच सके।

Meta को इसके बाद किए गए यूज़र फ़ीडबैक सर्वे में सकारात्मक प्रतिक्रिया मिली, जिससे यह संकेत मिला कि शैक्षणिक भाग को अच्छी तरह स्वीकार किया गया और यूज़र ने अपने खाते पर स्ट्राइक से बचने के लिए शैक्षणिक अवसरों को सराहा।

*यह सुविधा कम्युनिटी स्टैंडर्ड के सबसे गंभीर उल्लंघनों पर लागू नहीं होती, जैसे कि यौन शोषण, उच्च-जोख़िम वाली दवाएं, और Meta द्वारा नामित खतरनाक संगठनों का प्रतिनिधित्व करना, समर्थन करना या उनका महिमामंडन करना।

राजनीतिक बहस को प्रोत्साहित करने के लिए, खतरनाक लोगों और संगठनों संबंधी पॉलिसी में संशोधन

अंतरराष्ट्रीय मानवाधिकार कानून का पालन करने के लिए, अभिव्यक्ति की स्वतंत्रता को प्रतिबंधित करने वाले नियमों का स्पष्ट, सटीक और सार्वजनिक रूप से सुलभ होना आवश्यक है। Meta की पॉलिसी का मूल्यांकन करते समय, बोर्ड इन्हीं मानकों को लागू करता है। हमारे द्वारा जारी किए गए शुरुआती निर्णयों से ही, बोर्ड ने कहा है कि Meta की खतरनाक संगठनों और लोगों संबंधी पॉलिसी, इन आवश्यकताओं को पूरा नहीं करती है, जिसके परिणामस्वरूप यह ऑनलाइन राजनीतिक चर्चाओं को अत्यधिक रूप से प्रतिबंधित करती है (नाज़ी उद्धरण, ओकलान का एकांतवास, अल जज़ीरा की शेयर की गई पोस्ट, नामित किए गए खतरनाक व्यक्ति को "शहीद" के रूप में संदर्भित करना)। 2022 में, बोर्ड ने एक समाचार लेख से संबंधित पोस्ट को हटाने के Meta के निर्णय को बदल दिया। उस समाचार लेख में तालिबान के एक प्रवक्ता का यह बयान रिपोर्ट किया गया था कि महिलाओं और लड़कियों के लिए स्कूल फिर से खोले जाएंगे। यह पोस्ट इस आधार पर हटाई गई थी कि तालिबान को Meta (साथ ही कई सरकारों) द्वारा एक खतरनाक संगठन के रूप में नामित किया गया है और यह कि पोस्ट में उसके लिए “प्रशंसा” का एक रूप शामिल था। बोर्ड ने पाया कि संबंधित पोस्ट, तालिबान की गतिविधियों की रिपोर्टिंग कर रही थी, और इस प्रकार की सूचना का प्रसारण एक महत्वपूर्ण अधिकार है – सूचना शेयर करने वालों और साथ ही उसे प्राप्त करने वालों, दोनों का – विशेष रूप से संघर्ष और संकट के समय में।

हमारी 2024 की पॉलिसी से संबंधित सलाह में, हमने Meta के इस खुलासे का उल्लेख किया कि अरबी शब्द “शहीद” (जिसका मोटे तौर पर अर्थ “मार्टर” है) कम्युनिटी स्टैंडर्ड के तहत वैश्विक स्तर पर किसी भी अन्य एकल शब्द की तुलना में अधिक कंटेंट हटाए जाने का आधार बना। कंटेंट को इसलिए हटाया गया, क्योंकि कंपनी ने जिस व्यक्ति या संगठन को खतरनाक माना था, उसके नाम के साथ शहीद शब्द के उपयोग को निषिद्ध कर दिया था। इस निषेध में यह मान लिया गया था कि ऐसी सभी पोस्ट आतंकवादियों या अन्य खतरनाक पक्षों का महिमामंडन करती हैं, जबकि यह सही नहीं था। बोर्ड ने पाया कि शहीद शब्द का उपयोग कई अलग-अलग सांस्कृतिक संदर्भों में किया जाता है और यह हर स्थिति में प्रशंसा का शब्द नहीं होता। इसके अलावा, शहीद शब्द का किसी खतरनाक व्यक्ति या संगठन के नाम के निकट होना हमेशा यह नहीं दर्शाता कि पोस्ट हिंसा की प्रशंसा कर रही थी। इस समस्या के समाधान के लिए, हमने खतरनाक संगठनों और लोगों संबंधी पॉलिसी में संशोधन की मांग की, ताकि शहीद शब्द के साथ खतरनाक लोगों और संगठनों का संदर्भ होने मात्र से पोस्ट को अपने-आप न हटाया जाए। हमारे अधिकांश सुझावों के लागू होने के बाद, बोर्ड की डेटा टीम ने उन दैनिक पोस्टों में 50,000 व्यू के साथ 19.5% की वृद्धि की पहचान की, जिनमें शहीद शब्द था।

2025 के एक निर्णय (खतरनाक संगठनों द्वारा अपनाए गए प्रतीक) में, हमने एक बार फिर यह पता लगाया कि खतरनाक संगठनों और लोगों संबंधी पॉलिसी कहां कमज़ोर पड़ती है, इस बार पर ध्यान देते हुए कि Meta द्वारा नफ़रत फैलाने वाले समूहों द्वारा अक्सर उपयोग किए जाने वाले प्रतीकों की पहचान के लिए अपनाए गए आंतरिक मानदंड, कंपनी के सार्वजनिक स्पष्टीकरण की तुलना में कहीं अधिक व्यापक हैं। यह महत्वपूर्ण है कि पूरी परिभाषा सार्वजनिक की जाए, ताकि यूज़र यह समझ सकें कि वे क्या पोस्ट नहीं कर सकते। कंपनी ने सार्वजनिक अपडेट के प्रति प्रतिबद्धता जताई है।

यूज़र को सशक्त बनाने और जवाबदेही बढ़ाने के लिए पारदर्शिता

बोर्ड ने Meta पर यह दबाव डाला है कि वह इस बारे में अधिक पारदर्शी हो कि सरकारें, कंटेंट से जुड़े फ़ैसलों या प्लेटफ़ॉर्म की पॉलिसी को कब और कैसे प्रभावित करती हैं। हमने यूज़र को यह जानकारी और डेटा उपलब्ध कराने का प्रयास किया है कि एन्फ़ोर्समेंट एल्गोरिदम कैसे काम करते हैं और उनके कंटेंट पर कम्युनिटी स्टैंडर्ड को कैसे लागू किया जाता है। हमारे सुझावों की प्रतिक्रिया में, Meta ने पारदर्शिता में सुधार किया है, जिसमें एन्फ़ोर्समेंट एरर को सार्वजनिक रूप से बताना और यह सुनिश्चित करना शामिल है कि स्वतंत्र शोधकर्ताओं को डेटा का ऐक्सेस हो।

कंटेंट को रिव्यू करने या हटाने के सरकारी अनुरोधों को प्रकट करना

कंटेंट से जुड़े फ़ैसलों पर सरकारी प्रभाव, सेंसरशिप और स्वतंत्र अभिव्यक्ति पर नकारात्मक प्रभाव पैदा कर सकता है। जब राज्य द्वारा कंटेंट हटाने के अनुरोध पिछले दरवाज़ों से किए जाते हैं, तो यूज़र को यह पता नहीं चल पाता कि उनके कंटेंट से जुड़े प्लेटफ़ॉर्म के फ़ैसले राजनीतिक रूप से प्रेरित हैं या नहीं। पारदर्शिता, ऑनलाइन प्लेटफ़ॉर्म में यूज़र और नागरिक समाज के लिए विश्वास के आधारों में से एक है। यह इस बात पर खुली चर्चा को सशक्त बनाती है कि क्या सरकारी कार्रवाई वैध विनियमन है या सेंसरशिप, और यूज़र को सरकारों और शक्तिशाली ऑनलाइन कंपनियों के बीच की गतिशीलता की स्पष्ट जानकारी मिलने के परिणामस्वरूप सरकारों व प्लेटफ़ॉर्म, दोनों को जवाबदेह ठहराए जाने की संभावना बढ़ जाती है।

एक से अधिक केस में, हमने इस बात को सामने रखा है कि सरकारों द्वारा Meta को कंटेंट हटाने के अनुरोध अव्यवस्थित और अपारदर्शी तरीकों से भेजे गए (अल जज़ीरा की शेयर की गई पोस्ट, ओकलान का एकांतवास, यूके ड्रिल म्यूज़िक)। इन अनुरोधों के संदर्भ में पारदर्शिता अत्यंत आवश्यक है, ताकि यूज़र को यह जानकारी मिल सके कि क्या सरकारों ने उनके कंटेंट को रिव्यू करने के लिए उसे सीधे Meta को फ़्लैग किया है। यूके ड्रिल म्यूज़िक केस में एन्फ़ोर्समेंट की उन गलतियों का खुलासा हुआ, जो लंदन की महानगरीय पुलिस सेवा द्वारा किए गए कंटेंट हटाने के अनुरोधों से उत्पन्न हुई थीं और जिनके कारण हाशिए पर पड़े समूहों के लोगों की कलात्मक अभिव्यक्ति पर अनुचित प्रतिबंध लगाए गए। ओकलान के एकांतवास केस में, यूज़र को कुर्दिस्तान वर्कर्स पार्टी के एक कैदी को एकांत कारावास में रखे जाने से संबंधित मानवाधिकार चिंताओं को व्यक्त करने से रोका जा रहा था। इस केस में हमारे सुझावों की प्रतिक्रिया में, Meta अब उन सभी यूज़र को सूचित करता है, जिनका कंटेंट किसी सरकारी अनुरोध के कारण हटाया गया था कि कंटेंट को हटाया गया था, और यदि कानून द्वारा ऐसा करना प्रतिबंधित न हो, तो यह भी बताता है कि किस सरकारी इकाई ने वह अनुरोध किया था।

हमने यह भी रेखांकित किया है कि प्लेटफ़ॉर्म के लिए ऐसे सरकारी अनुरोधों को सार्वजनिक रूप से बताना कितना महत्वपूर्ण है, यह सुझाव देते हुए कि Meta एक मानकीकृत प्रणाली बनाए और इन केस में कंटेंट हटाने के कारणों से जुड़ा डेटा उपलब्ध कराए। कंपनी ने सार्वजनिक रूप से पुष्टि की है कि उसने एक नया कंटेंट रिपोर्टिंग सिस्टम लागू किया है, जिसमें ऐसे अनुरोध करते समय राज्य पक्षों द्वारा उत्तर दिए जाने के लिए मानक प्रश्न शामिल हैं, और इसमें 97% योग्य नियामकों को शामिल किया गया है। Meta द्वारा, अनुरोध के समय प्रश्नों का एकरूप सेट पूछना यह सुनिश्चित करने में मदद करता है कि सरकारें एकरूप नियमों के प्रति जवाबदेह रहें और मनमाने राजनीतिक फ़ैसलों की संभावना कम हो।

यूज़र को यह बताना कि उनके कंटेंट ने किन नियमों का उल्लंघन किया है

अंतरराष्ट्रीय मानवाधिकार कानून के तहत, व्यक्तियों को यह जानकारी दी जानी चाहिए कि नियम क्या हैं और वे अपने अधिकारों का दावा कैसे कर सकते हैं। Meta के प्लेटफ़ॉर्म पर, यूज़र को यह समझने में सक्षम होना चाहिए कि उनके कंटेंट ने कम्युनिटी स्टैंडर्ड के किस भाग का कथित रूप से उल्लंघन किया है और उसके खिलाफ़ एन्फ़ोर्समेंट एक्शन क्यों की गई है (अज़रबैजान में आर्मीनियाई, स्तन कैंसर के लक्षण और नग्नता, नाज़ी उद्धरण, ज़्वर्टे पीट का चित्रण, दक्षिण अफ़्रीकी अपशब्द, अयाहुआस्का पेय, निजी आवासीय जानकारी शेयर करना)। इससे लोगों को अगली बार पोस्ट करते समय अपने व्यवहार में सुधार करने का अवसर मिलता है या वे एक प्रभावी अपील सबमिट करने में सक्षम होते हैं। इन प्रकार की सूचनाएं उपलब्ध कराने के लिए Meta को दिए गए सुझावों की प्रतिक्रिया में, कंपनी ने 2024 से यह प्रथा शुरू की है कि जब वह एन्फ़ोर्समेंट एक्शन लेती है, तो यूज़र को यह सूचित किया जाता है कि उनके कंटेंट ने किस विशिष्ट पॉलिसी का कथित रूप से उल्लंघन किया है।

पॉलिसी उल्लंघनों का अनुमान लगाने वाले एल्गोरिदम कैसे काम करते हैं, इसका सार्वजनिक स्पष्टीकरण

यह स्पष्ट करने के लिए कि Meta के क्लासिफ़ायर (एल्गोरिदम का एक प्रकार) यह अनुमान कैसे लगाते हैं कि कोई विशेष कंटेंट, नियमों का उल्लंघन कर सकता है, हमने कंपनी से आग्रह किया है कि वह अपने पारदर्शिता केंद्र में इसका एक सार्वजनिक स्पष्टीकरण प्रदान करे। हमने Meta से यह स्पष्ट करने को कहा कि कंटेंट के संबंध में क्लासिफ़ायर की अनुमान-सटीकता की सीमाएं क्या हैं, कब कोई कार्रवाई नहीं की जाती, कब मानवीय रिव्यू के लिए भेजा जाता है या मानवीय रिव्यू के बिना हटा दिया जाता है (नामित खतरनाक लोगों को “शहीद” के रूप में संदर्भित करना)। दूसरे शब्दों में, हमने Meta पर यह दबाव डाला कि वह यह स्पष्ट करे कि कथित उल्लंघन के बारे में किसी एल्गोरिदम को कितनी निश्चितता होनी चाहिए, ताकि उस ऑटोमेटेड सिस्टम को कंटेंट हटाने की शक्ति दी जा सके। कंपनी ने इस क्षेत्र में हमारे सभी सुझावों को पूरी तरह से पूरा नहीं किया है,

हालांकि Meta ने प्रतिक्रिया के रूप में यह स्पष्ट करने वाली जानकारी अपने पारदर्शिता केंद्र के संबंधित पेजों में जोड़ी है कि उसकी एन्फ़ोर्समेंट प्रौद्योगिकी कैसे काम करती है। इस बारे में और भी अधिक पारदर्शिता की स्पष्ट आवश्यकता है कि ऑटोमेटेड सिस्टम कैसे काम करते हैं, उनका ऑडिट कैसे किया जाता है और उनकी सफलता को कैसे मापा जाता है।

कम्युनिटी स्टैंडर्ड में पॉलिसी अपवादों को अधिक स्पष्ट रूप से प्रस्तुत करना

Meta के कुछ कम्युनिटी स्टैंडर्ड को ऐसे अपवादों और छूटों के साथ लागू किया जाता है, जो यूज़र को कुछ विशिष्ट संदर्भों में अभिव्यक्ति शेयर करने की अनुमति देते हैं, भले ही वह कंटेंट लिखित पॉलिसी के अनुसार उल्लंघन करने जैसा प्रतीत होता हो। उदाहरण के लिए, समाचार रिपोर्टिंग या जागरूकता बढ़ाने के उद्देश्य से शेयर किए गए कुछ कंटेंट को इन अपवादों के तहत अनुमति दी जा सकती है। हालांकि, यदि यूज़र को यह समझ न हो कि कौन से अपवाद किस विशेष कम्युनिटी स्टैंडर्ड पर लागू होते हैं, तो वे स्पष्ट रूप से नुकसान की स्थिति में होते हैं। अंतरराष्ट्रीय मानवाधिकार कानून के तहत, अभिव्यक्ति की स्वतंत्रता पर लगाए गए प्रतिबंधों का स्पष्ट रूप से वर्णन होना चाहिए, ताकि वक्ताओं को यह जानकारी हो कि नियम क्या हैं। यह आवश्यकता तक पूरी नहीं होती, जब अपवादों को यूज़र से छिपा लिया जाता है। हमने Meta से कहा कि वह इस कमी को दूर करने के लिए कम्युनिटी स्टैंडर्ड के भीतर एक नया सेक्शन बनाए, जिसमें संबंधित अपवादों को निर्धारित किया जाए (पाकिस्तान में बाल-शोषण पर समाचार वृत्तचित्र)। 2025 की पहली छमाही में, Meta ने बताया कि वह अब भी इस सुझाव का व्यवहार्यता मूल्यांकन कर रहा है और अपने पारदर्शिता केंद्र में छूटों को और अधिक स्पष्ट बनाने के तरीकों का पता लगा रहा है।

उच्च-जोख़िम वाले मुद्दों से बेहतर तरीके से निपटना और असुरक्षित समुदायों की सुरक्षा करना

संकट के समय अक्सर यह पता चलता है कि सामान्य मॉडरेशन प्रक्रियाएं अपर्याप्त हैं। हमारे सुझावों ने Meta को चुनावों और संघर्ष जैसे उच्च-जोख़िम वाले परिदृश्यों के प्रति अधिक उत्तरदायी बनने के लिए प्रेरित किया है। यह स्वीकार करते हुए कि दुनिया भर में ऐसे कई यूज़र हैं, जिनके लिए Meta के प्लेटफ़ॉर्म जानकारी प्राप्त करने और शेयर करने का एक प्रमुख माध्यम हैं, यूज़र के स्वतंत्र अभिव्यक्ति के अधिकार – जिसमें सूचना देने और प्राप्त करने, दोनों अधिकार शामिल हैं – को कायम रखना, संकट की स्थितियों में विशेष रूप से महत्वपूर्ण हो जाता है, क्योंकि ऐसी जानकारी जीवन और मृत्यु का विषय बन सकती है।

उदाहरण के लिए, गाज़ा में युद्ध से संबंधित कई केस पर विचार करते हुए, बोर्ड ने संघर्ष के सभी पक्षों की स्वतंत्र अभिव्यक्ति को कायम रखा है। 2023 में, तेजी से फ़ैसला लिए जाने वाले एक केस में – जिसमें केस स्वीकार किए जाने के 30 दिनों के भीतर फ़ैसले जारी किए जाते हैं – बोर्ड ने Meta के उस फ़ैसले को बदल दिया, जिसमें 7 अक्टूबर को हमास के नेतृत्व में इज़राइल पर किए गए आतंकवादी हमले के दौरान हुए एक अपहरण को दर्शाने वाले Facebook वीडियो को हटाया गया था, और चेतावनी स्क्रीन के साथ उसे बहाल करने का समर्थन किया (इज़राइल से अगवा किए गए बंधक)। 2024 के एक अन्य केस में, बोर्ड ने फ़िलिस्तीनी बच्चे की हत्या के संबंध में चैनल 4 न्यूज़ (यूके) की रिपोर्ट को हटाने के Meta के निर्णय को भी बदल दिया (गाज़ा में युद्ध पर रिपोर्ट)।

बोर्ड के एक सुझाव से प्रेरित होकर, Meta ने एक क्राइसिस प्रोटोकॉल शुरू किया है, ताकि उच्च-दबाव वाली परिस्थितियों में भी यूज़र के अधिकारों का सम्मान सुनिश्चित किया जा सके। यूज़र को तब लाभ मिलता है, जब संकट की स्थितियों में अधिक संसाधन और ध्यान केंद्रित किया जाता है, ताकि ऐसे कंटेंट पर अधिक तेज़ी से कार्रवाई की जा सके, जो तात्कालिक नुकसान पहुंचा सकता है, और साथ ही ऐसी जानकारी को गलती से न हटा दिया जाए, जो कि जनहित में है।

कंपनी ने चुनावों के दौरान कंटेंट के प्रबंधन के तरीकों का मूल्यांकन करने के लिए एक फ़्रेमवर्क भी शुरू किया है, और क्रॉस-चेक सिस्टम के संबंध में अधिक प्रभावी सुरक्षा उपाय लागू किए हैं, एक ऐसा प्रोग्राम, जो Meta ने उन यूज़र के लिए अति-एन्फ़ोर्समेंट को रोकने के उद्देश्य से बनाया गया था, जो उच्च-प्रोफ़ाइल वाले हैं, या जिनके केस में कंटेंट हटाने की त्रुटियां, मीडिया में या सीधे कंपनी के वरिष्ठ अधिकारियों तक पहुंच सकती हैं।

संकट प्रतिक्रिया के लिए पॉलिसी बनाना और उसे प्रकाशित करना

सोशल मीडिया प्लेटफ़ॉर्म को संकटों, चाहे वे संघर्ष, सामाजिक अशांति, विवादित चुनाव या प्राकृतिक आपदाएं हों, के प्रति प्रतिक्रिया देने के लिए तैयार रहना चाहिए, ताकि यूज़र की स्वतंत्र अभिव्यक्ति के अधिकारों की रक्षा हो सके, भले ही परिस्थितियां तेज़ी से बदलने वाली और उच्च-दबाव वाली हों। इन महत्वपूर्ण स्थितियों में, कंटेंट से जुड़े फ़ैसलों को तेज़, न्यायसंगत और एकरूप बनाने के लिए अतिरिक्त प्रक्रियाओं की आवश्यकता होती है।

इसी कारण, अपने संचालन के पहले वर्ष में ही, हमने Meta से एक क्राइसिस पॉलिसी प्रोटोकॉल (CPP) विकसित करने का अनुरोध किया, ताकि आवश्यकता पड़ने पर कंपनी शीघ्रता से कार्रवाई करने के लिए तैयार रहे (पूर्व राष्ट्रपति ट्रंप का निलंबन)। व्यापक हितधारक पॉलिसी फ़ोरम के बाद, Meta ने अगस्त 2022 में CPP की स्थापना की और बाद में अपने पारदर्शिता केंद्र में इस तंत्र के बारे में एक पेज भी जोड़ा। CPP एक ऐसा फ़्रेमवर्क है, जो संकट की स्थिति में मॉडरेशन को तीव्र करता है और पॉलिसी को वैश्विक स्तर पर एक जैसे तरीके से लागू करना संभव बनाता है। यह प्रोटोकॉल तब सक्रिय होता है, जब पूर्व-निर्धारित मानदंड, उच्च-जोख़िम वाली स्थितियों की पहचान करते हैं, और यह तेज़ी से फ़ैसले लेने के लिए अधिक टूल उपलब्ध कराता है। इस क्षेत्र पर बोर्ड निरंतर ध्यान दे रहा है, क्योंकि हाल ही में हमने CPP को और अधिक तत्परता से सक्रिय करने के लिए समायोजन का सुझाव दिया है और उच्च-जोख़िम वाली स्थितियों में संदर्भ के आधार पर फ़ैसला लेने के लिए कंटेंट रिव्यूअर को अधिक विवेकाधिकार देने का आह्वान किया है (यूके के दंगों का समर्थन करने वाली पोस्ट, सीरियाई संघर्ष में भाषणों को शेयर करने वाली पोस्ट)।

चुनावों की निष्पक्षता के प्रयासों को मापने के लिए फ़्रेमवर्क तैयार करना

चुनावों के दौरान, प्लेटफ़ॉर्म को राजनीतिक अभिव्यक्ति की अनुमति देने और मतदान के अधिकार सहित मानवाधिकारों को गंभीर जोख़िमों से बचाने, दोनों जिम्मेदारियों को पूरा करने के लिए तैयार रहना चाहिए। हालांकि, कंपनी के उपाय इन अवसरों के लिए पर्याप्त हैं या नहीं, यह समझना कठिन होता है, यदि ऐसा कोई एकरूप फ़्रेमवर्क उपलब्ध न हो, जिसके ज़रिए कंपनी चुनावों के लिए तैयारी करती है। 2023 में, हमने यह उल्लेख किया था कि Meta को चुनावी निष्पक्षता सुनिश्चित करने के लिए एक फ़्रेमवर्क विकसित करना चाहिए और उन प्रयासों को सार्वजनिक रूप से बताना चाहिए (ब्राज़ीलियाई जनरल का भाषण)। हमने Meta से आग्रह किया कि वह लोकतांत्रिक प्रक्रियाओं को बाधित करने के उद्देश्य से चलाए जा रहे समन्वित ऑनलाइन और ऑफ़लाइन अभियानों की पहचान के लिए स्थानीय ज्ञान का उपयोग करे, और जहां राजनीतिक हिंसा बनी रहती है, वहां चुनावों से जुड़ी प्रतिक्रिया को लगातार बेहतर बनाने के लिए स्थायी फ़ीडबैक चैनल स्थापित करे।

जून 2025 में, Meta ने पुष्टि की कि उसने बोर्ड के सुझाव को लागू करते हुए आठ प्रमुख चुनावी निष्पक्षता स्तंभों वाला एक फ़्रेमवर्क विकसित किया है। इन्हें उसकी चुनाव की सभी निगरानियों में लागू किया जाएगा, जिनमें जोख़िम प्रबंधन, बाहरी हितधारकों के साथ सहयोग, गलत जानकारी के प्रसार को कम करना, और जनरेटिव AI के प्रति एक जिम्मेदार दृष्टिकोण जैसे फ़ैक्टर शामिल होंगे। हालांकि हमने अभी तक यह नहीं देखा है कि इस फ़्रेमवर्क को लागू किया गया है और न ही इसकी प्रभावशीलता का आकलन कर पाए हैं, फिर भी इसके गठन की घोषणा अपने आप में एक सकारात्मक कदम है।

क्रॉस-चेक सिस्टम के संबंध में अधिक प्रभावी सुरक्षा उपाय लागू करना

Meta का क्रॉस-चेक सिस्टम एक ऐसा प्रोग्राम है, जिसे उच्च-प्रभाव वाले कंटेंट – यानी ऐसा कंटेंट, जो प्रभावशाली खातों से आता है या जो वायरल हो चुका होता है – को हटाने से पहले अतिरिक्त जांच लागू करने के लिए बनाया गया है। हालांकि, इस क्रॉस-चेक सिस्टम ने बोर्ड के लिए इस बारे में गंभीर चिंताएं पैदा की कि कंपनी किस तरह से अपने सबसे शक्तिशाली यूज़र के साथ गैर-पारदर्शी तरीकों से अलग व्यवहार कर रही थी और इससे सामान्य यूज़र को नुकसान हो रहा था। क्रॉस-चेक के अस्तित्व का खुलासा एक Facebook व्हिसलब्लोअर ने किया था। इन खुलासों की प्रतिक्रिया में, बोर्ड ने इस प्रोग्राम का गहन परीक्षण किया और कंपनी से जानकारी प्राप्त करने व उसका विश्लेषण करने के अवसर का उपयोग लिया, जिसने इस प्रोग्राम की सीमाओं और प्रभावों को पहली बार जनता के लिए पारदर्शी बनाया। इस प्रोग्राम पर हमारी पॉलिसी से संबंधित सलाह पर प्रतिक्रिया में, Meta ने बोर्ड के समक्ष स्वीकार किया कि इन प्रथाओं के संबंध में “संचालन का अभाव” होने के कारण कुछ यूज़र, एन्फ़ोर्समेंट एक्शन से बच निकलने में सफल रहे।

हमने क्रॉस-चेक सिस्टम के संबंध में अधिक प्रभावी सुरक्षा उपाय लागू करने और यूज़र के लिए अधिक निष्पक्षता सुनिश्चित करने के लिए 32 सुझाव दिए, जिनमें इनका समाधान किया गया: एन्फ़ोर्समेंट की गति और रिव्यू की गुणवत्ता; क्रॉस-चेक के लिए पात्रता कैसे निर्धारित की जाती है; यह प्रोग्राम कैसे काम करता है, इस पर पारदर्शिता; प्रोग्राम में मानवाधिकारों को शामिल करना, जिनमें अपील का अधिकार भी शामिल है।

उदाहरण के लिए, जब क्रॉस-चेक सूची में शामिल किसी यूज़र की पोस्ट को Meta की पॉलिसी का उल्लंघन करते हुए पहचाना गया, तो क्रॉस-चेक सिस्टम के कारण वह कंटेंट कई दिनों तक प्लेटफ़ॉर्म पर बना रहा, जबकि अतिरिक्त रिव्यू किए जा रहे थे। इसी अवधि में उल्लंघनकारी कंटेंट सबसे अधिक वायरल होता है और, यदि वह बदला लेने वाली अश्लीलता या कोई विश्वसनीय धमकी जैसा हो, तो सबसे अधिक नुकसानदायक भी होता है। हमने पात्रता के लिए अधिक स्पष्ट मानदंड तय करने तथा यह नियंत्रित करने वाली पारदर्शिता का सुझाव दिया कि किन यूज़र को अतिरिक्त रिव्यू का अधिकार है और किन परिस्थितियों में। इसकी प्रतिक्रिया में, Meta ने पात्रता सूची के निर्माण, ऑडिट और निगरानी के तरीके में बदलाव किए। Meta ने रिव्यू प्रक्रिया में होने वाली देरी को समाप्त करने के लिए भी कदम उठाए, जिसके परिणामस्वरूप संभावित रूप से उल्लंघनकारी कंटेंट को मिलने वाले व्यू में उल्लेखनीय कमी आई।

हमारे एक प्रमुख सुझाव में इस बात पर ज़ोर दिया गया था कि Meta, रिव्यू कतार में उन रुकावटों को दूर करे, जिनके कारण हाई-प्रोफ़ाइल यूज़र की पोस्ट सप्ताहों या यहां तक कि महीनों तक प्लेटफ़ॉर्म पर बनी रहती थीं, इससे पहले कि उन्हें उल्लंघनकारी घोषित करके हटाया जाए। कंपनी ने इस समस्या पर कार्य किया और बोर्ड को निम्नलिखित डेटा प्रस्तुत किया: 2023 की पहली छमाही में कंपनी की क्रॉस-चेक रिव्यू कतारों में बनाए गए टास्क में से 90% के लिए, समाधान समय (यानी रिव्यू और उसके बाद के किसी भी एन्फ़ोर्समेंट में लगा समय) में 2022 की दूसरी छमाही की तुलना में 96% की कमी आई।

कंटेंट मॉडरेशन में पक्षपात की जांच

राजनीतिक विचारों के मॉडरेशन में अनुचितता और पक्षपात की धारणाएं, प्लेटफ़ॉर्म संचालन की वैधता को खतरे में डाल सकती हैं। इस तरह का पक्षपात कई कारणों से उत्पन्न हो सकता है, जिनमें पुरानी या कठोर पॉलिसी, भाषा क्षमताओं और सांस्कृतिक दक्षता में अपर्याप्त निवेश, तथा एन्फ़ोर्समेंट की बार-बार होने वाली गलतियां शामिल हैं, जो कि सेंसरशिप के चक्रीय पैटर्न बनाती हैं, जिनके परिणामस्वरूप सिस्टम, समय के साथ गलत सबक सीखते और लागू करते हैं। एक केस में, हमने यह उल्लेख किया कि गर्भपात के मुद्दे पर परस्पर विरोधी दृष्टिकोण रखने वाले कंटेंट को गलती से हटाए जाने से राजनीतिक बहस किस तरह बाधित हो रही थी (गर्भपात पर चर्चा वाली अमेरिकी पोस्ट)। बोर्ड ने सुझाव दिया कि Meta को नियमित रूप से उस डेटा को सार्वजनिक रूप से उपलब्ध कराना चाहिए, जिसका उपयोग कंपनी अपनी हिंसा और उकसाने संबंधी पॉलिसी के एन्फ़ोर्समेंट की सटीकता का मूल्यांकन करने के लिए करती है। Meta ने यह डेटा उपलब्ध नहीं कराया है, जबकि ऐसा खुलासा इस बात का विश्लेषण करने की अनुमति देता कि इस केस में एन्फ़ोर्समेंट एरर – ऐसे कंटेंट को हटाना, जिसने वास्तव में पॉलिसी का उल्लंघन नहीं किया – अलग-थलग घटनाएं थीं या प्रणालीगत।

एक अन्य केस में, जो फ़िलिस्तीनी और इज़राइली कंटेंट से संबंधित Facebook की कंटेंट मॉडरेशन प्रक्रिया में पक्षपात को लेकर सार्वजनिक चिंताओं के संदर्भ में सामने आया, बोर्ड ने सुझाव दिया कि प्लेटफ़ॉर्म पर इस संघर्ष से संबंधित कंटेंट मॉडरेशन में प्रणालीगत पक्षपात के मुद्दे की जांच किसी तीसरे पक्ष से कराई जाए (अल जज़ीरा की शेयर की गई पोस्ट)। इसके बाद, Meta ने सलाहकारी निकाय 'बिज़नेस फ़ॉर सोशल रिस्पॉन्सिबिलिटी' से एक रिपोर्ट तैयार करवाई, जिसमें यह संकेत दिया गया कि मई 2021 के इज़राइल और फ़िलिस्तीन संघर्ष के दौरान Facebook के कंटेंट मॉडरेशन ने फ़िलिस्तीनी यूज़र की अभिव्यक्ति की स्वतंत्रता प्रतिकूल मानवाधिकार प्रभाव डाला था, ऐसा प्रतीत होता है। इस पक्षपात का अधिकांश भाग, कंपनी के भीतर भाषा संबंधी संसाधनों की कमी और कंटेंट रिव्यूअर को दिए गए अपर्याप्त मार्गदर्शन से जुड़ा हुआ है। सीमित भाषा क्षमताओं के कारण यहूदी-विरोधी कंटेंट के खिलाफ़ पर्याप्त एन्फ़ोर्समेंट न हो पाने की समस्या भी सामने आई। 2022 में, Meta ने एक प्रतिक्रिया जारी की, जिसमें कहा गया कि वह अधिक कंटेंट मॉडरेटर को नियुक्त करेगा, जो संबंधित बोलियों में रिव्यू कर सकें, और यह कि उसने हिब्रू भाषा में एक मशीन-लर्निंग क्लासिफ़ायर भी तैनात किया है।

असुरक्षित समुदायों की सुरक्षा

बोर्ड ने असुरक्षित समुदायों, जैसे कि दमनकारी शासन व्यवस्थाओं में मानवाधिकार रक्षक और विपक्षी नेता, का ऑनलाइन नुकसान से लगातार बचाव किया है। बोर्ड के फ़ैसलों के परिणामस्वरूप, ट्रांसजेंडर लोगों को नुकसान पहुंचाने वाली और समलैंगिक-विरोधी हिंसा को बढ़ावा देने वाली पोस्ट को हटाया गया है।

Meta के उस फ़ैसले को बदलते हुए, जिसमें Facebook के एक वीडियो को बनाए रखा गया था, जिसमें कंबोडिया के तत्कालीन प्रधानमंत्री हुन सेन अपने राजनीतिक प्रतिद्वंद्वियों को हिंसा की धमकी दे रहे थे, बोर्ड ने जून 2023 में निष्कर्ष निकाला कि ऐसे कंटेंट को बनाए रखना कंपनी की मानवाधिकार ज़िम्मेदारियों के अनुरूप नहीं है (कंबोडियाई प्रधानमंत्री)।

2024 में, जब ट्रांसजेंडर लोगों को आत्महत्या के लिए हिंसक रूप से उकसाने वाली एक पोस्ट को बनाए रखने के Meta के फ़ैसले को बदला गया, तो बोर्ड ने कंपनी से अनुरोध किया कि वह ऐसी गैर-टेक्स्ट रूप में की गई अभिव्यक्ति के विरुद्ध अपने एन्फ़ोर्समेंट को बेहतर बनाए। इस केस में, बोर्ड ने पाया कि कंटेंट में आत्महत्या के आंशिक रूप से कोडित संदर्भों को एक संरक्षित विशेषता समूह (ट्रांसजेंडर ध्वज) के दृश्यात्मक चित्रण के साथ जोड़ा गया था, जो “दुर्भावनापूर्ण रचनात्मकता” का रूप लेता था। यह कोडित भाषा या दृश्य/टेक्स्ट मीम के जान-बूझकर उपयोग को संदर्भित करता है, जिन्हें समझने के लिए संदर्भ की आवश्यकता होती है, और जिन्हें अक्सर वे लोग अपनाते हैं, जो सोशल मीडिया पर पहचान से बचना चाहते हैं (ट्रांस लोगों को निशाना बनाती पोलिश भाषा में पोस्ट)।

Meta के एन्फ़ोर्समेंट के संबंध में प्रणालीगत कमियों की पहचान एक ऐसे वीडियो के केस में की गई, जिसने चार अलग-अलग कम्युनिटी स्टैंडर्ड का उल्लंघन किया था। नाइजीरिया में, जहां समलैंगिक संबंधों को अपराध माना जाता है, कथित तौर पर समलैंगिक होने के कारण पीटे गए पुरुषों को दिखाने वाले इस वीडियो को तीन मॉडरेटर ने रिव्यू किए था, इसके बाद भी यह Meta के प्लेटफ़ॉर्म पर बना रहा, जिससे उनकी पहचान उजागर होने से तात्कालिक नुकसान का जोख़िम उत्पन्न हुआ। बोर्ड ने इस वीडियो को बनाए रखने के Meta के मूल फ़ैसले को बदल दिया (पश्चिमी अफ़्रीका में समलैंगिक-विरोधी हिंसा)।

कई केस में, जिनमें 2023 का एक फ़ैसला भी शामिल है, जो Facebook पर युद्धबंदियों की पहचान योग्य तस्वीरें दिखाने वाले एक वीडियो से संबंधित था, बोर्ड ने सुझाव दिया कि Meta अंतरराष्ट्रीय कानून के तहत परिभाषित गंभीर मानवाधिकार उल्लंघनों या अत्याचार अपराधों को दर्शाने वाले कंटेंट को संरक्षित करे और जहां उपयुक्त हो, उसे अंतरराष्ट्रीय न्यायालयों जैसे प्राधिकारियों के साथ शेयर करे (आर्मीनियाई युद्धबंदियों का वीडियो)। बोर्ड को दी गई अपनी प्रतिक्रिया में, Meta ने बताया कि उसने इस सुझाव को लागू कर दिया है।

AI और ऑटोमेशन में मानवाधिकार सिद्धांतों को शामिल करना

बोर्ड को Meta के कुछ ऑटोमेटेड और AI सिस्टम पर दृश्यता प्राप्त होनी शुरू हुई है। इस दौरान हमने जहां-जहां प्रणालीगत कमियां पाई हैं, उन्हें रेखांकित किया है और उन क्षेत्रों की ओर ध्यान आकर्षित किया है, जहां एन्फ़ोर्समेंट प्रौद्योगिकी पर्याप्त रूप से कार्य नहीं कर रही है।

पॉलिसी के एन्फ़ोर्समेंट, और कंटेंट के क्यूरेशन और निर्माण में AI टूल और ऑटोमेशन के निष्पक्ष व प्रभावी उपयोग को सुनिश्चित करने के लिए, हमारा मानना है कि उनके डिज़ाइन और तैनाती में मानवाधिकार सिद्धांतों को शामिल करना अनिवार्य है।

AI लेबल यूज़र को सशक्त बनाते हैं

कई केस में, बोर्ड ने, AI की मदद से बनाए गए कंटेंट पर लेबल लगाने का सुझाव दिया है। इसका उद्देश्य यूज़र की अभिव्यक्ति की स्वतंत्रता की रक्षा करना है, साथ ही उन्हें कंटेंट के किसी पीस की प्रामाणिकता और उसके अंतर्निहित संदेश का बेहतर मूल्यांकन करने में सक्षम बनाना है (बाइडेन का हेरफेर किया गया वीडियो)।

बोर्ड के सुझावों पर प्रतिक्रिया में, Meta ने बताया कि उसने Facebook, Instagram और Threads पर, AI की मदद ये बनाई गई या हेरफेर की गई विभिन्न प्रकार के वीडियो, ऑडियो और तस्वीरों पर “AI info” लेबल लगाना शुरू कर दिया है। उदाहरण के लिए, अक्टूबर 2024 में 29 दिनों में, यूज़र ने Facebook पर 360 मिलियन से अधिक और Instagram पर 330 मिलियन से अधिक, AI लेबल वाले कंटेंट पीस देखे। इनमें से, यूज़र ने Facebook पर 6 मिलियन पोस्ट पर और Instagram पर कंटेंट के 13 मिलियन पीस पर लेबल को क्लिक किया, ताकि यह पता चल सके कि कंटेंट कैसे बनाया गया था।

तस्वीरों के ऑटोमेटेड एन्फ़ोर्समेंट में टेक्स्ट संकेतों पर बेहतर ढंग से ध्यान देने वाला नया क्लासिफ़ायर

सोशल मीडिया के विस्तार को देखते हुए, मानकों के एन्फ़ोर्समेंट और यूज़र को नुकसान से बचाने के लिए ऑटोमेटेड कंटेंट मॉडरेशन आवश्यक है। हालांकि, ऑटोमेशन पर अत्यधिक निर्भरता कभी-कभी ऐसी स्थितियां पैदा कर सकती है, जहां वैध और नियमों का उल्लंघन न करने वाले कंटेंट को हटा दिया जाता है, क्योंकि ऑटोमेटेड सिस्टम, संदर्भ – उदाहरण के लिए, जागरूकता बढ़ाना या व्यंग्य – को समझने में कठिनाई महसूस करते हैं, जिसे एक सक्षम मानव मॉडरेटर पहचान सकता है। बोर्ड ने इस समस्या पर अपने शुरुआती केस से ही ध्यान दिया है।

2021 में, हमने यह नोट किया कि Meta के ऑटोमेटेड सिस्टम, स्तन कैंसर के प्रति जागरूकता बढ़ाने वाली पोस्ट को पहचानने में विफल हो रहे थे, जब उनमें ऐसी तस्वीरें थी, जिन पर टेक्स्ट लिखा हुआ था (स्तन कैंसर के लक्षण और नग्नता)। हमने इस प्रकार के कंटेंट को गलती से हटाए जाने को लेकर चिंता जताई, जिसकी प्रतिक्रिया में Meta ने Instagram पर स्तन कैंसर से संबंधित पोस्ट की पहचान की तकनीक को बेहतर बनाने के लिए एक नया हेल्थ कंटेंट क्लासिफ़ायर तैनात किया। 2023 में 28 दिनों की अवधि के दौरान, स्तन कैंसर से संबंधित कंटेंट के 1,000 अतिरिक्त पीस को सीधे हटाए जाने के बजाय मानवीय रिव्यू के लिए भेजा गया। इसके बाद, Meta ने बताया कि इस क्लासिफ़ायर ने न केवल इस प्रकार के कंटेंट के मॉडरेशन में सुधार किया है, बल्कि टेक्स्ट लिखी हुई तस्वीरों के एन्फ़ोर्समेंट को भी व्यापक रूप से बेहतर बनाया है। बोर्ड इस क्षेत्र में सुधार के लिए Meta को लगातार प्रोत्साहित करता रहा है और यह सुनिश्चित करने पर ज़ोर देता रहा है कि उसकी पॉलिसी का बड़े पैमाने पर सटीक एन्फ़ोर्समेंट हो सके (स्तन कैंसर जागरूकता कंटेंट)।

Meta को दिए जाने वाले हमारे सुझाव, AI की मदद से बनाए गए कंटेंट की बदलती प्रकृति और उससे जुड़े संभावित नुकसानों को ध्यान में रखते हुए निरंतर विकसित हो रहे हैं, जिसमें यह भी शामिल है कि क्या कंपनी की पॉलिसी, इन सबसे तालमेल बनाए रखने के लिए बदल रही हैं।

हमारी स्वतंत्रता यूज़र के हित में है

केवल पांच वर्षों की अवधि में, बोर्ड एक साहसिक प्रयोग से आगे बढ़कर एक स्थापित मॉडल बन चुका है। इसके पास तर्कसंगत और सिद्धांत-आधारित न्यायिक फ़ैसलों का एक बढ़ता हुआ संग्रह है, जिसने ऑनलाइन कंटेंट पर मानवाधिकार सिद्धांतों को लागू करने के लिए पहली बार एक विस्तृत ब्लूप्रिंट प्रस्तुत किया है। कई प्लेटफ़ॉर्म के पास सलाहकार निकाय हैं। बोर्ड विशिष्ट इसलिए है, क्योंकि हम Meta से कानूनी रूप से स्वतंत्र हैं, हम बाध्यकारी फ़ैसले और सुझाव जारी करते हैं, जिन पर प्रतिक्रिया देने के लिए कंपनी बाध्य है, और हम दुनिया भर से आए विविधता वाले विशेषज्ञों से मिलकर बने हैं। इसके साथ ही, कोई भी नया प्रयोग ऐसे लाभ कमाने वाले वैश्विक व्यवसाय की अनिवार्यताओं के बीच रास्ता निकालने की चुनौतियों का सामना करेगा, जिसका उपयोग दुनिया भर में फैले कई बिलियन यूज़र हर दिन करते हैं।

यहां हम अपने कई निष्कर्षों को शेयर कर रहे हैं:

- एकरूप और निष्पक्ष फ़ैसले लेने की प्रक्रिया का आधार अंतरराष्ट्रीय मानवाधिकारों को बनाया जाए: एक स्वतंत्र ओवरसाइट बोर्ड के मॉडल में वैश्विक मानवाधिकार फ़्रेमवर्क को शामिल करना, सिद्धांत वाले और फ़ैसले लेने की एकरूप प्रक्रिया में सहायता करता है। बोर्ड, Meta के कंटेंट मॉडरेशन संबंधी दृष्टिकोण का विश्लेषण, अंतरराष्ट्रीय मानवाधिकार कानून के आधार पर करता है और यह भी खुले रूप से शेयर करता है कि किन प्रमुख संधियों और प्रावधानों ने हमारे फ़ैसलों का मार्गदर्शन किया है। मानवाधिकार कानून द्वारा निर्धारित विश्लेषणात्मक पूर्वापेक्षाएं और परीक्षण, यह सुनिश्चित करने में मदद करते हैं कि हमारी न्यायिक व्याख्याएं एकरूप तर्क पर आधारित हों और समय के साथ उनका अनुसरण किया जा सके। अभिव्यक्ति की स्वतंत्रता की मज़बूत सुरक्षा, इस मान्यता प्राप्त वैश्विक फ़्रेमवर्क का एक महत्वपूर्ण आधार स्तंभ है, जो कि अन्य महत्वपूर्ण उद्देश्यों, जैसे दूसरों के अधिकारों की रक्षा, राष्ट्रीय सुरक्षा या सार्वजनिक व्यवस्था, को पूरा करने के लिए अभिव्यक्ति पर कुछ प्रतिबंधों की भी अनुमति देता है। बोर्ड का, अंतरराष्ट्रीय मानवाधिकार कानून पर आधारित होना, हमें ऐसे फ़ैसले और सुझाव देने में सक्षम बनाता है, जिन्हें वैश्विक स्तर पर, सभी न्याय क्षेत्रों में लागू किया जा सकता है। सरकारों के लिए निर्धारित किए गए दायित्वों को किसी निजी कंपनी पर लागू करने की प्रक्रिया में कुछ हद तक व्याख्या और कल्पना शामिल होती है। किसी भी इंडस्ट्री में, किसी भी अन्य संस्था से अधिक, बोर्ड ने इन कड़ियों को जोड़ते हुए कॉरपोरेट संस्थाओं की मानवाधिकार जिम्मेदारियों को वास्तविकता में बदलने के लिए एक व्यावहारिक प्रतिमान विकसित किया है।

- संरचनात्मक स्वतंत्रता को बनाए रखना: किसी निगरानी निकाय का कंपनियों और सरकारों से कानूनी, संस्थागत और कार्यात्मक रूप से स्वतंत्र होना आवश्यक है, ताकि फ़ैसले लेने की प्रक्रिया को व्यावसायिक या राज्य हितों से प्रभावित होने से बचाया जा सके। बोर्ड की तरह, इसमें सतत वित्तपोषण की एक व्यवस्था भी शामिल होनी चाहिए, जिससे संस्था को अपने बजट, नेतृत्व, रणनीति और संचालन के लिए स्वयं जिम्मेदारी लेने का अधिकार मिले। बोर्ड के अपरिवर्तनीय ट्रस्ट के माध्यम से, हमारे संचालन 2027 तक पूर्ण रूप से वित्त-पोषित हैं। बोर्ड के न्यायिक फ़ैसले और फ़ैसले स्वतंत्र होते हैं, लेकिन हम Meta के सहयोग पर निर्भर रहते हैं, जिसमें केस पर विचार-विमर्श के दौरान प्रश्नों के उत्तर देना, सूचित फ़ैसले लेने की प्रक्रिया के लिए आवश्यक जानकारी उपलब्ध कराना, हमारे सुझावों को स्वीकार करना, और कंपनी की पॉलिसी पर हमारे सुझावों के प्रभाव की जानकारी हमें देना शामिल है, ताकि हम अपनी प्रभावशीलता को माप सकें।

- कार्यान्वयन के लिए सुदृढ़ प्रतिबद्धताओं को प्रोत्साहित करना: जब निगरानी निकाय अपने फ़ैसलों के कार्यान्वयन की निगरानी के लिए सख़्त प्रक्रियाएं बनाते हैं और इसके लिए आवश्यक जानकारी रखते हैं, तो उनका प्रभाव और अधिक सशक्त हो जाता है। कंटेंट के किसी एक पीस को बनाए रखना है या हटाना है, इस पर बोर्ड के फ़ैसले Meta के लिए बाध्यकारी हैं, जैसा कि हमारे चार्टर में लिखा हुआ है। हम Meta की कंटेंट मॉडरेशन प्रक्रिया को बेहतर बनाने के लिए गैर-बाध्यकारी सुझाव भी देते हैं, जिन पर प्रतिक्रिया देने के लिए कंपनी को 60 दिनों का समय दिया जाता है। बोर्ड की डेटा टीम ने, हमारे सुझावों का Meta द्वारा कार्यान्वयन किए जाने को स्वतंत्र रूप से ट्रैक करने के लिए अपनी स्वयं की शोध-पद्धति विकसित की है, जिसे हमारी वेबसाइट पर सार्वजनिक रूप से शेयर किया जाता है। यह Meta की स्वयं की रिपोर्टिंग से अलग है, जिसमें कंपनी को कार्यान्वयन के प्रमाण प्रस्तुत करने होते हैं और इसके माध्यम से हम कंपनी की प्रतिक्रियाओं का अपना स्वयं का आकलन शेयर कर सकते हैं। कभी-कभी, Meta ने हमारे सुझावों को लागू करने से इनकार भी किया है। उन केस में भी, हमारा मानना है कि, कम से कम कुछ अवसरों पर, समस्याओं को उजागर करना और Meta के तरीकों से संबंधित अधिक जानकारी को सार्वजनिक क्षेत्र में लाना, जागरूकता पैदा कर सकता है, जो अंततः सुधारात्मक कदमों को प्रेरित करता है। इसके परिणामस्वरूप, हमारा कार्य नागरिक समाज और अन्य पक्षों को Meta के साथ संवाद करने में सक्षम बनाता है कि वह कैसे और सुधार कर सकता है।

- दुनिया भर में फ़ैसले लेने वालों को सशक्त बनाना: सोशल मीडिया प्लेटफ़ॉर्म की वैश्विक प्रकृति को प्रतिबिंबित करने के लिए, निगरानी निकाय तब अधिक लाभान्वित होते हैं, जब वे फ़ैसला लेने की प्रक्रिया में दुनिया के विभिन्न हिस्सों से इनपुट को आमंत्रित करते हैं। हमारे 21 बोर्ड मेंबर के दृष्टिकोण यह सुनिश्चित करने में उपयोगी रहे हैं कि दुनिया भर के यूज़र को प्रभावित करने वाले महत्वपूर्ण फ़ैसले लेने से पहले, आवश्यक संदर्भ और क्षेत्रीय फ़ैक्टर को ध्यान में रखा जाए। हम प्रभावित हितधारकों और विश्व-भर के नागरिक समाज संगठनों से सक्रिय रूप से संपर्क करने का भी निरंतर प्रयास करते हैं, ताकि वे हमारे केस में लिखित इनपुट दे सकें और बोर्ड के साथ गोलमेज़ वार्ताओं में भाग लेकर हमारी फ़ैसले लेने की प्रक्रिया को बेहतर ढंग से सूचित कर सकें। यह संवाद उस स्थिति में भी सहायक होता है, जब यूज़र के अधिकारों से जुड़ी विभिन्न नियामक वास्तविकताओं को वैश्विक नज़र से समझना आवश्यक होता है।

- प्लेटफ़ॉर्म पर सबसे अधिक निर्भर लोगों के अधिकारों को प्रतिबिंबित करना: ऐसे हितधारकों को, जो किसी प्लेटफ़ॉर्म की सेवाओं पर निर्भर हैं या उनसे प्रभावित होते हैं, अपना इनपुट प्रदान करने के अवसर मिलने चाहिए। ऐसे माध्यम प्रदान करने से इन संस्थाओं की वैधता बढ़ सकती है। ऐसे चैनल सुलभ और समावेशी होने चाहिए, ताकि उन संगठनों और लोगों के दृष्टिकोण भी सामने आ सकें, जिन्हें पहले सीधे प्लेटफ़ॉर्म से जुड़ने में बाधाओं का सामना करना पड़ा हो। बोर्ड अपने केस में किए गए विश्लेषण को, पब्लिक कमेंट के एक महत्वपूर्ण सिस्टम के माध्यम से प्राप्त बाहरी हितधारकों के इनपुट से सुदृढ़ करता है। इस प्रकार के जुड़ाव को सक्रिय रूप से प्रोत्साहित करते हुए, हमें शोधकर्ताओं, संगठनों और लोगों से 11,000 से अधिक पब्लिक कमेंट प्राप्त हुई हैं, जो हमारे फ़ैसला लेने की प्रक्रिया को आकार देने और Meta को उसकी मानवाधिकार जिम्मेदारियों का निर्वहन करने के लिए प्रेरित करती हैं।

- डिज़ाइन के ज़रिए सुरक्षा को बढ़ावा देना: उत्पाद नवाचारों, प्लेटफ़ॉर्म सुविधाओं और कंटेंट मॉडरेशन प्रौद्योगिकी पर किसी स्वतंत्र निगरानी निकाय से प्रारंभिक चरण में इनपुट मांगना, व्यावसायिक दृष्टि से भी उचित है, क्योंकि इससे उच्च मानकों और सर्वोत्तम प्रथाओं को अपनाने को प्रोत्साहन मिलता है। बोर्ड का मानना है कि तेज़ी से विकसित हो रही प्रौद्योगिकी के विकास चरण में ही मानवाधिकार सिद्धांतों को शामिल किया जाना आवश्यक है। अब तक, हमने Meta के प्लेटफ़ॉर्म के फ़ीचर से उत्पन्न डिज़ाइन-संबंधी समस्याओं पर अपने सुझावों के माध्यम से विचार किया है और Meta के कुछ सीमित उत्पादों में सुधार के अवसरों की पहचान की है। हालांकि, तेज़ी से बदलती किसी इंडस्ट्री में, जहां विकास के अवसरों के साथ-साथ यूज़र के अधिकारों के लिए जोख़िम भी बढ़ते हैं, नैतिक और प्रणालीगत चुनौतियों से प्रभावी ढंग से निपटने के लिए यह आवश्यक होगा कि किसी निगरानी निकाय को अपनी भूमिका के दायरे का यथासंभव लचीला और समयानुकूल विस्तार करने की अनुमति दी जाए।

बोर्ड का विकास: भविष्य की ओर एक दृष्टि

पिछले पांच वर्षों में, जिस दौरान बोर्ड अपीलें स्वीकार करता रहा है, सोशल मीडिया प्लेटफ़ॉर्म और उनके साथ यूज़र के संवाद करने के तरीके में उल्लेखनीय रूप से परिवर्तन हुआ है। इस अवधि में, बोर्ड के कार्य में कंटेंट मॉडरेशन से उत्पन्न सबसे विवादास्पद मुद्दे प्रतिबिंबित हुए हैं, जहां हमने अभिव्यक्ति की स्वतंत्रता के प्रति अपनी मज़बूत प्रतिबद्धता और अन्य मानवाधिकारों की रक्षा के बीच संतुलन बनाने का प्रयास किया है। हमने वैश्विक चुनावों, संघर्षों और सामाजिक बहसों से संबंधित फ़ैसले जारी किए हैं, एन्फ़ोर्समेंट सिस्टम की डिज़ाइन पर विचार किया है, और Meta के प्लेटफ़ॉर्म को प्रभावित करने वाली प्रणालीगत समस्याओं पर प्रकाश डाला है।

हमारा दायरा भी विकसित हुआ है, जिसमें अब Facebook और Instagram पर कंटेंट को रिस्टोर करने और हटाए जाने, चेतावनी स्क्रीन के उपयोग, और एक तीसरे प्लेटफ़ॉर्म Threads को शामिल किया गया है। 2026 में, हमारा दायरा एक बार फिर विस्तृत होगा, जब हम Meta के उन फ़ैसलों को रिव्यू करने की क्षमता का परीक्षण करेंगे, जिनके तहत खातों को हटाया जाता है या प्रभावित किया जाता है, ऐसी चीज़, जिसने प्लेटफ़ॉर्म यूज़र के लिए लगातार निराशा पैदा की है।

बोर्ड की पहली बार घोषणा किए जाने के समय से ही, हमने अपने सामने मौजूद कार्य की व्यापकता को समझ लिया था, और उन संदेहवादियों व आलोचकों की चिंताओं को गंभीरता से लिया था, जो हमारे प्रयासों की वैधता और प्रभावशीलता पर सवाल उठा रहे थे। पिछले पांच वर्षों में, हमें निराशा भी हुई और ऐसे क्षण भी आए, जब आशा के अनुरूप प्रभाव देखने को नहीं मिला। अधिकतम संभव प्रभाव प्राप्त करने के लिए, हमने अपने पास उपलब्ध शक्तियों और प्रभाव का इस्तेमाल करने पर ध्यान केंद्रित करना देना सीख लिया है। हमें विशिष्ट रूप से यह अधिकार प्राप्त है कि हम Meta से जानकारी मांग सकें, अपने प्रश्नों के उत्तर प्राप्त कर सकें, अपने सुझावों पर प्रतिक्रियाएं पा सकें, और कंपनी के नेतृत्व से संवाद कर सकें। ऐसा ऐक्सेस किसी अन्य संस्था के पास नहीं है। हम इन अवसरों का निरंतर उपयोग करते रहेंगे, ताकि यूज़र के लिए पर्दे के पीछे की प्रक्रियाओं को उजागर किया जा सके और उन्हें उस कंपनी को बेहतर ढंग से समझने में सहायता मिल सके, जो उनके जीवन को प्रभावित करती है। जब हमारे फ़ैसलों और सुझावों को लागू किया जाता है, तो वे विश्व-भर के कई बिलियन लोगों को ऑनलाइन अपनी अभिव्यक्ति की रक्षा करने और सुरक्षित रहने की अधिक शक्ति प्रदान करते हैं।

आगे का मार्ग: कंटेंट मॉडरेशन से आगे

2024 में, हमने केस विशेष से आगे बढ़कर, अपने कुछ निष्कर्षों को श्वेत-पत्रों के रूप में औपचारिक रूप देना, चुनावों और AI और ऑटोमेशन के नए युग पर अवलोकन प्रकाशित करना शुरू किया। हाल ही में, बोर्ड ने कंटेंट संचालन और प्लेटफ़ॉर्म जवाबदेही पर व्यापक चर्चाओं में भी कदम रखा है, विशेष रूप से नए यूरोपीय यूनियन विनियमों के अंतर्गत किए जाने वाले प्रणालीगत जोख़िम आकलनों में अभिव्यक्ति की स्वतंत्रता की भूमिका को आगे बढ़ाने के संदर्भ में।

विकसित होती प्रौद्योगिकियों के मानवाधिकार निहितार्थों की जांच के प्रति एक प्रतिबद्धता, जो कंटेंट मॉडरेशन से संबंधित हो और उससे परे भी जाती हो, बोर्ड के भविष्य के कार्य को दिशा देगी। एन्फ़ोर्समेंट प्रौद्योगिकी, ऑटोमेशन और AI से मिले अनुभवों के आधार पर, बोर्ड अपने दायरे का विस्तार करेगा, ताकि AI टूल और उत्पादों की ज़िम्मेदार तैनाती पर अधिक गहराई से विचार किया जा सके। उदाहरण के लिए, जब तकनीकी प्लेटफ़ॉर्म, जनरेटिव-AI उत्पादों, जैसे कि बड़े भाषा मॉडल, चैटबॉट और एजेंटिक AI के डिज़ाइन और विकास की ओर आगे बढ़ रहे हैं, तो मानवाधिकारों पर उचित विचार को उनके डिज़ाइन और विकास में प्रभावी रूप से कैसे शामिल किया जा सकता है? और जैसे-जैसे जनरेटिव AI ऑनलाइन कंटेंट की प्रकृति को ही बदल रहा है, इंडस्ट्री को इसके निर्माण से जुड़े नए-नए उभरते नुकसानों से निपटने में कौन-सा मार्गदर्शन मदद कर सकता है, जिनमें से कई ऐसे हैं, जिनमें से कई उन नुकसानों जैसे हैं, बोर्ड पहले ही जिनका समाधान सोशल मीडिया के संदर्भ में कर चुका है। हमें आशा है कि इंडस्ट्री से संबंधित इन महत्वपूर्ण चर्चाओं में हमारा योगदान, वैश्विक और यूज़र के अधिकार पर आधारित दृष्टिकोण के साथ आगे का रास्ता स्पष्ट करेगा।

बोर्ड, वैश्विक तकनीकी कंपनियों के साथ साझेदारी करने की स्थिति में भी है, जब वे विश्व-भर में स्वतंत्र अभिव्यक्ति से जुड़ी बहसों का सामना कर रही हों, जिसमें प्लेटफ़ॉर्म पर सरकारी दबाव का ऑनलाइन सेंसरशिप जैसा प्रभाव होना भी शामिल है। हमारी रुचि इस बात में भी है कि सोशल मीडिया से जुड़ी गंभीर चुनौतियां क्या हैं, जिन्हें सबसे कम उम्र के यूज़र प्लेटफ़ॉर्म पर अनुभव करते हैं। हम उनकी अभिव्यक्ति की स्वतंत्रता और ऑनलाइन जानकारी के ऐक्सेस के अधिकार की रक्षा किस तरीके से कर सकते हैं, जो कि उन्हें दुर्व्यवहार और शोषण से सुरक्षित रख सके?

ऐसी बुनियादी चुनौतियां वैश्विक दृष्टिकोणों की व्यापक भागीदारी की मांग करती हैं, ताकि राजनीतिक मतभेदों के बावजूद, स्वतंत्र अभिव्यक्ति जैसे अधिकारों के प्रति सम्मान और यूज़र के लिए प्लेटफ़ॉर्म द्वारा लगातार जवाबदेही को निभाना सुनिश्चित किया जा सके। बोर्ड आने वाले महीनों और वर्षों में तकनीकी इंडस्ट्री के सामने मौजूद सबसे कठिन नीतिगत और नैतिक दुविधाओं से निपटने के लिए, इन विभिन्न दृष्टिकोणों के बीच सेतु बनने और समाधान-उन्मुख सुझाव देने में अपनी भूमिका निभाने के प्रति उत्सुक है।