D'expérience ambitieuse à institution incontournable

Comment cinq années de surveillance indépendante ont rendu Meta plus responsable et ont protégé les droits des utilisateurs.

Synthèse analytique

En 2018, Facebook faisait face à une condamnation généralisée. Après avoir surfé sur une vague d'optimisme, suivie de plus d'une décennie de croissance exponentielle, l'entreprise était confrontée à la colère de plus en plus marquée de ses plus de 2 milliards d'utilisateurs dans le monde entier. Le scandale Cambridge Analytica, qui avait révélé le partage sans consentement des informations personnelles de millions de comptes, a attiré l'attention sur la question cruciale de la confidentialité des utilisateurs. Les échecs de l'entreprise à lutter contre les discours incitant à la haine sur la plateforme ont contribué à des préjudices réels et à des violations des droits humains lors du génocide des Rohingyas en Birmanie.

En parallèle, les utilisateurs ont vu leur liberté d'expression compromise à plusieurs reprises, en raison de la suppression sur Facebook et Instagram de discours politiques légitimes, d'expressions artistiques, de contenus de sensibilisation et de satires, au nom de règles qui semblaient vagues et arbitraires.

Lors d'élections cruciales, la désinformation et les fausses informations ont entravé la capacité des utilisateurs à faire des choix éclairés et ont même faussé les résultats. Les contenus représentant et encourageant l'automutilation et des pratiques dangereuses sont devenus plus fréquents. Les utilisateurs en dehors des États-Unis ont été soumis à une politique de modération du contenu peu adaptée à leur propre région, les décisions ne tenant pas compte des langues, de la culture ou du contexte politique locaux.

Pour couronner le tout, les utilisateurs ignoraient souvent comment faire appel si leur contenu était supprimé ou bien quelles règles ils étaient censés avoir enfreintes. L'entreprise faisait preuve d'un manque de transparence patent concernant les algorithmes et les processus qui sous-tendaient des choix importants quant au contenu à conserver ou à supprimer de la plateforme.

Facebook avait conscience que les groupes de dirigeants de l'entreprise ne devaient pas prendre seuls des décisions aussi importantes en matière de modération de contenu. C'est ce qui a poussé Facebook, désormais appelée Meta, à annoncer la création du Conseil de surveillance en 2018. Le Conseil a sélectionné ses premiers cas en octobre 2020. Il reste à ce jour le seul organe de surveillance de ce type.

Transparence pour les utilisateurs et une approche fondée sur les droits humains

Cinq ans plus tard, le Conseil a réalisé des progrès considérables pour les utilisateurs mondiaux de Meta, en apportant de la transparence, un raisonnement logique et une approche fondée sur les droits humains à des décisions qui étaient depuis longtemps prises à huis clos, sans justification publique, ou presque. Le modèle que nous avons mis en place rassemble des experts du monde entier pour examiner de manière indépendante les décisions relatives aux contenus sensibles sur les plateformes Meta, en tenant compte des avis du public et de la société civile. Les membres du Conseil proviennent d'horizons politiques,

idéologiques, géographiques, culturels et professionnels divers. Cela nous permet de mieux prendre en compte les différents contextes qui affectent la liberté d'expression et d'autres droits humains dans différentes régions du monde. Le Conseil prend des décisions contraignantes concernant la suppression ou le maintien des contenus. Nous formulons également des recommandations cruciales en vue d'améliorer le système.

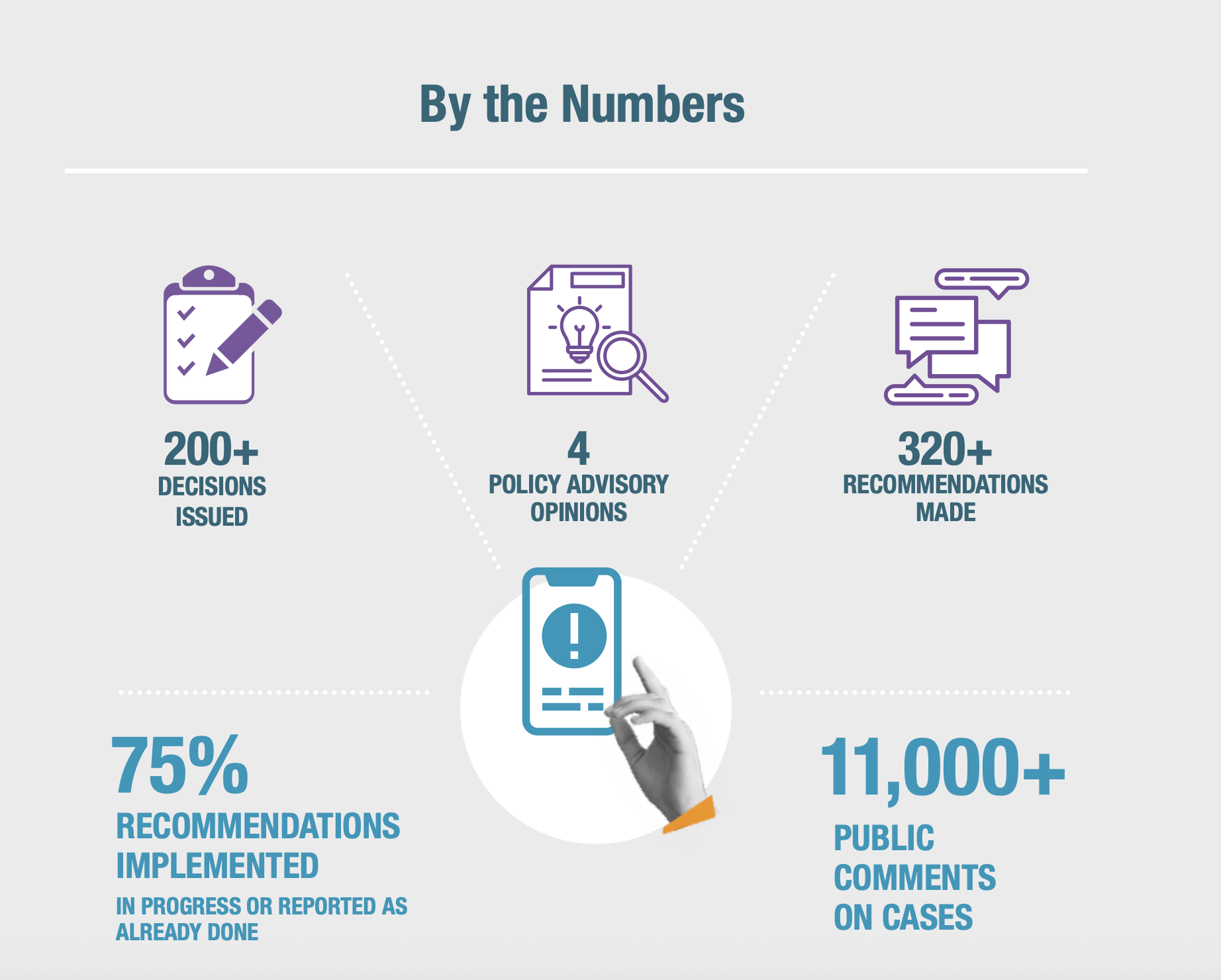

Meta s'est engagée à respecter nos décisions d'approbation ou de rejet concernant certains contenus et est tenue de répondre publiquement à nos recommandations, deux promesses que l'entreprise a tenues. Bien que Meta ne soit pas légalement tenue d'implémenter toutes nos recommandations, elle a appliqué 75 % des plus de 300 recommandations que nous avons formulées, ce qui a permis d'améliorer la transparence et la responsabilisation de l'entreprise. Toutes les recommandations ont contribué à éclairer les discussions et les débats concernant la politique de modération du contenu et son application.

Ces efforts ont eut des résultats significatifs pour les milliards d'utilisateurs de Facebook, Instagram et Threads à travers le monde, allant de la garantie de l'adaptation par Meta de ses algorithmes pour mieux protéger les contenus de sensibilisation et la satire, jusqu'à la mise en place d'une meilleure procédure officielle et de secondes chances pour les utilisateurs qui enfreignent les règles et font l'objet de sanctions.

Le travail du Conseil a permis de faire de Meta une entreprise plus responsable, plus transparente et mieux informée. Il reste toutefois encore beaucoup à faire. Le Conseil a démontré qu'une autorité de surveillance indépendante, habilitée à prendre des décisions contraignantes sur le contenu et à formuler des recommandations non contraignantes nécessitant une réponse publique, fonctionne bien dans la pratique et, plus important encore, peut offrir un cadre à suivre pour d'autres plateformes.

La décision de Meta de créer le Conseil, de le soutenir financièrement, d'imposer des protections pour assurer son indépendance décisionnelle et de lui donner le pouvoir nécessaire pour prendre des décisions et formuler des recommandations était sans précédent. À l'époque de la création du Conseil, l'espoir était que d'autres plateformes de réseaux sociaux prennent des mesures similaires pour s'obliger à rendre des comptes auprès de leurs utilisateurs grâce à une surveillance indépendante, ou même en collaborant avec le Conseil lui-même. Jusqu'à présent, aucune ne l'a fait. Les interactions du Conseil avec Meta impliquent des efforts continus de promotion et de négociation, et le Conseil n'obtient jamais le niveau d'accès ou d'influence qu'il souhaiterait. Le Conseil respecte néanmoins énormément les risques et les obligations assumés volontairement par Meta au nom de son engagement en faveur d'un meilleur respect des responsabilités de l'entreprise en matière de droits humains.

Le Conseil a été créé à titre expérimental, et c'est dans cette optique que nous avons décidé d'aborder notre travail, en mettant l'apprentissage et le perfectionnement au centre de nos missions. Il nous a fallu un peu de temps pour mettre au point nos méthodes pour définir des priorités, choisir les cas, recueillir les informations nécessaires à nos décisions, formuler des recommandations pertinentes et contrôler leur implémentation. Nous sommes fiers du travail accompli au nom des utilisateurs de Meta. Nous sommes également conscients de l'influence internationale de la plateforme, des limites de notre champ d'action et des grands défis qui persistent. À l'avenir, nous sommes déterminés à tirer parti de notre position unique d'organe de défense du respect des droits humains dans l'ensemble du secteur technologique.

Nos avancées pour les utilisateurs

Le travail du Conseil de surveillance a permis au public de mieux comprendre le fonctionnement des systèmes de Meta. Lorsque nous identifions des risques ou des lacunes dans la modération de contenu de l'entreprise, nous recommandons des solutions qui ont une influence directe sur les politiques, les processus, ainsi que les technologies et pratiques de mise en application de Meta. Depuis notre première décision, rendue en janvier 2021, nous avons obtenu les avancées suivantes pour le compte des utilisateurs :

- Amélioration de la liberté d’expression : lorsque nous rendons une décision, nous défendons non seulement une publication, mais aussi un principe : l'espace public en ligne doit rester ouvert et sûr pour permettre à des opinions diverses de s'exprimer, même lorsque les propos sont controversés, offensants ou critiques à l'égard des personnes au pouvoir. Nos recommandations ont modifié les politiques et les approches de mise en application de Meta afin de permettre à davantage de discours de rester sur Facebook, Instagram et Threads. Ce rapport explique comment le Conseil a traité ces questions, notamment : en Iran, où les déclarations de type « À bas Khamenei » ont été restaurées afin de protéger la liberté d'expression politique ; en Afghanistan, où davantage de discussions et de signalements concernant les talibans ont été autorisés s'ils étaient d'intérêt public ; et en Amérique du Nord, où le Conseil a restauré les publications d'un artiste autochtone qui sensibilisait le public aux crimes historiques commis contre les peuples autochtones.

- Plus de transparence pour donner aux utilisateurs tous les outils nécessaires et promouvoir la responsabilisation : pour renforcer l'équité entre les utilisateurs, nous avons insisté pour que Meta augmente sa transparence concernant ses règles et les mesures qu'elle prend à l'encontre de certains contenus. Au Royaume-Uni, le Conseil a révélé des erreurs de mise en application dans un cas concernant la musique drill, qui restreignait de manière excessive l'expression artistique de groupes marginalisés. Dans plusieurs cas, nous avons poussé Meta à indiquer aux utilisateurs la politique spécifique que leur contenu est censé enfreindre lorsqu'elle prend une mesure de mise en application. L'entreprise met cette pratique en œuvre depuis 2024.

- Meilleure gestion des enjeux majeurs et protection des communautés vulnérables : nos recommandations ont permis d'attirer davantage l'attention sur les conflits et les crises et de mettre en place des processus plus réactifs. Meta a notamment implémenté une politique de protocole de crise et un cadre de gestion des contenus pendant les élections. L'entreprise a également traité les biais de son système de recoupement. Ce système, qui vise à accorder des examens supplémentaires aux contenus potentiellement en infraction des utilisateurs et des pages de premier plan et disposant de vastes audiences, était appliqué de manière injuste et portait préjudice aux utilisateurs standard. En outre, le Conseil n'a jamais cessé de défendre les communautés vulnérables, telles que les défenseurs des droits humains et les leaders de l'opposition dans les régimes répressifs, et nos décisions ont abouti à la suppression de publications incitant à la violence homophobe.

- Intégration des principes des droits humains à l'IA et à l'automatisation : nous formulons de plus en plus de recommandations mettant en lumière, du point de vue des droits humains, les domaines dans lesquels les politiques et les systèmes de Meta ne sont pas adaptés aux contenus générés par l'IA. Les recommandations du Conseil ont poussé Meta à créer des étiquettes d'IA. Apposées depuis sur des milliards de contenus manipulés, ces étiquettes aident les utilisateurs à évaluer la crédibilité du contenu qu'ils voient. En 2021, nous avons souligné que les systèmes automatisés de Meta supprimaient par erreur des publications de sensibilisation au cancer du sein, ce qui a entraîné des changements visant à mieux protéger ce type de contenu.

Nos conclusions

Notre capacité à formuler des recommandations solides est due à la nature de notre modèle unique. Si nous avons pu faire notre travail au cours des cinq dernières années, c'est grâce à la diversité des points de vue de nos experts internationaux, aux commentaires sur les cas traités que nous invitons le public à nous transmettre et à notre approche fondée sur les droits humains.

L'indépendance du jugement des membres du Conseil est protégée par une série de mécanismes, dont voici quelques exemples : le Conseil dispose de sa propre direction ; les membres du Conseil sont soumis à un mandat à durée déterminée ; le financement du Conseil est fixe et apporté par une fiducie irrévocable ; et Meta ne peut pas retirer les fonds déjà engagés si elle n'est pas d'accord avec nos décisions.

Au fur et à mesure que nous les acquérons, nous présentons les enseignements tirés de nos activités aux utilisateurs, aux entreprises technologiques et aux décideurs politiques, en soulignant les facteurs clés qui nous ont permis de développer un modèle de surveillance efficace en matière de gouvernance de contenu. Nous évoquons également les limites que nous avons rencontrées tout au long de notre parcours.

Ce que l'avenir nous réserve

Notre modèle de surveillance indépendante continue de favoriser la transparence, la responsabilité, les échanges ouverts et le respect de la liberté d'expression et des autres droits humains sur les plateformes Meta, renforçant ainsi les droits des utilisateurs à l'échelle mondiale. Le Conseil ne se fait toutefois aucune illusion quant à l'ampleur des défis auxquels le secteur fait face, à mesure que les progrès rapides de l'IA, les réglementations relatives aux réseaux sociaux et les conflits géopolitiques concernant les droits d'expression des utilisateurs compliquent la manière optimale de gérer les contenus à grande échelle.

Nous avons hâte de relever ces défis en rédigeant de manière plus formelle nos conclusions, au-delà des simples cas individuels, et en les intégrant à des livres blancs sur des priorités majeures, telles que la nouvelle ère de l'IA et de l'automatisation. Nous avons déjà engagé un dialogue plus poussé sur la gouvernance des contenus et la responsabilisation des plateformes. Le Conseil est également bien placé pour établir des partenariats avec diverses entreprises internationales confrontées à des questions issues des débats sur la liberté d'expression dans le monde entier. Même dans un monde qui change, nous restons fidèles à notre mission fondatrice : intégrer la liberté d'expression et les autres droits humains aux technologies en constante évolution et renforcer la responsabilité envers les utilisateurs.

Amélioration de la liberté d’expression

Conformément à notre objectif fondateur de protéger la liberté d'expression, nous avons identifié des situations dans lesquelles la modération de Meta a restreint de manière excessive la liberté d'expression, en empêchant les commentaires politiques, l'expression personnelle et le débat public en ligne. Nos recommandations visent à empêcher la suppression injustifiée de certains discours, tels que les contestations politiques, les reportages d'actualité, les actions de sensibilisation sur des sujets d'intérêt public et l'expression personnelle, tout en protégeant les autres droits humains.

Avec des milliards de contenus publiés chaque jour, nos recommandations visent également à réduire la fréquence des erreurs de modération commises par les systèmes de Meta. Pour ce faire, nous cherchons à identifier les aspects des systèmes automatisés et des processus d'examen manuel de Meta qui sont susceptibles de supprimer le contenu des utilisateurs en raison d'une mauvaise interprétation, d'une incapacité à tenir compte des nuances ou du contexte, ou d'un défaut d'implémentation des exceptions applicables à la politique.

Supprimer les restrictions des discours contenant des menaces de violence non crédibles

Nous avons à plusieurs reprises renversé la décision erronée de Meta de supprimer des contenus politiques contenant des menaces de violence figuratives, qu'elles soient liées à une élection imminente, à un scandale politique ou à un mouvement de protestation (Poème russe, Déclarations à propos du premier ministre japonais, Rapports sur le discours du parlement pakistanais). Les élections et la politique entraînent souvent une rhétorique enflammée et l'utilisation de métaphores et d'hyperboles. Les utilisateurs devraient pouvoir s'exprimer librement et sans retenue sur la politique, et notamment critiquer des personnalités de premier plan telles que les présidents ou les premiers ministres, sans que les plateformes n'ajoutent d'obstacles inutiles à cette liberté d'expression. Nous avons régulièrement incité Meta à adopter une approche plus nuancée afin de distinguer les menaces de violence pouvant présenter un risque dans le monde réel, et les propos qui, bien que virulents, sont utilisés de manière figurative et entrent donc dans le cadre du débat politique.

Dans un cas concernant les manifestations iraniennes « Femme, Vie, Liberté » de 2022, nous avons argumenté que les déclarations « marg bar Khamenei » ne devaient pas être considérées comme une infraction aux règles de Meta contre les menaces (Slogan de protestation en Iran). Cette expression peut être traduite de plusieurs façons (par exemple, « mort à Khamenei », faisant référence à l'ayatollah Ali Khamenei, le guide suprême de l'Iran), mais dans ce contexte, elle était utilisée comme une rhétorique politique signifiant « à bas Khamenei ». Meta a accepté notre analyse dans le contexte des manifestations en cours, revenant sur sa décision pour désormais autoriser de telles déclarations. Une augmentation de 29 % des publications Instagram contenant cette déclaration, mesurée sur les mêmes pages, groupes et comptes, a ainsi été constatée après l'application de cette décision.

En réponse à nos recommandations, Meta mène désormais un processus visant à élaborer une politique relative aux expressions liées aux « appels à la mort », afin de réfléchir à la façon dont l'entreprise devrait aborder ce type de discours lorsqu'il est utilisé dans des contextes non menaçants, « tels que les plaisanteries, la musique et les appels figuratifs à la mort ». Le Conseil a participé au processus et a fait part à Meta de ses commentaires sur les modifications potentielles à apporter aux politiques et à leur application.

Empêcher le bâillonnement des voix de l'opposition

Les menaces de violence crédibles en ligne, bien qu'elles constituent une forme d'expression, nuisent à la liberté d'expression et au débat politique, en particulier lorsqu'elles émanent de personnes en position d'autorité. Les réseaux sociaux, y compris les plateformes Meta, constituent souvent des espaces essentiels au débat public, et ce tout particulièrement dans des contextes politiques répressifs. Si des voix diverses, y compris celles de dissidents politiques, sont effectivement réduites au silence à la suite d'intimidations, la qualité du débat s'en voit affectée. Le Conseil a souligné que l'obligation de Meta de respecter les principes de la liberté d'expression l'oblige à veiller à ce que ces voix ne soient pas exclues de facto, en raison d'un climat de peur sur ses plateformes (Premier ministre cambodgien, Défenseuse des droits humains au Pérou).

Les menaces de violence grave formulées à l'encontre d'individus sont parfois voilées ou déguisées et nécessitent donc un examen manuel plus approfondi, tenant compte du contexte. Le Conseil a tiré la sonnette d'alarme sur le risque de sous-application des règles (laisser par erreur des contenus en ligne) pour de telles menaces et a appelé Meta à mobiliser des ressources supplémentaires pour identifier les menaces voilées dans différents contextes culturels et politiques (Défenseuse des droits humains au Pérou). En réponse, l'entreprise indique qu'elle étudie comment intégrer plus clairement les signaux écrits, visuels et verbaux de menaces codées dans ses évaluations, et s'engage à renforcer ce cadre.

Préserver la liberté d'expression dans l'intérêt public sur les plateformes de Meta

Dans de nombreux cas, le Conseil a estimé que Meta avait supprimé à tort des contenus qui, même s'ils enfreignaient les Standards de la communauté de l'entreprise, présentaient néanmoins un intérêt public et auraient dû être exemptés de suppression en vertu de la clause d'« intérêt médiatique » de l'entreprise. Dans un cas au Mexique, le Conseil a restauré une publication montrant l'assassinat de José Alfredo Cabrera Barrientos, candidat à la mairie, en vertu de la clause d'intérêt médiatique (Assassinat d'un candidat dans le cadre des élections municipales au Mexique). Et dans un cas en Haïti, le Conseil a renversé la décision de Meta de supprimer une vidéo Facebook montrant des personnes entrant dans un poste de police et proférant des menaces de violence, en vertu de la même exemption (Vidéo d'un poste de police haïtien). Ces décisions ont élargi les droits des utilisateurs en matière de liberté d'expression sur les plateformes de Meta en soulignant l'importance d'autoriser les débats et l'expression sur des questions d'actualité touchant le public.

Empêcher la suppression de contenus identifiés à tort comme étant en infraction

Meta ajoute à ses bases de services de mise en correspondance du contenu multimédia les images et les vidéos que les examinateurs manuels ont identifiées comme enfreignant la politique de l'entreprise. Ces bases peuvent ensuite identifier et supprimer automatiquement le contenu chaque fois qu'il réapparaît sur la plateforme, quelle que soit la personne l'ayant publié. Il arrive toutefois que les examinateurs fassent des erreurs, comme dans un cas de 2022 relatif à une caricature décrivant la violence policière en Colombie (Dessin représentant la police colombienne). Lorsque des contenus qui ont été jugés comme n'enfreignant pas les règles restent néanmoins dans ces bases de données, l'impact des décisions de modération erronées est amplifié sur des milliers, voire des millions de contenus. Nous avons donc exhorté Meta à mettre au point une méthode permettant de réévaluer les contenus faisant l'objet d'un taux élevé d'appels réussis de la part des utilisateurs et de les supprimer rapidement de la base dès lors qu'ils sont jugés comme n'enfreignant pas les règles. Meta a depuis mis en place une équipe interne chargée d'améliorer la gestion de ce système, ce qui a conduit à l'introduction d'un mécanisme de détection des « pics », afin de reconnaître plus rapidement un volume élevé de contenus n'enfreignant pas les règles et de s'assurer qu'ils sont retirés de la base, et non supprimés à tort par les systèmes automatisés de Meta lorsqu'ils sont publiés par les utilisateurs.

Permettre aux utilisateurs de fournir un contexte lorsqu'ils font appel de la suppression d'un contenu

Donner la parole aux utilisateurs et les écouter peut aider les plateformes à prendre de meilleures décisions lorsqu'il s'agit de choisir de supprimer ou non un contenu. Afin d'éviter une application excessive (suppression erronée de contenu) des règles pour les publications attirant l'attention sur les discours incitant à la haine afin de les condamner, de s'en moquer ou de sensibiliser à leur sujet, nous avons demandé à Meta de créer une méthode pratique permettant aux utilisateurs d'indiquer dans leur appel que leur publication relevait de l'une de ces catégories (Meme aux deux boutons, Partage d'informations privées sur le lieu de résidence). Entre août et novembre 2023, l'entreprise a mis en place un dispositif permettant aux utilisateurs de Facebook et d'Instagram d'ajouter un contexte supplémentaire à leurs appels, afin d'expliquer la nature de leur publication et de justifier pourquoi celle-ci n'enfreint pas les règles. L'entreprise a indiqué avoir reçu plus de 7 millions d'appels au cours du mois de février 2024 de la part de personnes dont le contenu avait été supprimé en vertu des règles relatives à la conduite haineuse. Parmi les personnes ayant fait appel, 80 % ont choisi de fournir un contexte supplémentaire. La possibilité de donner plus de contexte est désormais offerte aux utilisateurs pour tous les appels liés aux Standards de la communauté.

Mettre en place des initiatives éducatives pour réduire les contraintes sur la liberté d'expression des utilisateurs

Certaines des sanctions les plus lourdes pesant sur la liberté d'expression des utilisateurs résultent des avertissements et des restrictions de compte appliqués dans le cadre de la politique de Meta en matière de contenu. Depuis notre premier avis consultatif en matière de politiques (Partage d'informations privées sur le lieu de résidence), nous exhortons Meta à mettre en place des alternatives pour éviter un impact disproportionné sur la liberté d'expression.

Depuis le début de l'année 2025 et conformément à une recommandation du Conseil, Meta envoie désormais un « avis d'infraction admissible » aux utilisateurs enfreignant pour la première fois un Standard de la communauté d'une manière considérée par Meta comme « mineure »*. L'avis comprend des détails concernant la politique que l'utilisateur est censé avoir enfreinte, accompagnés d'une option permettant à l'utilisateur de faire appel de la décision ou de réaliser un exercice de formation afin d'éviter qu'une pénalité ne soit appliquée à son compte. Plus de 7,1 millions d’utilisateurs Facebook et 730 000 utilisateurs Instagram ont choisi de consulter l’« avis d’infraction admissible » pendant une période de trois mois à compter de janvier 2025. Parmi ces utilisateurs, près de 3 millions se sont alors lancés dans cet exercice de formation et la majorité d’entre eux (plus de 80 % sur Facebook et plus de 85 % sur Instagram) ont suivi toutes les étapes, évitant ainsi une sanction et les restrictions qui en auraient dû être appliquées à leur compte.

Un sondage envoyé par Meta aux utilisateurs après l'exercice a fait ressortir des commentaires positifs, indiquant que la partie éducative avait été bien accueillie et que les utilisateurs appréciaient l'approche consistant à leur offrir la possibilité de se former pour éviter des sanctions sur leur compte.

* Cette fonctionnalité exclut les infractions les plus graves aux Standards de la communauté, telles que l’exploitation sexuelle, les drogues à haut risque et la représentation, la promotion ou la glorification d’organisations dangereuses désignées par Meta.

Modifier la politique relative aux individus et organisations dangereux afin d'ouvrir le débat politique

Pour se conformer au droit international en matière de droits humains, les règles restreignant la liberté d'expression doivent, entre autres, être claires, précises et accessibles au public. Le Conseil applique ces normes lorsqu'il évalue les politiques de Meta. Dès ses premières décisions, le Conseil a déclaré que la politique de Meta relative aux individus et organisations dangereux ne répondait pas à cette exigence, ce qui avait pour conséquence de restreindre de manière excessive les discussions politiques en ligne (Citation nazie, Isolement d'Öcalan, Publication partagée d'Al Jazeera, Références à des personnes dangereuses désignées sous le terme « Chahid »). En 2022, le Conseil a renversé la décision de Meta de supprimer une publication qui reprenait un article de presse sur les déclarations d'un porte-parole des talibans annonçant la réouverture des écoles pour les femmes et les filles. La publication avait été supprimée au motif que les talibans avaient été désignés par Meta (ainsi que par de nombreux gouvernements) comme une organisation dangereuse et que la publication contenait une forme d'« éloge » à l'égard de cette organisation. Le Conseil a indiqué que la publication en question relatait les actions des talibans et que la transmission de telles informations constituait un droit important, tant pour ceux qui partagent ces informations que pour ceux qui les reçoivent, en particulier en période de conflit et de crise.

Dans notre avis consultatif en matière de politiques de 2024, nous avons relevé l'information fournie par Meta indiquant que le terme arabe « chahid » (que l'on pourrait traduire approximativement par le terme « martyr ») était à l'origine, à l'échelle mondiale, de plus de suppressions de contenu en vertu des Standards de la communauté que tout autre mot. Ces suppressions résultaient de l'interdiction d'utiliser le mot « chahid » à proximité du nom d'une personne ou d'une organisation jugée dangereuse par l'entreprise. Cette interdiction partait du principe que toutes les publications de ce type constituaient une glorification des terroristes ou d'autres acteurs dangereux, alors que ce n'était pas le cas. Le Conseil a constaté que le terme « chahid » est utilisé dans de nombreux contextes culturels différents et n'est pas toujours synonyme d'éloges. De plus, la proximité du mot « chahid » avec le nom d'une personne ou d'une organisation dangereuse ne signifiait pas toujours que la publication associée faisait l'apologie de la violence. Pour remédier à ce problème nous avons demandé que la politique relative aux individus et organisations dangereux soit mise à jour afin d'éviter la suppression automatique des références à des individus et organisations dangereux associées au mot « chahid ». Après l'implémentation de la plupart de nos recommandations, l’équipe chargée des données du Conseil a identifié une augmentation de 19,5 % des publications quotidiennes contenant le mot « chahid » et faisant plus de 50 000 vues.

Dans une décision de 2025 (Symboles adoptés par des organisations dangereuses), nous avons de nouveau identifié les lacunes de la politique relative aux individus et organisations dangereux. Nous avons en effet remarqué que les critères internes appliqués par Meta pour identifier les symboles souvent utilisés par les groupes haineux sont bien plus larges que ce qui est annoncé publiquement. Il est important que la définition complète soit rendue publique, afin que les utilisateurs comprennent ce qu'ils ne peuvent pas publier. L'entreprise s'est engagée à publier une mise à jour à ce sujet.

Plus de transparence pour donner aux utilisateurs tous les outils nécessaires et promouvoir la responsabilisation

Le Conseil a exhorté Meta à faire preuve de plus de transparence en indiquant quand les gouvernements influencent les décisions relatives au contenu ou les politiques régissant ses plateformes. Nous avons cherché à donner aux utilisateurs les outils nécessaires en leur fournissant des informations et des données sur le fonctionnement des algorithmes d'application et sur la manière dont les Standards de la communauté sont appliqués à leur contenu. Meta a amélioré sa transparence en réponse à nos recommandations demandant la publication de rapports sur les erreurs d'application et la garantie de l'accès des chercheurs indépendants aux données.

Révéler les demandes d'examen ou de suppression de contenu provenant de gouvernements

L'influence des gouvernements sur les décisions relatives au contenu peut conduire à de la censure et se révéler néfaste pour la liberté d'expression. Lorsqu'un état demande la suppression de contenu à huis clos, les utilisateurs ne savent pas si les décisions des plateformes concernant leur contenu sont dues à des considérations politiques. La transparence est l'un des bases de la confiance des utilisateurs et de la société civile envers les plateformes en ligne. Elle permet de débattre de manière ouverte pour savoir si l'action d'un gouvernement relève d'une réglementation légitime ou de la censure. Les plateformes comme les gouvernements sont également plus susceptibles de devoir rendre des comptes lorsque les utilisateurs connaissent la dynamique entre les gouvernements et les entreprises les plus puissantes du secteur en ligne.

Dans plusieurs cas, nous avons dénoncé le caractère aléatoire et opaque des demandes de suppression de contenu adressées à Meta par différents gouvernements (Publication partagée d'Al Jazeera, Isolement d'Öcalan, Musique drill britannique). La transparence autour de ces demandes est essentielle, afin que les utilisateurs sachent si les gouvernements ont signalé leur contenu directement à Meta pour que l'entreprise l'examine. Le cas de la musique drill au Royaume-Uni a révélé des erreurs de mise en application, entraînées par des demandes de suppression de la police londonienne (Metropolitan Police Service), qui ont conduit à une restriction excessive de l'expression artistique de personnes issues de groupes marginalisés. Dans le cas de l'isolement d'Öcalan, les utilisateurs ont été empêchés d'exprimer leurs préoccupations en matière de droits humains concernant un prisonnier du Parti des travailleurs du Kurdistan, détenu à l'isolement. En réponse à nos recommandations dans ce cas, Meta indique désormais à tous les utilisateurs dont le contenu a été supprimé à la demande d'un gouvernement que ce contenu a été supprimé et, sauf si la loi l'interdit, quelle entité gouvernementale a fait la demande.

Nous avons souligné l'importance pour les plateformes de révéler ces demandes gouvernementales, en recommandant à Meta de créer un système standardisé et de fournir des données sur les motifs de suppression de contenu dans ces cas. L'entreprise a confirmé publiquement avoir mis en place un nouveau système de signalement de contenu, avec des questions standard auxquelles les acteurs étatiques doivent répondre lorsqu'ils formulent de telles demandes. L'entreprise a également indiqué que 97 % des régulateurs éligibles ont été inclus dans ce système. Le fait que Meta pose une série de questions cohérentes au moment de la demande renforce la probabilité que les gouvernements respectent des règles cohérentes et réduit le risque de décisions politiques arbitraires.

Informer les utilisateurs des règles enfreintes par leur contenu

En vertu du droit international relatif aux droits humains, les individus doivent être informés des règles en vigueur et de la manière dont ils peuvent faire valoir leurs droits. Sur les plateformes Meta, les utilisateurs doivent être en mesure de comprendre quelle partie des Standards de la communauté leur contenu est censé avoir enfreinte et pourquoi des mesures de mise en application ont été prises à son encontre (Arméniens d’Azerbaïdjan, Symptômes du cancer du sein et nudité, Citation nazie, Représentation de Zwarte Piet, Insultes en Afrique du Sud, Breuvage à base d'ayahuasca, Partage d'informations privées sur le lieu de résidence). Cela permet aux utilisateurs d'adapter leur comportement lors de leur prochaine publication ou bien leur donne les moyens de présenter un appel convaincant. En réponse à nos recommandations incitant Meta à fournir ces informations aux utilisateurs, l'entreprise informe depuis 2024 les utilisateurs de la politique spécifique que leur contenu est censé avoir enfreinte lorsqu'elle prend une mesure de mise en application.

Expliquer publiquement le fonctionnement des algorithmes qui prédisent les infractions aux politiques

Afin de lever le voile sur le fonctionnement des classificateurs (un type d'algorithme) de Meta pour prédire si un contenu spécifique est susceptible d'enfreindre les règles, nous avons poussé l'entreprise à fournir une explication publique dans son Centre de transparence. Nous avons demandé des explications concernant les seuils de précision des prédictions du classificateur lorsqu'il ne prend aucune mesure sur le contenu, qu'il le soumet à un examen manuel ou qu'il le supprime sans examen manuel (Références à des personnes dangereuses désignées sous le terme « chahid »). En d'autres termes, nous avons poussé Meta à préciser le degré de certitude qu'un algorithme doit avoir concernant une infraction présumée pour que ce système automatisé ait le pouvoir de supprimer un contenu. L'entreprise n'a pas entièrement suivi toutes nos recommandations dans ce domaine.

Meta a toutefois répondu en ajoutant des informations aux pages pertinentes de son Centre de transparence, expliquant le fonctionnement de sa technologie d'application. Il y a un besoin évident d'améliorer encore la transparence concernant le fonctionnement des systèmes automatisés, la manière dont ils sont contrôlés et la façon dont leur précision est mesurée.

Formuler plus clairement les exceptions à la politique dans les Standards de la communauté

Certains Standards de la communauté Meta sont mis en œuvre avec des exceptions et des dérogations qui permettent aux utilisateurs de partager des discours dans certains contextes, même si ceux-ci semblent enfreindre la politique telle qu'elle est rédigée. Par exemple, ces exceptions peuvent autoriser certains contenus lorsqu'ils sont partagés dans le cadre d'un reportage ou d'une campagne de sensibilisation. Cependant, les utilisateurs sont lésés s'ils ne comprennent pas quelles exceptions s'appliquent à quels Standards de la communauté spécifiques. En vertu du droit international en matière de droits humains, les restrictions affectant la liberté d'expression doivent être formulées de manière claire, afin que les utilisateurs puissent bien comprendre les règles. Cette exigence n'est pas respectée lorsque les exceptions ne sont pas indiquées aux utilisateurs. Nous avons demandé à Meta de rectifier ce problème en créant une nouvelle section dans les Standards de la communauté, afin de définir les exceptions pertinentes (Documentaire sur des abus sexuels d'enfants au Pakistan). Au cours du premier semestre 2025, Meta a indiqué qu'elle évaluait toujours la viabilité de cette recommandation et qu'elle étudiait les méthodes permettant de clarifier les dérogations dans son Centre de transparence.

Meilleure gestion des enjeux majeurs et protection des communautés vulnérables

En temps de crise, on se rend souvent compte que les processus de modération habituels ne sont pas adaptés. Nos recommandations ont incité Meta à se montrer plus réactive dans les scénarios aux enjeux majeurs, tels que les élections et les conflits. En sachant que les plateformes Meta constituent, pour de nombreux utilisateurs à travers le monde, le principal moyen de trouver et de partager des informations, il est particulièrement important de défendre le droit des utilisateurs à la liberté d'expression. Cela comprend notamment le droit de communiquer et de recevoir des informations dans les situations de crise où ces connaissances peuvent constituer une question de vie ou de mort.

Par exemple, après avoir examiné plusieurs cas liés à la guerre à Gaza, le Conseil a défendu la liberté d'expression pour toutes les parties impliquées dans le conflit. En 2023, dans un cas traité en urgence (les décisions sont rendues dans les 30 jours suivant l'acceptation du cas), le Conseil a renversé la décision de Meta de supprimer une vidéo Facebook montrant un enlèvement lors de l'attaque terroriste menée par le Hamas contre Israël le 7 octobre. Le Conseil a également plaidé pour qu'elle soit rétablie en l'accompagnant d'un écran d'avertissement (Otages enlevés en Israël). Dans un cas de 2024, le Conseil a renversé les décisions de Meta de supprimer un reportage de la chaîne Channel 4 News (Royaume-Uni) sur le meurtre d'un enfant palestinien (Reportages sur la guerre à Gaza).

À la suite d'une recommandation du Conseil, Meta a mis en place un protocole de crise afin de garantir le respect des droits des utilisateurs, même dans des situations de tension extrême. Quand davantage de ressources et d'attention sont consacrées aux situations de crise, les utilisateurs ont tout à y gagner. Le contenu susceptible de causer un préjudice imminent est ainsi traité de manière plus rapide et les informations d'intérêt public ne sont plus supprimées par erreur.

L'entreprise a également mis en place un cadre permettant d'évaluer la manière dont elle traite les contenus pendant les élections, ainsi que des garde-fous plus efficaces autour du système de recoupement. Ce système a été créé par Meta afin d'éviter toute application excessive des règles pour les utilisateurs de premier plan ou ceux susceptibles de signaler des erreurs de suppression dans les médias ou directement auprès des dirigeants de l'entreprise.

Développer et publier une politique en matière de réponse de crise

Les plateformes de réseaux sociaux doivent être prêtes à répondre aux crises, qu'il s'agisse de conflits, de mouvements sociaux, d'élections contestées ou de catastrophes naturelles, afin de garantir la protection des droits des utilisateurs à la liberté d'expression, même dans des circonstances en évolution rapide et sous haute pression. Dans ces situations critiques, des processus supplémentaires sont nécessaires pour garantir une prise de décision rapide, équitable et cohérente en matière de contenu.

C'est pourquoi, au cours de notre première année d'activité, nous avons demandé à Meta de créer un protocole de politique de crise (CPP), afin que l'entreprise soit prête à agir rapidement en cas de besoin (Suspension de l'ancien président américain Trump). À la suite d'un grand forum sur les politiques réunissant différentes parties prenantes, Meta a créé le CPP en août 2022, puis a ajouté une page concernant ce mécanisme dans son Centre de transparence. Le CPP est un cadre visant à renforcer la modération en cas de crise et à harmoniser l'application des politiques à l'échelle mondiale. Le protocole est activé lorsque des critères prédéfinis identifient la survenue d'une situation à haut risque. Il met alors davantage d'outils à disposition des équipes, pour leur permettre de prendre des décisions plus rapidement. Ce domaine reste une priorité pour le Conseil, car nous avons récemment recommandé des modifications permettant une activation plus réactive du CPP et demandé d'accorder aux modérateurs de contenu une plus grande marge de manœuvre, afin qu'ils puissent prendre des décisions de manière autonome en fonction du contexte dans les situations à haut risque (Publications soutenant les émeutes au Royaume-Uni, Publications partageant des discours dans le cadre du conflit syrien).

Créer un cadre pour mesurer les efforts en matière d'intégrité électorale

Pendant les élections, les plateformes doivent être prêtes à assumer leurs responsabilités afin de permettre l'expression politique tout en évitant les risques graves pour les droits humains, et notamment pour le droit de vote. Cependant, en l'absence d'un cadre cohérent sur lequel l'entreprise se base pour se préparer aux élections, il est difficile de déterminer si les mesures prises par l'entreprise sont suffisantes pour ces événements. En 2023, nous avons souligné que Meta devrait élaborer un cadre pour garantir l'intégrité des élections et rendre compte publiquement de ces efforts (Discours d'un général brésilien). Nous avons exhorté Meta à s'appuyer sur les connaissances locales pour identifier les campagnes coordonnées en ligne et hors ligne visant à perturber les processus démocratiques et à mettre en place des canaux de retour d'information permanents. Ces efforts permettraient de poursuivre l'amélioration de la réponse apportée dans le cadre d'élections qui restent marquées par la violence politique.

En juin 2025, Meta a confirmé avoir implémenté la recommandation du Conseil et élaboré un cadre composé de huit piliers fondamentaux en matière d'intégrité électorale. Ces derniers seront appliqués à tous les suivis des élections, afin d'inclure des facteurs tels que la gestion des risques, la coopération avec des parties prenantes externes, la réduction de la propagation de fausse information et une approche responsable en matière d'IA générative. Bien que nous n'ayons pas encore vu ce cadre en action et que nous n'ayons pas pu évaluer son efficacité, l'annonce de sa création reste un pas dans la bonne direction.

Mettre en place des garde-fous plus efficaces autour du système de recoupement

Le système de recoupement de Meta est un programme conçu pour mettre en place des contrôles supplémentaires avant de supprimer les contenus à fort impact, c'est-à-dire les contenus provenant de comptes influents ou les contenus qui sont devenus viraux. Le Conseil a toutefois exprimé de sérieuses préoccupation au sujet du système de recoupement, qui implique que l'entreprise traite différemment ses utilisateurs les plus puissants en faisant preuve d'opacité, le tout au détriment de ses utilisateurs standard. L'existence du système de recoupement a été révélée par un lanceur d'alerte de Facebook. En réponse à ces révélations, le Conseil a entrepris un examen approfondi du programme, profitant de l'occasion pour demander à l'entreprise de lui fournir des informations et analyser ces dernières. Nos efforts ont ainsi permis, pour la première fois, d'expliquer les mécanismes et implications de ce programme de manière transparente au public. En réponse à notre avis consultatif en matière de politiques concernant le programme, Meta a admis devant le Conseil que « l'absence de gouvernance » autour de ces pratiques avait permis à certains utilisateurs d'échapper à des mesures de mise en application.

Nous avons formulé 32 recommandations visant à mettre en place des garde-fous plus efficaces autour du système de recoupement et à garantir une plus grande équité envers les utilisateurs. Ces recommandations concernaient les aspects suivants : la rapidité de l'application et la qualité de l'examen ; la manière dont l'éligibilité au recoupement est déterminée ; la transparence sur le fonctionnement du programme ; et l'intégration des droits humains dans le programme, y compris le droit de faire appel.

Par exemple, quand une publication venant d'un utilisateur figurant sur les listes de recoupement était identifiée comme enfreignant les politiques de Meta, ce contenu restait publié pendant plusieurs jours, en vertu du système de recoupement, le temps qu'un examen supplémentaire soit réalisé. C'est pourtant durant cette période que le contenu en infraction atteint des pics de diffusion, et donc est le plus dangereux, particulièrement s'il s'agit d'images intimes diffusées dans un objectif de vengeance (phénomène connu sous le nom de « revenge porn ») ou de menaces crédibles. Nous avons recommandé à Meta d'établir des critères plus clairs en matière d'éligibilité et de transparence pour déterminer qui a droit à des examens supplémentaires et dans quelles circonstances. En réponse, Meta a modifié la manière dont la liste d'éligibilité est établie, vérifiée et contrôlée. Meta a également pris des mesures pour éliminer les retards dans le processus d'examen, ce qui a permis de réduire considérablement le nombre de vues des contenus potentiellement en infraction.

L'une de nos principales recommandations insistait sur le fait que Meta doive rattraper son retard sur les examens en attente. En effet, le nombre d'examens en attente au moment où la recommandation a été formulée impliquait que les publications d'utilisateurs de premier plan pouvaient rester sur la plateforme pendant des semaines, voire des mois, avant d'être jugées comme étant en infraction et supprimées. L'entreprise a travaillé sur cette question et a communiqué les données suivantes au Conseil : pour 90 % des tâches créées dans la file d'attente de recoupement de l'entreprise au cours du premier semestre de l'année 2023, le temps de résolution (temps nécessaire à l'examen et à toute application ultérieure) a diminué de 96 % par rapport au second semestre de l'année 2022.

Examiner les préjugés de la modération du contenu

Les perceptions d'injustice et de parti pris dans la modération des opinions politiques peuvent menacer la légitimité de la gouvernance des plateformes. Ces partis pris peuvent provenir de plusieurs facteurs, tels que des politiques obsolètes ou trop peu nuancées, un sous-investissement dans les compétences linguistiques et la compétence culturelle, ainsi que des erreurs répétées de mise en application. Au fil du temps, les systèmes tirent de mauvaises leçons des décisions passées et les implémentent, créant ainsi des schémas cycliques. Dans un cas, nous avons constaté que la suppression erronée de contenus présentant des positions opposées sur la question de l'avortement perturbait le débat politique (Publications aux États-Unis sur la question de l'avortement, page en anglais). Le Conseil a recommandé à Meta de publier régulièrement les données utilisées par l'entreprise pour évaluer la pertinence de ses mesures de mise en application liées à sa politique en matière de violence et d'incitation. Meta n'a pas fourni les données demandées, alors que cette diffusion permettrait de déterminer si les erreurs d'application relatives à ce cas (suppression d'un contenu qui n'enfreignait pas la politique) étaient de nature isolée ou bien faisaient partie d'un problème à l'échelle du système.

Dans un autre cas, qui répondait aux préoccupations du public concernant le parti pris de Facebook dans la modération de contenus palestiniens et israéliens, le Conseil a recommandé qu'un tiers examine la question du parti pris systémique dans la modération de contenu en relation avec le conflit sur la plateforme (Publication partagée d'Al Jazeera). Meta a alors commandé un rapport à Business for Social Responsibility, un organe consultatif, qui a indiqué que la modération de contenu par Facebook pendant le conflit israélo-palestinien de mai 2021 semblait avoir eu un impact négatif sur les droits humains et la liberté d'expression des utilisateurs palestiniens. Une grande partie des partis pris identifiés est liée à un manque de compétences linguistiques internes et à de mauvaises directives données par l'entreprise à ses modérateurs de contenu. Les capacités linguistiques limitées ont également contribué à la sous-application des mesures contre les contenus antisémites. En 2022, Meta a publié une réponse, indiquant qu'elle embaucherait davantage de modérateurs de contenu capables d'examiner les contenus dans les dialectes pertinents et qu'elle avait déployé un classificateur à apprentissage automatique en hébreu.

Protéger les communautés vulnérables

Le Conseil n'a jamais cessé de lutter pour protéger les communautés vulnérables, telles que les défenseurs des droits humains et les leaders de l'opposition dans les régimes répressifs, des préjudices en ligne. Les décisions du Conseil ont abouti à la suppression de publications portant préjudice aux personnes transgenres et incitant à la violence homophobe.

Renversant la décision de Meta de laisser en ligne une vidéo Facebook dans laquelle Hun Sen, alors premier ministre du Cambodge, menaçait ses opposants politiques de violences, le Conseil a conclu en juin 2023 que le fait de laisser ce contenu en ligne était contraire aux responsabilités de l'entreprise en matière de droits humains (Premier ministre cambodgien).

En 2024, lors du renversement de la décision de Meta de laisser une publication dans laquelle un utilisateur incitait les personnes transgenres à se suicider, le Conseil a demandé à l'entreprise de renforcer son application des politiques pour ce type de discours non textuels. Dans ce cas, le Conseil a estimé que le contenu associait des références partiellement codées au suicide à une représentation visuelle (drapeau transgenre) d'un groupe caractéristique protégé, prenant ainsi la forme d'une « créativité malveillante ». Ce terme fait référence à l'utilisation intentionnelle d'un langage codé ou de memes visuels/textuels qui nécessitent un contexte pour être compris. Ce type de contenu est souvent employé par des personnes qui tentent d'échapper à la détection sur les réseaux sociaux (Publication en polonais ciblant les personnes trans).

Nous avons identifié des défaillances systémiques dans l'application des règles par Meta dans le cas d'une vidéo qui enfreignait quatre Standards de la communauté différents. Cette vidéo, qui montrait des hommes qui avaient été battus pour être, prétendument, homosexuels au Nigeria, un pays qui criminalise les relations entre personnes du même sexe, a été examinée par trois modérateurs mais est restée en ligne sur les plateformes de Meta, exposant ainsi ces hommes à un danger immédiat en révélant leur identité. Le Conseil a renversé la décision initiale de Meta de laisser la vidéo en ligne (Violence homophobe en Afrique de l'Ouest).

Dans plusieurs cas, et notamment une décision de 2023 concernant une vidéo publiée sur Facebook montrant des prisonniers de guerre identifiables, le Conseil a recommandé à Meta de conserver les contenus représentant des violations graves des droits humains ou des crimes atroces, tels que définis par le droit international, et, le cas échéant, de les partager avec les autorités compétentes, telles que les tribunaux internationaux (Vidéo de prisonniers de guerre arméniens). Dans sa réponse au Conseil, Meta a indiqué avoir mis en œuvre cette recommandation.

Intégrer les principes des droits humains à l'IA et à l'automatisation

Le Conseil a commencé à étudier certains des systèmes automatisés et d'IA de Meta, en signalant les défaillances systémiques détectées et en attirant l'attention sur les domaines dans lesquels la technologie d'application ne fonctionne pas correctement.

Afin de garantir une utilisation équitable et efficace des outils d'IA et de l'automatisation pour appliquer les politiques, organiser et créer du contenu, nous estimons qu'il est essentiel d'intégrer les principes des droits humains à la conception et au déploiement de ces outils.

Les étiquettes IA donnent aux utilisateurs les outils dont ils ont besoin

Dans plusieurs cas, le Conseil a recommandé d'étiqueter le contenu généré par l'IA. Cette recommandation a pour but de protéger la liberté d'expression des utilisateurs tout en leur donnant les outils nécessaires pour mieux évaluer l'authenticité et le message sous-jacent d'un contenu (Vidéo modifiée du président Biden, page en anglais).

En réponse aux recommandations du Conseil, Meta indique avoir ajouté des étiquettes « Informations sur l’IA » à toute une série de vidéos, d’enregistrements audio et d’images créés ou modifiés par l'IA sur Facebook, Instagram et Threads. Par exemple, sur une période 29 jours au mois d’octobre 2024, les utilisateurs ont consulté plus de 360 millions de contenus avec des étiquettes IA sur Facebook et 330 millions sur Instagram. Parmi ceux-ci, les utilisateurs ont cliqué les étiquettes de 6 millions de publications sur Facebook et de 13 millions de publications sur Instagram, afin d’en savoir plus sur la manière dont le contenu avait été créé.

Un nouveau classificateur tient mieux compte des signaux textuels dans l'application automatisée des règles relatives aux images

Compte tenu de l'ampleur des réseaux sociaux, la modération automatisée du contenu est essentielle pour faire respecter les standards et protéger les utilisateurs de tout préjudice. L'automatisation peut toutefois conduire à des situations où des contenus légitimes et non contraires aux règles sont supprimés parce que les systèmes automatisés ont du mal à comprendre le contexte (par exemple, un contenu de sensibilisation ou une satire) qu'un modérateur humain compétent serait capable de discerner. Le Conseil a abordé cette question dès ses premiers cas.

En 2021, nous avons constaté que les systèmes automatisés de Meta ne reconnaissaient pas les publications de sensibilisation au cancer du sein lorsqu'elles contenaient des images avec du texte superposé (Symptômes du cancer du sein et nudité). Nous avons fait part de nos préoccupations concernant la suppression erronée de ce type de contenu. Meta a répondu en déployant un nouveau classificateur de contenu santé afin d'améliorer les techniques d'Instagram pour identifier les publications sur le cancer du sein. Sur une période de 28 jours en 2023, 1 000 contenus supplémentaires liés au cancer du sein ont été soumis à un examen manuel, au lieu d'être simplement supprimés. Meta a depuis indiqué que ce classificateur avait non seulement amélioré la modération de ce type de contenu, mais aussi, plus largement, l'application des règles relatives aux images accompagnées de texte. Le Conseil continue d'encourager Meta à s'améliorer dans ce domaine et à renforcer sa capacité à appliquer ses politiques avec précision à grande échelle (Contenu de sensibilisation au cancer du sein).

Les recommandations que nous formulons à Meta évoluent afin de tenir compte de la nature changeante du contenu créé par l'IA et des préjudices potentiels et notamment de la façon dont les politiques de Meta s'adaptent à l'évolution de la situation.

Notre indépendance est bénéfique pour les utilisateurs

En l'espace de cinq années seulement, le Conseil est passé d'expérience audacieuse à modèle reconnu. Il dispose d'un ensemble croissant de décisions raisonnées et fondées sur des principes, qui a donné naissance à un modèle unique en son genre permettant d'appliquer les principes des droits humains au contenu en ligne. De nombreuses plateformes disposent d'organes consultatifs. Le Conseil est unique en son genre, car nous sommes juridiquement indépendants de Meta, nous rendons des décisions et des recommandations contraignantes auxquelles l'entreprise est tenue de répondre, et nous sommes composés d'experts diversifiés provenant du monde entier. Bien sûr, toute nouvelle expérience sera inévitablement confrontée à des défis liés à la gestion des impératifs d'une entreprise mondiale à but lucratif, dont les produits sont utilisés au quotidien par des milliards d'utilisateurs à travers le monde.

Voici quelques-unes des leçons que nous avons tirées de notre expérience :

- Faire des droits humains internationaux le pilier d'une prise de décision cohérente et équitable : l'intégration d'un cadre mondial en matière de droits humains à un modèle de conseil de surveillance indépendante favorise une prise de décision cohérente et fondée sur des principes. Le Conseil analyse l'approche de Meta en matière de modération de contenu en s'appuyant sur les loi internationales sur les droits humains, et communique ouvertement les traités et dispositions clés qui ont guidé ses décisions. Les conditions analytiques préalables et les tests définis par le droit international relatif aux droits humains contribuent à garantir que nos décisions restent cohérentes et applicables à long terme. La protection solide de la liberté d'expression est une des pierres angulaires de ce cadre mondial reconnu, qui autorise également certaines restrictions à la liberté d'expression afin de tenir compte d'autres objectifs importants, tels que la protection des droits d'autrui, la sécurité nationale ou l'ordre public. Les compétences du Conseil en matière de droit international relatifs aux droits humains nous permettent de prendre des décisions et de formuler des recommandations applicables à l'échelle mondiale, dans toutes les juridictions. L'extrapolation des obligations conçues pour des gouvernements à une entreprise privée nécessite un certain degré d'interprétation et d'imagination. Plus que quiconque, et ce quel que soit le secteur, le Conseil a établi ces liens et élaboré un modèle pratique pour concrétiser les obligations des entreprises en matière de droits humains.

- Conserver son indépendance structurelle : un organe de surveillance doit être indépendant, tant sur le plan juridique qu'institutionnel et fonctionnel, des entreprises et des gouvernements afin de garantir que ses décisions ne soient pas influencées par des intérêts commerciaux ou étatiques. Comme c'est le cas pour le Conseil, cette indépendance devrait inclure un mécanisme de financement durable, permettant à l'entité d'assumer la responsabilité de son propre budget, de sa direction, de sa stratégie et de ses opérations. Grâce à la fiducie irrévocable du Conseil, nos opérations sont entièrement financées jusqu'en 2027. Les évaluations et les verdicts du Conseil sont indépendants, mais nous comptons sur la coopération de Meta, notamment pour répondre à nos questions lorsque nous délibérons sur les cas, fournir les informations nécessaires à une prise de décision éclairée, accepter nos recommandations et nous informer de l'impact de nos recommandations sur les politiques de l'entreprise, afin que nous puissions mesurer notre efficacité.

- Encourager un engagement ferme en faveur de la mise en œuvre : les organes de surveillance renforcent leur impact lorsqu'ils mettent en place des processus rigoureux pour contrôler la mise en œuvre de leurs décisions et disposent des informations nécessaires à cet effet. Les décisions du Conseil relatives au maintien ou à la suppression de contenus individuels sont contraignantes pour Meta, comme le stipule notre charte. Nous formulons également des recommandations non contraignantes, dont le but est d'améliorer la manière dont Meta modère les contenus. L'entreprise dispose de 60 jours pour y répondre. L'équipe chargée des données du Conseil a développé sa propre méthodologie de recherche afin de suivre de manière indépendante la mise en œuvre de nos recommandations par Meta. Vous pouvez retrouver cette méthodologie sur notre site web. Cette méthodologie se distingue des rapports réalisés par Meta, pour lesquels l'entreprise est obligée de nous fournir des preuves de mise en œuvre. Nous pouvons ainsi partager notre propre évaluation des réponses de l'entreprise. Il arrive parfois que Meta refuse d'implémenter nos recommandations. Même dans ces cas-là, nous pensons que, dans certaines situations au moins, le fait de mettre en lumière les problèmes et de rendre publiques davantage d'informations sur les pratiques de Meta peut sensibiliser le public et l'entreprise, ce qui finit par inciter cette dernière à corriger la situation. Notre travail peut également permettre à la société civile et à d'autres acteurs de dialoguer avec Meta sur les moyens qu'elle peut employer pour poursuivre l'amélioration de ses pratiques.

- Donner aux décideurs du monde entier les outils dont ils ont besoin : pour refléter la nature mondiale des plateformes de réseaux sociaux, les organes de surveillance ont tout intérêt à solliciter des avis provenant de différentes régions du monde pour leur processus décisionnel. Les points de vue des 21 membres de notre Conseil ont été utiles pour garantir la prise en compte des contextes critiques et des facteurs régionaux avant que des décisions cruciales ayant un impact sur les utilisateurs du monde entier ne soient prises. Nous faisons également des efforts concertés pour contacter les parties prenantes concernées et les groupes de la société civile du monde entier afin qu'ils nous fassent part, par écrit, de leur avis sur nos cas et participent à des tables rondes avec le Conseil afin que nous puissions prendre des décisions plus éclairées. Ce dialogue peut également être utile lorsqu'il s'agit d'examiner les différentes réalités réglementaires liées aux droits des utilisateurs sous un prisme international.

- Tenir compte des droits des personnes qui dépendent le plus des plateformes : les parties prenantes qui dépendent des services d'une plateforme ou sont affectées par ces derniers, doivent avoir la possibilité de donner leur avis. Leur offrir cette possibilité peut renforcer la légitimité de ces organes. Ces canaux doivent être accessibles et inclusifs, afin d'encourager les organisations et les personnes susceptibles d'avoir rencontré des problèmes pour interagir directement avec les plateformes elles-mêmes à partager leur point de vue. L'analyse du Conseil dans ses cas est consolidée par les contributions des parties prenantes externes, fournies par le biais d'un système reconnu de commentaire public. En recherchant de manière proactive la participation de ces groupes, nous avons reçu plus de 11 000 commentaires publics de la part de chercheurs, d'organisations et d'individus, qui nous ont aidés à donner forme à nos décisions et à pousser Meta à assumer ses responsabilités en matière de droits humains.

- Favoriser l'intégration de la sécurité dès la conception : d'un point de vue économique, il est judicieux de solliciter dès le début l'avis d'un organe de surveillance indépendante sur les innovations en matière de produit, les fonctionnalités des plateformes et les technologies de modération du contenu, car cela contribue à relever la qualité des standards et à encourager l'adoption de meilleures pratiques. Le Conseil estime qu'il est essentiel d'intégrer les principes des droits humains dès les phases de développement des technologies en rapide évolution. À ce jour, nous avons traité différents problèmes de conception liés aux fonctionnalités des plateformes Meta dans nos recommandations et avons identifié des opportunités d'amélioration pour quelques produits Meta. Toutefois, dans un secteur à l'évolution frénétique, où les opportunités de croissance s'accompagnent également de risques pour les droits des utilisateurs, il s'avère nécessaire de permettre à un organe de surveillance d'étendre son champ d'action de manière aussi réactive que possible, afin de relever avec succès les défis éthiques et systémiques.

L'évolution du Conseil : un regard vers l'avenir

Au cours des cinq années pendant lesquelles le Conseil a accepté les appels, les plateformes de réseaux sociaux et la manière dont les utilisateurs interagissent avec elles ont considérablement changé. Pendant cette période et dans le cadre de nos efforts pour trouver un équilibre entre notre engagement fort en faveur de la liberté d'expression et notre souci de respecter les autres droits humains, le travail du Conseil a mis en lumière plusieurs points hautement controversés en matière de modération de contenu. Nous avons rendu des décisions concernant des élections mondiales, des conflits et des débats sociétaux, examiné la conception des systèmes d'application et mis en évidence les problèmes systémiques affectant les plateformes de Meta.

Notre champ d'action a également évolué, pour inclure à la fois le contenu restauré et supprimé sur Facebook et Instagram, l'application d'écrans d'avertissement et une troisième plateforme, Threads. En 2026, notre champ d'action s'élargira une nouvelle fois, puisque nous lancerons un projet pilote d'examen des décisions de Meta concernant la suppression de comptes et les sanctions affectant ces derniers, qui se sont révélées être une source de frustration constante pour les utilisateurs de la plateforme.

Depuis l'annonce de la création du Conseil, nous avons pris conscience de l'ampleur de la tâche qui nous attendait et avons pris au sérieux les préoccupations des personnes sceptiques et des détracteurs qui doutaient de la légitimité et de l'efficacité de nos efforts. Au cours des cinq dernières années, nous avons connu des frustrations et des moments où l'impact escompté ne s'est pas concrétisé. Nous avons appris à nous concentrer sur l'utilisation des pouvoirs et de l'influence dont nous disposons pour avoir le plus d'impact possible. Nous sommes les seuls à avoir le pouvoir de demander des informations à Meta, d'obtenir des réponses à nos questions et à nos recommandations et de dialoguer avec les dirigeants de l'entreprise. Aucune autre entité ne dispose d'un accès de ce type. Nous continuerons à utiliser ces outils pour essayer de lever le voile pour les utilisateurs et leur permettre de mieux comprendre une entreprise qui influence tant leur vie. Lorsque nos décisions et recommandations sont implémentées, elles donnent à des milliards de personnes du monde entier plus de pouvoir pour s'exprimer et se protéger en ligne.

Ce que l'avenir nous réserve : au-delà de la modération de contenu

En 2024, nous avons commencé à rédiger de manière plus formelle certaines de nos conclusions, au-delà des simples cas individuels, et à les intégrer à des livres blancs. Nous avons également publié nos observations sur les élections et sur la nouvelle ère de l'IA et de l'automatisation. Plus récemment, le Conseil a engagé un dialogue plus poussé sur la gouvernance des contenus et la responsabilisation des plateformes, afin de faire progresser la manière dont la liberté d'expression est prise en compte dans les évaluations des risques systémiques menées dans le cadre des nouvelles réglementations de l'Union européenne.

Notre engagement à examiner les implications des technologies en constante évolution sur les droits humains, tant en matière de modération de contenu qu'au-delà, orientera les futures missions du Conseil. En s'appuyant sur les connaissances acquises dans le domaine des technologies d'application, de l'automatisation et de l'IA, le Conseil élargira son champ d'action afin d'examiner plus en détail le déploiement responsable des outils et produits basés sur l'IA. Par exemple, à mesure que les plateformes technologiques poursuivent la conception et le développement de produits d'IA générative, tels que les chatbots basés sur les grands modèles de langage et l'IA agentique, nous étudierons comment intégrer efficacement la prise en compte des droits humains à la conception et au développement de ces technologies. Et alors que l'IA générative transforme la nature même du contenu en ligne, nous réfléchirons aux directives susceptibles d'aider le secteur à lutter contre les nouveaux préjudices associés à sa création, dont beaucoup reflètent les préjudices déjà traités par le Conseil dans le contexte des réseaux sociaux. Nous espérons que notre contribution à ces discussions essentielles pour le secteur permettra de tracer la voie à suivre, dans le respect international des droits des utilisateurs.

Le Conseil est également bien placé pour établir des partenariats avec diverses entreprises technologiques internationales confrontées à des questions issues des débats sur la liberté d'expression dans le monde entier, notamment lorsque la pression exercée par les gouvernements sur les plateformes entraîne un effet de censure en ligne. Nous nous intéresserons également aux défis considérables liés à l'expérience des plus jeunes utilisateurs sur les plateformes de réseaux sociaux. Comment protéger leurs droits à la liberté d'expression et à l'accès à l'information en ligne, tout en les protégeant contre les abus et l'exploitation ?

Ces défis majeurs exigent l'engagement d'un large éventail de perspectives mondiales, afin de garantir le respect des droits, tels que la liberté d'expression, au-delà des clivages politiques et d'assurer la responsabilité continue des plateformes envers leurs utilisateurs. Le Conseil se réjouit de jouer un rôle dans le rapprochement de ces perspectives, en proposant des recommandations qui permettront de traiter certains des dilemmes politiques et éthiques les plus difficiles auxquels le secteur technologique sera confronté dans les mois et les années à venir.